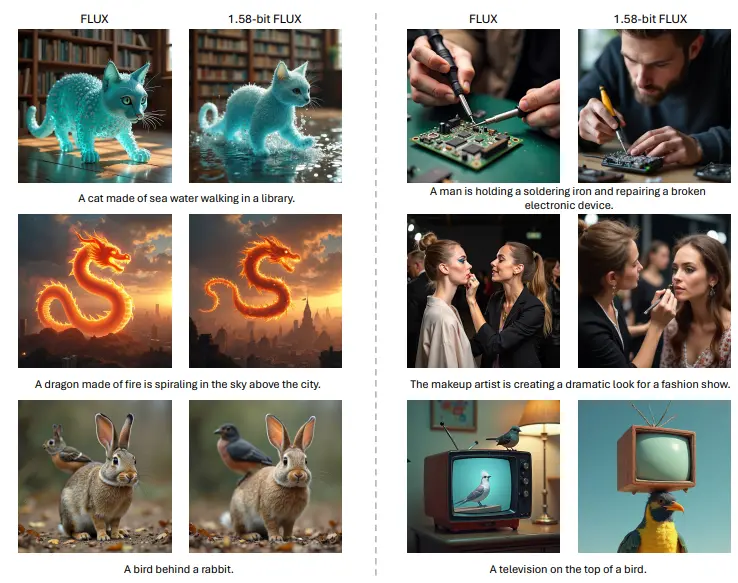

字节跳动和浦项科技大学的研究人员推出1.58-bit FLUX,这是第一个成功将最先进的文本到图像生成模型FLUX.1-dev量化到1.58位权重的方法。通过这种方法,我们能够在不损失生成质量的情况下,显著降低模型的存储需求和推理内存使用。具体来说,1.58-bit FLUX将视觉变换器中的99.5%参数(共11.9亿个)限制在{+1, 0, -1}的值范围内,并且不依赖于图像数据进行训练。此外,开发团队还开发了一个针对1.58位操作优化的自定义内核,实现了模型存储减少7.7倍、推理内存减少5.1倍以及推理延迟的改善。

主要特点

- 极端量化:模型参数从原始的16位精度量化到1.58位,即参数值限制在-1、0和+1之间。

- 无需图像数据:量化过程完全不需要额外的图像数据,依赖于模型自身的自监督。

- 定制计算核心:为了优化1.58位操作,开发了专门的计算核心,显著降低了模型存储和推理内存的使用。

- 保持性能:尽管模型参数大幅减少,但在图像生成质量上与全精度模型相当。

工作原理

1.58-bit FLUX的工作原理基于后训练量化技术,它将模型中的权重参数量化为1.58位,即用2位有符号整数存储,从而实现模型压缩。这种量化方法不依赖于混合精度方案或图像数据,而是作为一种后训练量化解决方案。通过这种量化,模型存储减少了7.7倍,推理内存使用减少了5.1倍以上。此外,通过引入定制的计算核心,进一步优化了低比特计算,提高了推理效率。

具体应用场景

1.58-bit FLUX的应用场景包括但不限于:

- 移动平台:由于模型大小和内存需求的大幅降低,1.58-bit FLUX非常适合在资源受限的移动设备上部署。

- 实时应用:在需要快速生成图像的应用中,如增强现实(AR)和虚拟现实(VR)中,1.58-bit FLUX可以提供更快的推理速度。

- 在线服务:在需要处理大量文本到图像转换请求的在线服务中,1.58-bit FLUX可以提高服务的响应速度和处理能力。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...