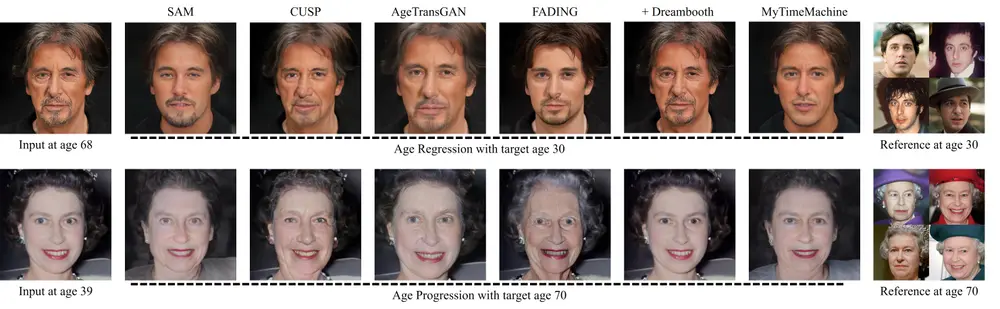

面部老化是一个复杂的过程,受到多种因素的影响,如性别、种族、生活方式等。尽管现有的面部老化技术能够生成逼真的老化图像,但它们通常无法准确预测特定个体的老化过程,因为这些技术缺乏个性化处理。为了克服这一挑战,北卡罗来纳大学教堂山分校和马里兰大学的研究人员提出了MyTimeMachine(MyTM),这是一种新的个性化面部老化方法。这项技术能够根据个人特定的照片集合(大约50张跨越20-40年时间范围的照片)来训练一个个性化的年龄转换模型,实现从儿童到老年的个性化面部年龄变化。

例如,我们有一系列关于某位名人从年轻到老年的照片,MyTimeMachine可以学习这位名人随时间变化的面部特征,并能够生成该名人在任意目标年龄的面部图像。例如,我们可以将一个70岁的人的照片转换为30岁时的样子,或者预测一个40岁的人在未来20年后的外貌。

主要功能:

个性化年龄回归(De-aging):将老年人的面部图像转换为年轻时的样子。 个性化年龄进展(Aging):将年轻人的面部图像转换为年老时的样子。

主要特点:

个性化学习:利用个人照片集合来训练模型,以捕捉和再现个人特定的老化特征。 风格一致性:生成的图像不仅年龄发生变化,还能保持原始图像的风格和身份特征。 高质量生成:使用StyleGAN2等先进技术生成高分辨率和高质量的结果。 扩展到视频:技术可以扩展到视频领域,实现视频中人物年龄的连续变化。

方法概述

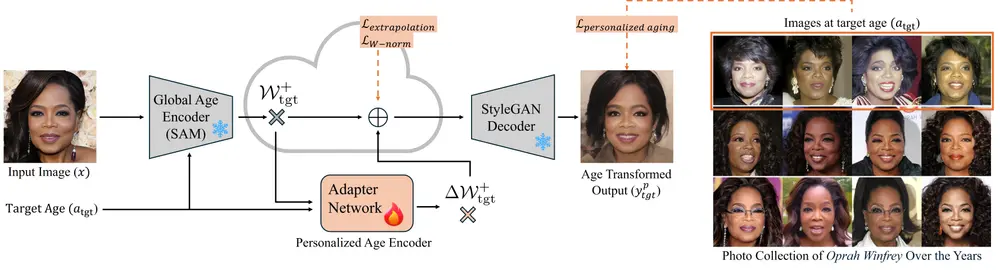

MyTimeMachine 结合了全局老化先验和个人照片集,以学习个性化的年龄转换。具体来说,该方法包括以下几个关键组件:

全局老化先验:使用预训练的全局老化模型作为基础,该模型能够生成逼真的老化图像,但缺乏个性化特征。 个人照片集:收集用户在不同年龄段的照片集,通常需要至少50张图像,以提供足够的个性化信息。 适配器网络(Adapter Network):一种新颖的神经网络,用于将个性化老化特征与全局老化特征结合。适配器网络通过学习用户的个性化特征,使得生成的老化图像更加贴近用户在目标年龄的实际外观。 生成模型:使用StyleGAN2作为生成模型,生成高质量的老化图像。

MyTimeMachine的核心是一个适配器网络(Adapter Network),它结合了全局老化先验和个人照片集合来学习个性化的年龄转换。这个网络通过以下步骤工作:

特征提取:使用预训练的StyleGAN2模型提取输入图像的潜在特征。 适配器网络调整:适配器网络学习如何调整全局老化特征以匹配个人特定的老化模式。 损失函数优化:通过个性化老化损失、外推正则化和自适应w-范数正则化等损失函数来训练适配器网络。 生成年龄转换图像:结合个性化特征和全局特征,通过StyleGAN2生成最终的年龄转换图像。

损失函数

为了个性化适配器网络,研究人员引入了三种损失函数:

个性化老化损失:确保生成的老化图像在视觉上与用户在目标年龄的照片相似。 外推正则化:防止适配器网络在处理超出训练数据范围的年龄时过拟合。 自适应w-范数正则化:控制适配器网络的复杂度,防止过拟合并提高泛化能力。

应用场景

MyTimeMachine 不仅适用于静态图像,还可以扩展到视频,实现高质量、保留身份且时间上一致的老化效果。这种技术在电影和电视节目的视觉特效中具有广泛的应用前景,能够生成更真实、更个性化的老化效果。

实验结果

研究人员通过多个实验验证了MyTimeMachine的有效性:

图像生成:生成的老化图像在视觉上与用户在目标年龄的照片非常相似,展示了高度的个性化和准确性。 视频处理:在视频中应用MyTimeMachine,生成的老化效果时间上一致,保留了用户的身份特征,展示了该方法在动态内容中的优势。 比较实验:与现有技术相比,MyTimeMachine生成的老化图像在个性化和真实性方面表现更优。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...