面壁智能昨日开源了 MiniCPM-V 2.6 模型,官方表示将端侧 AI 多模态能力拉升至全面对标 GPT-4V 水平。MiniCPM-V是面向图文理解的端侧多模态大模型系列。该系列模型接受图像和文本输入,并提供高质量的文本输出。自2024年2月以来,面壁智能共发布了5个版本模型,旨在实现领先的性能和高效的部署。

- GitHub: https://github.com/OpenBMB/MiniCPM-V

- 模型:https://huggingface.co/openbmb/MiniCPM-V-2_6

- Demo:https://huggingface.co/spaces/openbmb/MiniCPM-V-2_6

目前该系列最值得关注的模型包括:

MiniCPM-V 2.6: MiniCPM-V系列的最新、性能最佳模型。总参数量 8B,单图、多图和视频理解性能超越了 GPT-4V。在单图理解上,它取得了优于 GPT-4o mini、Gemini 1.5 Pro 和 Claude 3.5 Sonnet等商用闭源模型的表现,并进一步优化了 MiniCPM-Llama3-V 2.5 的 OCR、可信行为、多语言支持以及端侧部署等诸多特性。基于其领先的视觉 token 密度,MiniCPM-V 2.6 成为了首个支持在 iPad 等端侧设备上进行实时视频理解的多模态大模型。

官方称 MiniCPM-V 2.6 模型仅 8B 参数,取得 20B 以下单图、多图、视频理解 3 SOTA 成绩,有以下特点:

“三合一最强”端侧多模态:首次在端侧实现单图、多图、视频理解等多模态核心能力全面超越 GPT-4V,单图理解越级比肩多模态王者 Gemini 1.5 Pro 和新晋顶流 GPT-4o mini

多项功能首次上端:实时视频理解、多图联合理解、多图 ICL 视觉类比学习、多图 OCR 等功能

最高多模态像素密度:类比知识密度,小钢炮 2.6 取得了两倍于 GPT-4o 的单 token 编码像素密度(token density)

端侧友好:量化后端侧 6G 内存可用;端侧推理速度达 18 tokens / s,相比上代模型快 33%。发布即支持 llama.cpp、ollama、vllm 推理;且支持多种语言

统一高清框架:小钢炮的传统优势 OCR 能力延续了其 SOTA 性能水平,并进一步覆盖单图、多图、视频理解

MiniCPM-V 2.6 是 MiniCPM-V 系列中最新、性能最佳的模型。该模型基于 SigLip-400M 和 Qwen2-7B 构建,共 8B 参数。与 MiniCPM-Llama3-V 2.5 相比,MiniCPM-V 2.6 性能提升显著,并引入了多图和视频理解的新功能。MiniCPM-V 2.6 的主要特点包括:

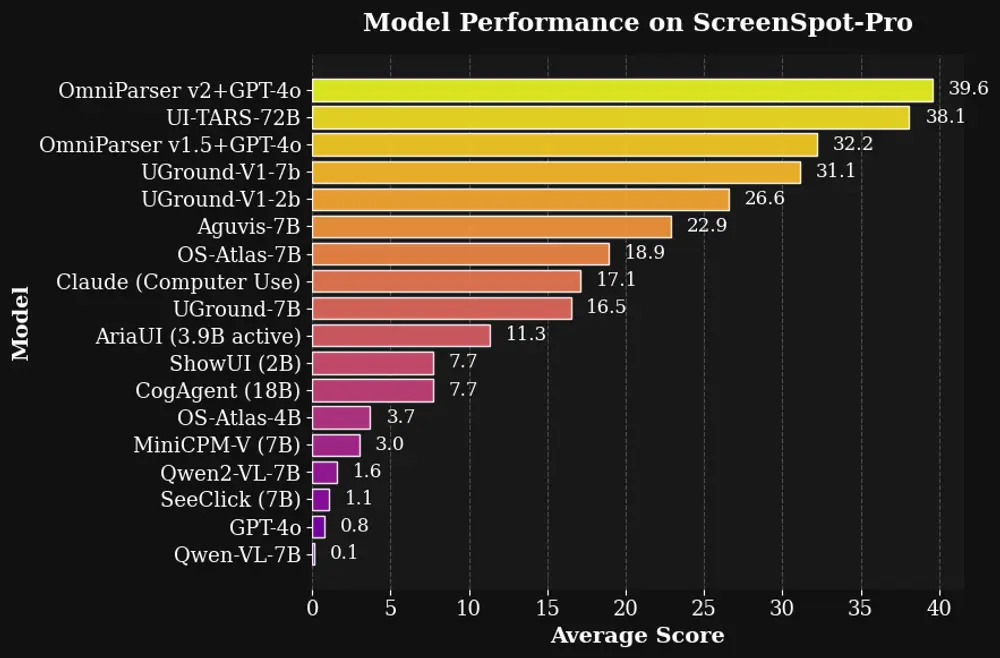

领先的性能。 MiniCPM-V 2.6 在最新版本 OpenCompass 榜单上(综合 8 个主流多模态评测基准)平均得分 65.2,以8B量级的大小在单图理解方面超越了 GPT-4o mini、GPT-4V、Gemini 1.5 Pro 和 Claude 3.5 Sonnet 等主流商用闭源多模态大模型。

多图理解和上下文学习。 MiniCPM-V 2.6 还支持多图对话和推理。它在 Mantis-Eval、BLINK、Mathverse mv 和 Sciverse mv 等主流多图评测基准中取得了最佳水平,并展现出了优秀的上下文学习能力。

视频理解。 MiniCPM-V 2.6 还可以接受视频输入,进行对话和提供涵盖时序和空间信息的详细视频描述。模型在 有/无字幕 评测场景下的 Video-MME 表现均超过了 GPT-4V、Claude 3.5 Sonnet 和 LLaVA-NeXT-Video-34B等商用闭源模型。

强大的 OCR 能力及其他功能。 MiniCPM-V 2.6 可以处理任意长宽比的图像,像素数可达 180 万(如 1344x1344)。在 OCRBench 上取得最佳水平,超过 GPT-4o、GPT-4V 和 Gemini 1.5 Pro 等商用闭源模型。基于最新的 RLAIF-V 和 VisCPM 技术,其具备了可信的多模态行为,在 Object HalBench 上的幻觉率显著低于 GPT-4o 和 GPT-4V,并支持英语、中文、德语、法语、意大利语、韩语等多种语言。

卓越的效率。 除了对个人用户友好的模型大小,MiniCPM-V 2.6 还表现出最先进的视觉 token 密度(即每个视觉 token 编码的像素数量)。它仅需 640 个 token 即可处理 180 万像素图像,比大多数模型少 75%。这一特性优化了模型的推理速度、首 token 延迟、内存占用和功耗。因此,MiniCPM-V 2.6 可以支持 iPad 等终端设备上的高效实时视频理解。

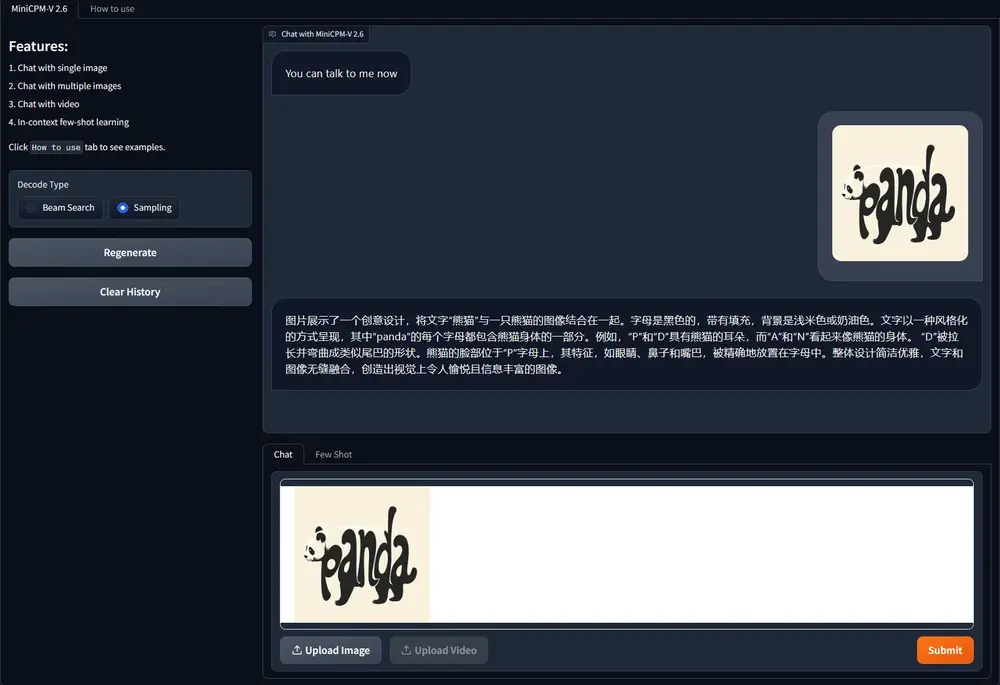

易于使用。 MiniCPM-V 2.6 可以通过多种方式轻松使用:(1) llama.cpp 和 ollama 支持在本地设备上进行高效的 CPU 推理,(2) int4 和 GGUF 格式的量化模型,有 16 种尺寸,(3) vLLM 支持高吞吐量和内存高效的推理,(4) 针对新领域和任务进行微调,(5) 使用 Gradio 快速设置本地 WebUI 演示,(6) 在线demo即可体验。

相关文章