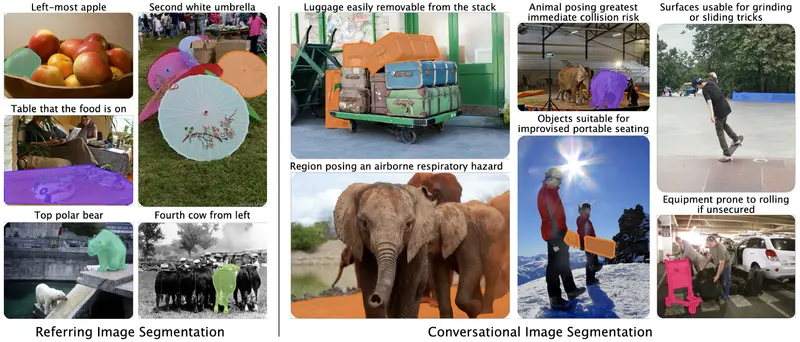

在传统的计算机视觉中,AI 擅长回答“这是什么?”(分类)或“它在哪里?”(检测/分割)。如果你问它:“把左边那个红色的杯子框出来”,它能做得很好。

但如果你问:“哪个行李箱可以单独拿走而不弄倒整堆行李?” 或者 “桌面上哪里适合放刚烧开的热汤锅?” 现有的 AI 往往会一脸茫然。因为这些指令不再仅仅关乎物体的类别或位置,而是涉及功能推理、物理稳定性、安全性等抽象概念。

- 项目主页:https://glab-caltech.github.io/converseg

- GitHub:https://github.com/AadSah/ConverSeg

- Demo:https://huggingface.co/spaces/aadarsh99/ConverSeg

近日,加州理工学院(Caltech)研究团队推出了 Conversational Image Segmentation (CIS) 技术与 ConverSeg 基准,旨在填补这一空白。他们提出的 ConverSeg-Net 模型,不仅能听懂日常对话中的复杂意图,还能将其转化为像素级精确的分割掩码,真正实现了从“看见物体”到“理解世界”的跨越。

核心突破:从“指代”到“推理”

现有的指代表达分割(RES)工作大多局限于简单的空间查询(如“左边的狗”)或属性描述(如“穿红衣服的人”)。ConverSeg 则首次系统性地将以下五大类抽象推理概念引入分割任务:

- 实体识别:支持开放词汇描述(如“风化的木质家具”)。

- 空间与布局:理解复杂的几何关系(如“挡住通道的物品”)。

- 关系与事件:捕捉交互状态(如“即将接球的运动员”)。

- 功能与可供性 (Affordance):推理物体的用途(如“可以当凳子用的行李”、“适合放热锅的表面”)。

- 物理与安全:评估稳定性与风险(如“容易倾倒的物体”、“可能滚落的危险源”)。

这意味着,AI 不再只是一个冷冰冰的识别机器,而是一个具备物理直觉和常识推理能力的视觉助手。

创新架构:ConverSeg-Net

为了应对这些挑战,研究团队设计了 ConverSeg-Net,一个高效、端到端的单次通过模型。

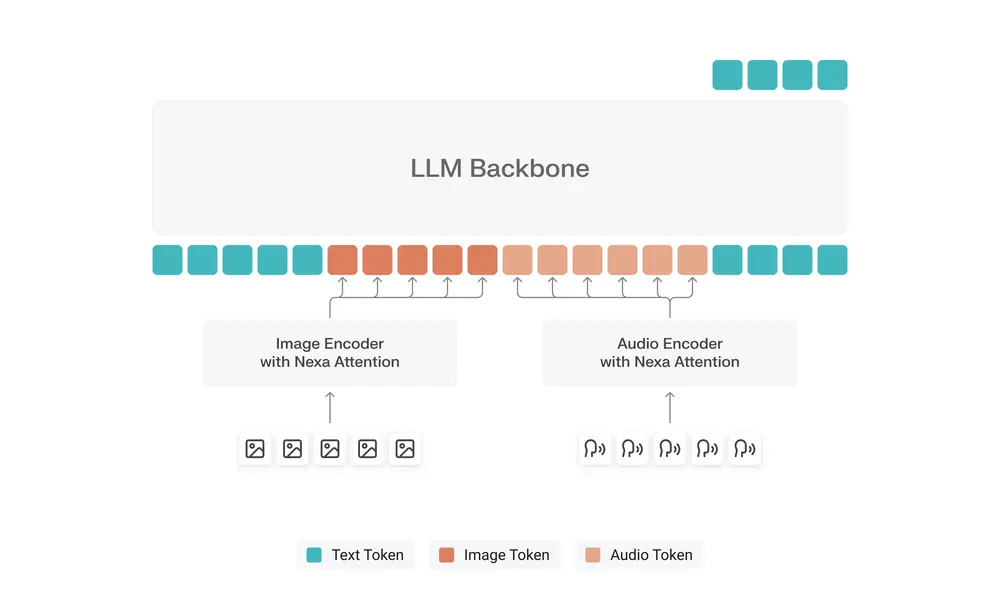

- 强强联合的骨干:

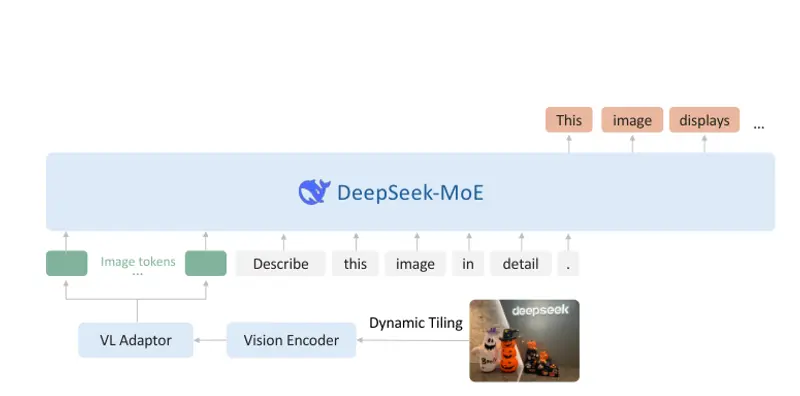

- 视觉编码:采用 SAM2 (Segment Anything Model 2) 的图像编码器,保留其强大的通用分割先验。

- 语言理解:集成 Qwen2.5-VL-3B 作为视觉语言主干,负责联合处理图像与文本提示,生成深层语义嵌入。

- 轻量级适配器:

- 通过一个轻量级的 Adapter 层,将 Qwen 生成的文本嵌入投影到 SAM2 的掩码解码器中。

- 利用交叉注意力机制调节掩码生成,确保输出的分割结果既符合语义意图,又保持像素级精准。

- 拒绝幻觉:

- 模型经过特殊训练,当指令描述的内容在图中不存在时(负样本),能正确返回空结果,而非胡乱猜测。

自动化数据引擎:无需人工标注的奇迹

训练此类模型最大的痛点在于数据:让人类标注员画出“容易倾倒的物体”的掩码并编写对应指令,成本极高且难以规模化。

ConverSeg 团队提出了一个完全自动化的 VLM 驱动数据引擎,在无需任何人工监督的情况下,合成了高质量的建议 - 掩码对:

- 场景理解:利用高性能 VLM (如 Gemini) 分析图像,生成初步的区域描述。

- 掩码生成:结合目标检测器 (Moondream) 与 SAM2,自动生成精确的像素掩码。

- 概念升级:将简单的描述(“小象”)升级为富含推理的对话指令(“象群中最易受攻击的个体”)。

- 双重验证:通过多轮 VLM 自检,剔除不匹配或低质量的数据,并生成负样本以增强鲁棒性。

这一引擎成功构建了包含 10 万+ 样本 的 ConverSeg 基准,覆盖了上述五大推理维度,为社区提供了宝贵的训练资源。

课程式学习策略

为了让模型循序渐进地掌握复杂推理,团队采用了两阶段训练课程:

- 第一阶段:基础夯实。在 COCO、RefCOCO 等标准数据集上训练,让模型掌握字面意义上的物体分割和基本指代能力。

- 第二阶段:抽象飞跃。引入自动生成的对话式概念数据进行训练,同时混合部分基础数据以防“灾难性遗忘”。这使得模型在学习高阶推理的同时,依然保持强大的通用分割性能。

实测表现:小模型,大智慧

测试结果令人振奋。尽管 ConverSeg-Net 仅使用了 **3B **(30 亿) 参数的 Qwen backbone,其表现却超越了众多更大规模的模型:

- ConverSeg 基准:在最具挑战性的“物理与安全”类别上,gIoU 从基础模型的 41.8% 飙升至 64.2%。整体性能显著优于使用 13B 模型的 LISA。

- 传统基准兼容:在 RefCOCO 系列任务中达到 78.4% gIoU,与专门针对该任务训练的模型相当。

- 零样本推理:在 ReasonSeg 基准上,3B 版本零样本得分 52.2%,甚至超过了在该数据集上微调过的 13B 模型 (51.5%);7B 版本更是提升至 57.0%。

相关文章