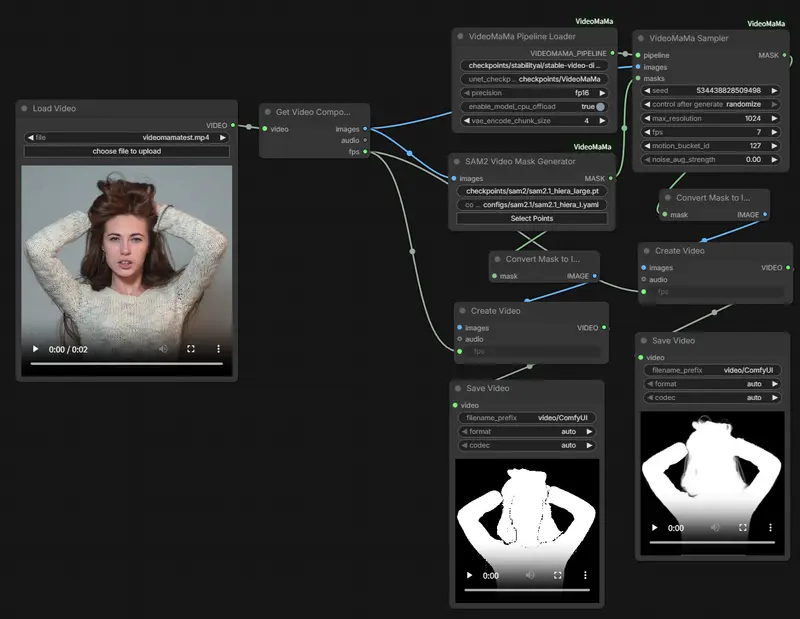

此前高丽大学、Adobe Research联合推出的VideoMaMa视频抠图模型,凭借扩散模型的生成先验实现了从粗糙掩码到精细Alpha遮罩的高质量转换,成为视频抠图领域的新SOTA。

现在无需复杂的代码调试,只需通过ComfyUI-VideoMaMa自定义节点,就能在ComfyUI中可视化操作VideoMaMa的全部核心能力——加载视频、生成遮罩、运行抠图推理一键完成,还集成了SAM2实现交互式遮罩生成,零基础也能做出专业级视频抠图效果。

核心价值:把SOTA视频抠图模型搬进ComfyUI

ComfyUI-VideoMaMa将VideoMaMa的推理逻辑封装为可视化节点,核心优势:

- 无需手写推理代码,纯拖拽式操作完成视频抠图;

- 自动下载基础模型(SVD)和VideoMaMa UNet权重,无需手动找资源;

- 集成SAM2交互式遮罩生成,鼠标点选即可得到目标物体掩码;

- 支持分辨率、运动强度、噪声增强等参数可视化调节,适配不同视频场景。

第一步:安装部署(3步搞定)

环境要求

- Python 3.10+

- PyTorch 2.0+(带CUDA)

- 显存充足的GPU(建议8G以上)

- 已安装ComfyUI

1. 克隆仓库并安装依赖

# 进入ComfyUI自定义节点目录

cd /path/to/ComfyUI/custom_nodes/

# 克隆仓库

git clone https://github.com/okdalto/ComfyUI-VideoMaMa

cd ComfyUI-VideoMaMa

# 安装依赖

pip install -r requirements.txt

2. 模型下载(自动/手动可选)

模型默认首次使用时自动下载,也可手动下载确保完整性:

① 基础SVD模型(必装)

huggingface-cli download stabilityai/stable-video-diffusion-img2vid-xt \

--local-dir checkpoints/stabilityai/stable-video-diffusion-img2vid-xt

② VideoMaMa UNet检查点(必装)

huggingface-cli download SammyLim/VideoMaMa \

--local-dir checkpoints/VideoMaMa

③ SAM2(可选,用于交互式遮罩生成)

# 安装SAM2

git clone https://github.com/facebookresearch/sam2

cd sam2 && pip install -e .

# 下载SAM2权重

mkdir -p ../checkpoints/sam2

cd ../checkpoints/sam2

wget https://dl.fbaipublicfiles.com/segment_anything_2/092824/sam2.1_hiera_large.pt

# 下载SAM2配置文件

mkdir -p ../../configs/sam2.1

cd ../../configs/sam2.1

wget https://raw.githubusercontent.com/facebookresearch/sam2/main/sam2/configs/sam2.1/sam2.1_hiera_l.yaml

3. 重启ComfyUI

重启后,在节点列表中即可看到「VideoMaMa」分类,所有节点已加载完成。

第二步:核心节点详解(3个关键节点)

1. VideoMaMa 管道加载器

作用:加载SVD基础模型和VideoMaMa微调UNet,生成推理管道。

| 输入参数 | 说明 | 默认值 |

|---|---|---|

| base_model_path | 基础SVD模型路径 | checkpoints/stabilityai/stable-video-diffusion-img2vid-xt |

| unet_checkpoint_path | VideoMaMa UNet路径 | checkpoints/VideoMaMa |

| precision | 计算精度 | fp16 |

| 输出:VIDEOMAMA_PIPELINE(供抠图推理使用) |

2. VideoMaMa 运行

作用:核心抠图推理节点,输入视频帧+掩码,输出高精度Alpha遮罩。

| 输入参数 | 说明 | 默认值 |

|---|---|---|

| pipeline | 管道加载器输出的管道对象 | - |

| images | 输入视频帧(格式:[N, H, W, C]) | - |

| masks | 掩码帧(格式:[N, H, W, C]) | - |

| seed | 随机种子 | 42 |

| max_resolution | 最长轴处理分辨率(8的倍数) | 1024(256-2048可调) |

| fps | 视频帧率 | 7 |

| motion_bucket_id | 运动强度(值越高动态越强) | 127 |

| noise_aug_strength | 噪声增强 | 0.0 |

| 输出:MASK(生成的精细Alpha遮罩帧,还原原始输入分辨率) |

3. SAM2 视频遮罩生成器(可选)

作用:交互式生成视频掩码,无需手动制作掩码文件。

| 输入参数 | 说明 |

|---|---|

| images | 输入视频帧 |

| checkpoint_path | SAM2权重路径 |

| config_file | SAM2配置文件路径 |

| user_input | 交互式点选择器的坐标输入 |

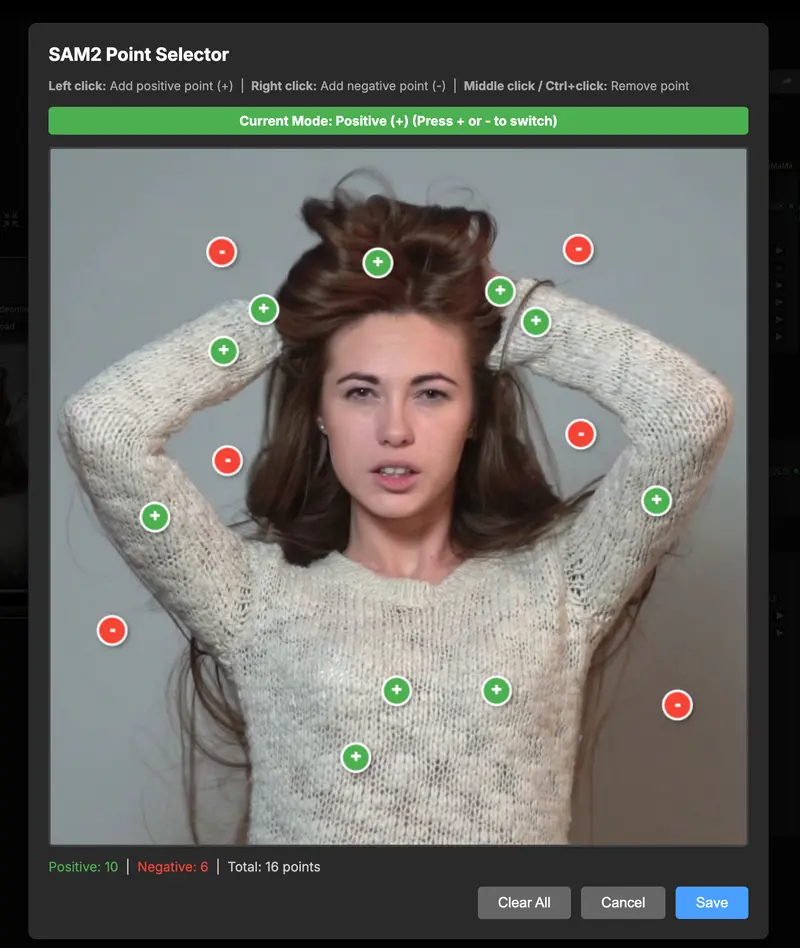

交互式点选择器使用技巧

点击「user_input」字段即可打开可视化选点界面:

- 左键单击:添加绿色正点(标记要抠图的前景物体);

- 右键单击:添加红色负点(标记要排除的背景);

- 中键/Ctrl+单击:移除已选点;

- +/-键:切换正负点模式;

- 选点完成后点击「保存」,生成对应掩码帧。

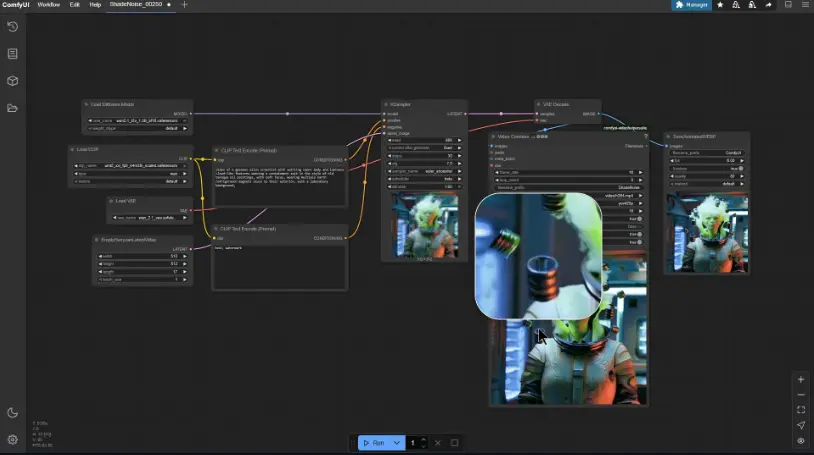

第三步:快速上手示例工作流

ComfyUI-VideoMaMa提供了现成的示例工作流(位于examples/文件夹),导入即可使用,核心步骤:

- 加载视频:用VHS Video Loader等节点导入需要抠图的视频;

- 生成掩码:要么用SAM2视频遮罩生成器交互式选点,要么加载已有的掩码文件;

- 加载管道:添加「VideoMaMa 管道加载器」节点,确认模型路径正确;

- 运行抠图:添加「VideoMaMa 运行」节点,连接管道、视频帧、掩码,调节分辨率/运动强度等参数;

- 保存/预览:用VHS Video Combine节点合成遮罩视频,或直接预览单帧效果。

关键参数调优提示

- 分辨率:

max_resolution控制处理时的最长轴,输出会还原原始分辨率,1080P视频建议设为1024(平衡速度与精度); - 运动桶:静态视频设50-100,动态视频(如人物运动)设150-200;

- 显存优化:分辨率设为512/768可降低显存占用,避免OOM报错;

- 掩码精度:SAM2选点时在物体边缘多添加正点,背景复杂处加负点,可大幅提升抠图效果。

常见故障排除

- 提示“SAM2 is not available”:重新执行SAM2的安装命令,确保

pip install -e .执行成功; - “Failed to load pipeline”:检查模型路径是否正确,确认SVD和VideoMaMa权重已完整下载,显存是否充足;

- “Frame count mismatch”:确保输入的视频帧和掩码帧数量一致;

- 抠图效果模糊:提高

max_resolution,或在SAM2选点时增加边缘细节的正点。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...