谷歌发布 TranslateGemma —— 一套基于 Gemma 3 构建的全新开源翻译模型家族,包含 4B、12B 和 27B 三种参数规模,支持 55 种语言 的高质量互译。更重要的是,它在效率与质量之间实现了罕见的平衡:12B 模型的翻译表现甚至超越了参数量两倍以上的 Gemma 3 27B 基线模型。

- 模型:https://huggingface.co/collections/google/translategemma

- 论文:https://arxiv.org/pdf/2601.09012

- Kaggle:https://www.kaggle.com/models/google/translategemma

这一突破不仅降低了部署门槛,也为本地化、低资源语言和边缘设备场景提供了切实可行的解决方案。

效率惊人:小模型,大性能

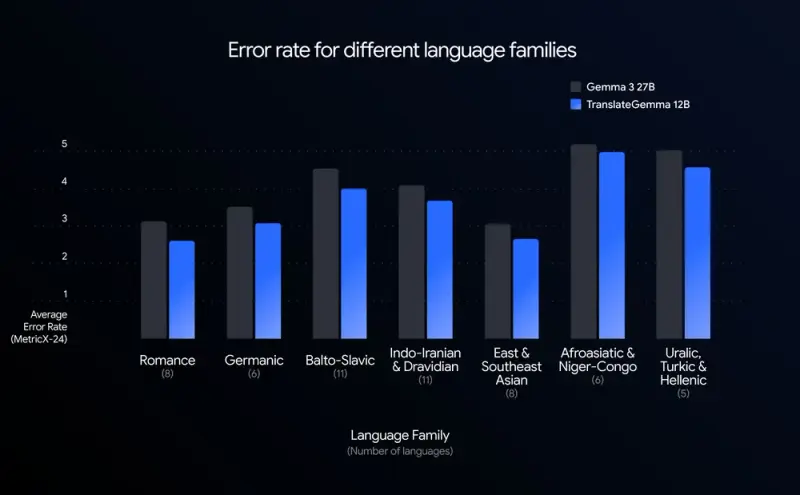

在权威的 WMT24++ 多语言翻译基准测试中(使用 MetricX 作为评估指标),TranslateGemma 展现出远超其体量的竞争力:

- 12B 模型 表现优于 Gemma 3 27B 基线;

- 4B 模型 性能可媲美传统 12B 级别模型。

这意味着开发者可以用更少的计算资源,获得更高保真的翻译结果——更低延迟、更高吞吐,同时不牺牲准确性。对于移动端或消费级硬件用户而言,这是一次真正的“降本增效”。

技术核心:从 Gemini 提炼“翻译直觉”

TranslateGemma 的高密度智能源于一套两阶段微调流程,将谷歌旗舰多模态模型 Gemini 的语言理解能力“蒸馏”到开源架构中:

- 监督式微调(SFT)

使用混合数据集训练,包括:- 高质量人工平行语料;

- 由 Gemini 生成的合成翻译文本。

即使在低资源语言(如斯瓦希里语、孟加拉语)中,也能保证覆盖广度与翻译保真度。

- 强化学习优化(RL)

引入多奖励模型机制(如 MetricX-QE、AutoMQM),引导模型输出更自然、语境贴合的译文,而非机械直译。

语言覆盖:兼顾主流与长尾

TranslateGemma 在 55 个核心语言对 上进行了严格训练与评估,涵盖:

- 高资源语言:英语、中文、西班牙语、法语、德语等;

- 中低资源语言:印地语、泰语、越南语、斯瓦希里语、乌尔都语等。

此外,团队还在 约 500 个扩展语言对 上进行了额外训练,为社区提供了一个强大的微调基础。完整语言列表已公开于技术报告,鼓励研究者针对特定语种进一步优化。

多模态潜力:图像内文本翻译也受益

尽管 TranslateGemma 主要面向纯文本翻译,但其改进也间接提升了多模态场景下的表现。在 Vistra 图像翻译基准 测试中,模型对图像中嵌入文字的翻译质量显著提高——即使未进行专门的多模态微调。这表明,文本翻译能力的增强具有跨模态溢出效应。

部署灵活:从手机到云端全覆盖

三种模型规模针对不同硬件环境优化:

| 模型规模 | 适用场景 | 典型部署平台 |

|---|---|---|

| 4B | 移动端、边缘设备 | 手机、平板、嵌入式设备 |

| 12B | 本地开发、个人电脑 | 消费级笔记本(无需高端 GPU) |

| 27B | 高保真云端服务 | 单张 H100 GPU 或 TPU |

这种分层设计让研究人员、开发者甚至普通用户都能根据自身条件选择合适版本,真正实现“随处可运行”。

如何开始使用?

TranslateGemma 已在 Hugging Face 和 Google AI 官方渠道开源,支持标准推理框架(如 vLLM、llama.cpp)。无论是构建多语言聊天机器人、本地化工具,还是研究低资源语言翻译,它都提供了一个高效、透明且可审计的起点。

谷歌表示:“我们期待社区在此基础上构建,打破语言障碍,促进更深层次的跨文化理解。”

相关文章