SDNQ(Stable Diffusion Next Quantization) 是 SD.Next 中集成的一套全平台量化系统,支持 19 种整数量化 与 69 种浮点量化 方案,可在 英伟达、AMD、英特尔显卡及 CPU 上运行。其核心目标是:在几乎不损失生成质量的前提下,大幅减少模型内存占用,并加速推理过程。

典型场景下,使用 INT8 量化 可将模型显存占用降低 50%,同时保持与原始 FP16 模型相近的输出质量。

核心特性

- 广泛的量化支持:

- 整数类型:1~8 位的

int/uint - 浮点类型:1~8 位的

float及其变体(如float8_e4m3fn)

- 整数类型:1~8 位的

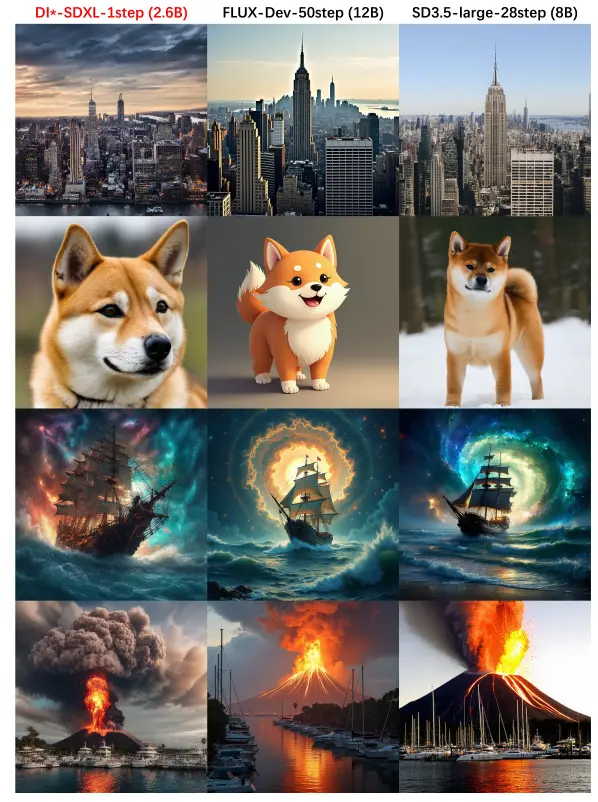

- 模型兼容性强:支持 UNet、文本编码器(TE)、VAE、ControlNet、LoRA、DiT、Flux 等主流架构

- 即时量化:模型加载时自动量化(“pre 模式”),系统内存压力更低

- 量化矩阵乘法(Quantized MatMul):在支持 INT8/FP8 的显卡上启用后,推理速度显著提升

- SVD 量化支持:提升低比特(如 4bit)下的质量,并使 LoRA 与 4bit 模型兼容

- 混合精度控制:可通过模块白名单或 JSON 配置,对特定层保留更高精度

推荐配置(平衡速度与质量)

| 量化类型 | 显存节省 | 质量损失 | 推荐场景 |

|---|---|---|---|

| INT8 | ~50% | 极低 | 通用首选,兼容性最好 |

| INT6 | ~63% | 轻微 | 追求更高压缩率 |

| UINT4 | ~72% | 中等 | 显存极度受限时使用 |

| float8_e4m3fn | ~50% | 接近 INT6 | 支持 FP8 的新显卡(如 RTX 40 系列) |

注意:VAE 通常不建议量化,否则易出现黑图。若必须使用,请搭配

FP16 Fixed VAE并关闭VAE Upcast。

关键选项说明

1. 量化目标(Quantization enabled)

- Model:量化主扩散模型(必选)

- TE:量化文本编码器(推荐)

- LLM:用于提示增强等 LLM 集成场景

- Control / VAE:按需启用,VAE 谨慎使用

2. 量化模式(Quantization mode)

- Pre:加载时量化,节省系统 RAM,支持 DiT/Flux 视频模型

- Post:加载后量化,兼容旧版 SDXL UNet

- Auto:自动选择(默认)

3. 量化矩阵乘法(Use Quantized MatMul)

启用后可大幅提升推理速度,但需硬件支持:

| 显卡厂商 | INT8 支持 | FP8 支持 |

|---|---|---|

| 英伟达 | Turing (RTX 20) 及以上 | Ada (RTX 40) 及以上 |

| AMD | RDNA2 (RX 6000) 及以上 | MI300X / RDNA4 (RX 9000) |

| Intel | Alchemist (Arc A) 及以上 | ❌ 不支持 |

在消费级 英伟达显卡 上,INT8 矩阵乘法通常比 FP8 更快,推荐优先使用

int8。

4. Triton 优化

- 作用:通过

torch.compile加速反量化过程 - 支持情况:

- Linux:英伟达/AMD/英特尔均开箱即用

- Windows:

- 英伟达/英特尔:需手动安装(参考 Wiki)

- AMD:实验性支持,需 ZLUDA 兼容

启用 Dequantize using torch.compile 可显著提升性能(需重启 WebUI 生效)。

高级功能

- SVD 量化:

启用后可在低比特下保持更高质量,并支持 4bit + LoRA 组合。但结果具有非确定性(每次量化略有差异)。 - 卷积层量化:

可进一步节省显存,但可能降低细节表现,适用于对速度要求高于画质的场景。 - 混合精度配置:

通过Modules dtype dict,可为关键模块(如时间嵌入层)指定更高精度(如minimum_6bit),实现质量-性能平衡。 - 显卡量化加速:

启用Quantize using GPU可在弱 CPU 机器上加快量化过程,但需注意设备映射设置对数据流向的影响。

使用步骤

- 进入 Settings → Quantization Settings

- 启用 Model 和 TE 量化

- 选择量化类型(推荐

int8) - 如硬件支持,勾选 Use Quantized MatMul 和 Dequantize using torch.compile

- 重新加载模型(若已加载)

量化设置仅对后续加载的模型生效,无需重新启动整个应用。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...