DeepSeek 开源了 DeepSeek-OCR,一个仅 30 亿参数的视觉语言模型(VLM),却在 OCR 与文本压缩领域展现出令人瞩目的创新力。其核心并非追求更大参数量,而是提出一种“光学压缩”(Optical Compression)的新范式:将文本信息编码为图像,用视觉 Token 高效替代冗长文本序列。

- GitHub:https://github.com/deepseek-ai/DeepSeek-OCR

- 模型:https://huggingface.co/deepseek-ai/DeepSeek-OCR

- 网页版:https://github.com/rdumasia303/deepseek_ocr_app

- Windows客户端:https://github.com/ihatecsv/deepseek-ocr-client

为什么需要“光学压缩”?

当前 LLM 处理长文本时面临计算复杂度平方级增长的瓶颈。DeepSeek 团队另辟蹊径:既然一张高分辨率图像可承载数千字信息,且仅需百级 Token 表示,何不将文本“渲染成图”再压缩?

OCR 成为理想验证场景——任务明确(图像→文本)、效果可量化,且天然契合“视觉→语言”转换逻辑。

核心成果:高效压缩 + 高精度重建

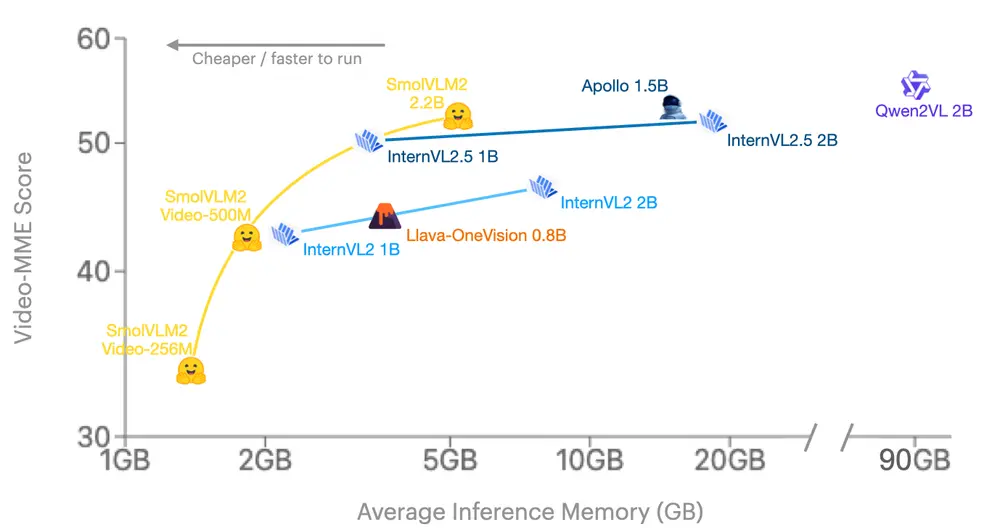

- 10 倍压缩率下,OCR 准确率达 97%+

- 20 倍压缩率下,仍保持约 60% 准确率

- 仅用 100 个视觉 Token,性能超越 GOT-OCR2.0(256 Token)

- <800 视觉 Token,击败 MinerU2.0(~7000 Token)

这意味着:原本需 1000 文本 Token 表达的内容,现在仅需 100 视觉 Token 即可高效重建。

核心痛点:LLM长文本处理的“算力困境”

当前所有LLM处理长文本时,都面临一个无法回避的问题:计算复杂度会随文本序列长度呈平方级增长。简单来说,文本越长,需要的算力越多、处理速度越慢,不仅增加了应用成本,还限制了超长文本场景的落地可能性。

如何在不牺牲效果的前提下,减少长文本处理的算力消耗?DeepSeek团队给出了一个反常规的思路:既然图像能承载大量文字信息,且占用的Token数量远少于纯文本,不如直接把文本“转成图像”——这就是“光学压缩”的核心逻辑,用视觉模态为文本信息“瘦身”。

而OCR(光学字符识别)天然适合验证这一思路:它本身就是“视觉→文本”的转换过程,效果可量化评估,能直观体现“压缩”与“准确率”的平衡。

性能表现:10倍压缩+97%准确率,基准测试碾压同类

DeepSeek-OCR的核心优势集中在“高压缩比”与“高准确率”的双重突破,实测数据相当亮眼:

1. 压缩比与准确率的平衡

- 常规场景下,压缩率可达10倍,OCR准确率仍保持在97%以上。也就是说,原本需要1000个文本Token表达的内容,现在仅需100个视觉Token就能还原,且几乎不影响识别效果;

- 极端场景下,即使将压缩率拉到20倍,准确率仍能维持在60%左右,满足部分对精度要求不高的快速处理场景。

2. 基准测试成绩亮眼

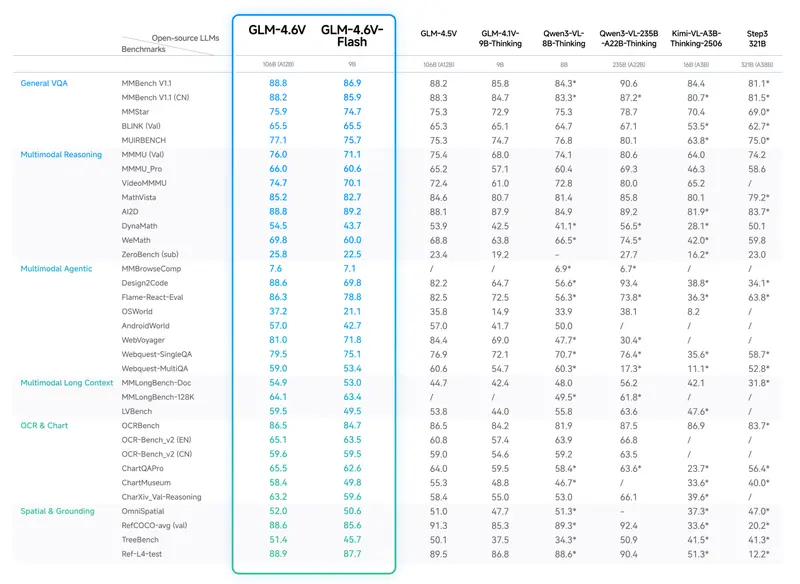

在OmniDocBench权威测试中,DeepSeek-OCR凭借“少Token高效果”的特点,大幅超越同类模型:

- 仅用100个视觉Token,性能就超过了使用256个Token的GOT-OCR2.0;

- 用不到800个视觉Token,直接超越了平均每页需要6000+Token的MinerU2.0;

- 针对幻灯片等简单文档,甚至仅需64个视觉Token就能达到满意的识别效果。

3. 生产效率优势

算力需求的降低直接转化为生产效率的提升:

- 单块A100-40G显卡,每天可生成超过20万页的LLM/VLM训练数据;

- 若部署20个节点(共160块A100),日处理量可飙升至3300万页,大幅降低大规模数据处理的成本。

模型架构:两大核心组件,兼顾性能与效率

DeepSeek-OCR的出色表现,源于其精巧的双组件架构设计,既保证了特征提取的完整性,又控制了算力开销。

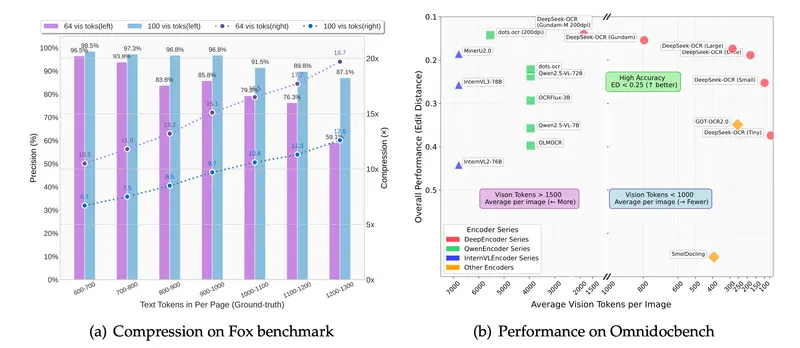

1. DeepEncoder:多分辨率的“视觉压缩引擎”

作为编码器,DeepEncoder的核心任务是提取图像特征并高效压缩,架构设计极具巧思:

- 串联SAM-base(8000万参数)与CLIP-large(3亿参数):前者负责“窗口注意力”,精准提取局部视觉特征;后者负责“全局注意力”,理解文本整体逻辑,兼顾细节与全局;

- 加入16×卷积压缩器:在特征进入全局注意力层前,大幅削减Token数量。例如,1024×1024的图像会被切成4096个patch token,经压缩后Token数显著减少,既保证高分辨率处理能力,又控制激活内存开销;

- 多分辨率支持:一个模型兼容多种输入规格,从512×512的Tiny模式(64个Token)到1280×1280的Large模式(400个Token),还支持动态分辨率的Gundam模式,适配不同场景需求。

2. DeepSeek3B-MoE:高效解码的“混合专家模型”

解码器采用DeepSeek-3B-MoE架构,通过“混合专家”设计实现“小参数大能力”:

- 模型总参数3B,但包含64个专家网络,推理时仅激活6个专家+2个共享专家,实际激活参数约5.7亿;

- 这种设计让模型既具备30亿参数模型的表达能力,又保持了5亿参数模型的推理效率,能快速从压缩后的视觉Token中重建原始文本。

训练数据:3000万页多语言数据,覆盖全场景需求

DeepSeek-OCR的高性能,离不开大规模、高质量的训练数据支撑。团队构建了多维度数据体系,总覆盖约100种语言:

1. 核心PDF数据(3000万页)

- 精标注数据:用PP-DocLayout、MinerU、GOT-OCR2.0等模型生成,包含检测与识别交织的高质量数据,以中英文为主(2500万页);

- 粗标注数据:通过fitz工具直接从PDF提取,主要用于提升少数语言的识别能力;

- 少数语言优化:采用“模型飞轮”机制——先用跨语言泛化能力强的版面分析模型检测,再用fitz数据训练GOT-OCR2.0,最后用训练好的模型标注更多数据,最终生成60万条少数语言样本。

2. 补充数据

- 300万条Word文档数据:重点提升公式识别和HTML表格解析能力;

- 2000万条场景OCR数据:从LAION和Wukong数据集收集图像,用PaddleOCR标注,中英文各1000万条,适配真实场景识别需求。

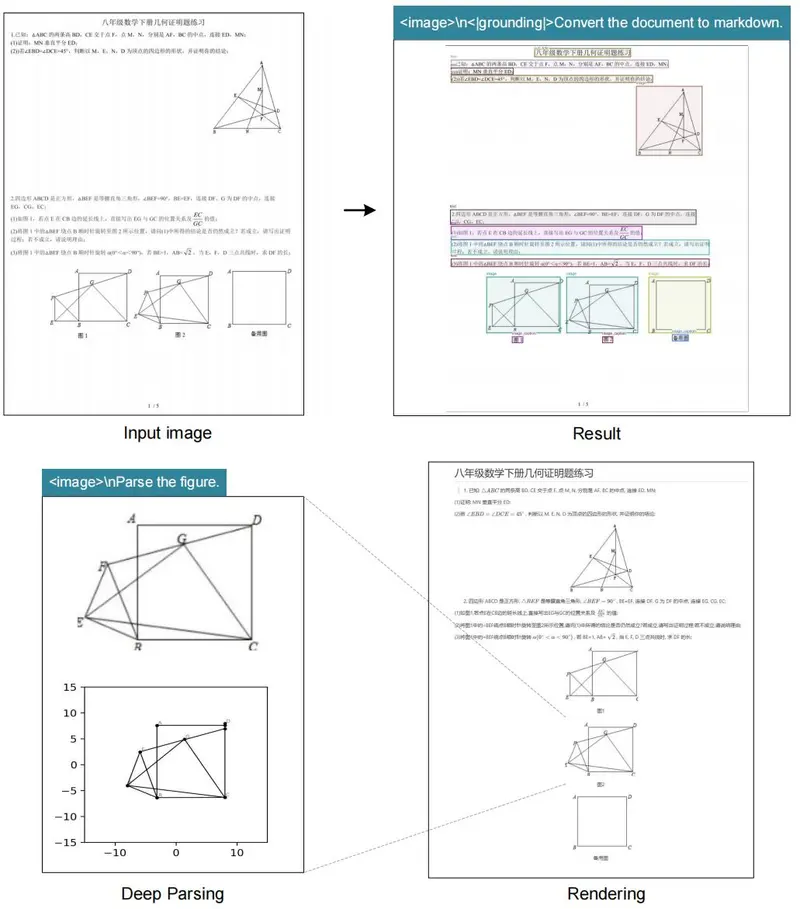

核心能力:不止于识别,更能“深度解析”

DeepSeek-OCR的价值不止于普通文字识别,还具备统一提示词驱动的“深度解析”能力,能处理复杂结构化内容,尤其适配STEM领域:

- 图表解析:将金融研究报告等文档中的图表,直接提取为结构化数据;

- 化学结构式:精准识别并转换为SMILES格式,方便科研使用;

- 几何图形:对平面几何图形进行复制和结构化解析;

- 自然图像:生成密集描述(dense captions),实现图像内容的详细还原。

创新延伸:用光学压缩模拟“人类遗忘机制”

基于“光学压缩”的核心思路,DeepSeek团队还提出了一个前瞻性研究方向——让AI模拟人类的遗忘机制,以支撑“无限上下文”处理:

- 逻辑设计:将超过第k轮的历史对话内容渲染成图像,先进行初步压缩(约10倍Token减少);对于更久远的上下文,进一步缩小图像尺寸;

- 效果模拟:图像越小,内容越模糊,对应AI对历史信息的“记忆淡化”,如同人类对久远事情的记忆衰退;

- 核心价值:近期上下文保持高保真度,历史上下文占用极少计算资源,理论上可突破当前LLM的上下文长度限制。

小模型的大突破,开辟全新赛道

DeepSeek-OCR表面是一款OCR模型,本质是对“LLM文本处理方式”的一次革新——用视觉模态作为高效压缩媒介,解决长文本处理的算力困境。

3B参数的“小体量”,却实现了10倍压缩、97%准确率的“大性能”,不仅在OCR任务中表现突出,更为VLM(视觉语言模型)与LLM的进化提供了新方向。正如团队所探索的,AI的进化未必是“做加法”(堆砌参数),也可以是“做减法”(优化处理逻辑)。

目前,DeepSeek-OCR已完全开源,其创新思路和实践成果,有望在长文本处理、多语言识别、科研数据解析等场景中快速落地,为更多开发者提供高效、低成本的解决方案。

相关文章