在图像生成领域,AI 已经能完成许多复杂操作:补全残缺画面、扩展图像边界、移除干扰物体,甚至在图中添加可读文本。但这些任务通常由不同模型分别处理——每个任务有自己的训练流程、评估标准和奖励机制。

这带来了两个问题:

- 模型泛化能力弱,难以跨任务迁移;

- 训练成本高,维护多个奖励系统效率低下。

为解决这一挑战,字节跳动提出 OneReward ——一种全新的统一强化学习框架,仅用一个视觉语言模型(VLM)作为共享奖励模型,即可指导多个图像编辑任务的训练。

- 项目主页:https://one-reward.github.io

- GitHub:https://github.com/bytedance/OneReward

- 模型:https://huggingface.co/bytedance-research/OneReward

- FP8版:https://huggingface.co/yichengup/flux.1-fill-dev-OneReward

- GGUF版:https://huggingface.co/befox/OneReward-GGUF

基于该框架,团队推出了 Seedream 3.0 Fill,一个无需任务特定监督微调(SFT)的统一图像编辑模型,在多项任务上超越主流商业系统,包括 Ideogram、Adobe Photoshop 和 FLUX.Fill [Pro]。

此外,基于开源版本 FLUX Fill [dev] 微调的 FLUX.1-Fill-dev-OneReward 模型,已在图像填充与扩展任务中反超其闭源 Pro 版本,成为新的开源标杆。

为什么需要“统一”的奖励?

当前主流图像编辑方法大多依赖任务特定的监督微调(Task-specific SFT)。例如,训练“对象移除”模型时,使用专门标注的数据集;做“文本渲染”时,再单独构建一套流程。

这种方式虽然有效,但存在明显局限:

- 数据利用率低,难以共享知识;

- 奖励信号分散,无法实现多任务协同优化;

- 部署维护成本高,不利于规模化应用。

OneReward 的核心理念是:

让同一个奖励模型学会判断不同任务下的“好坏”。

它不关心任务名称,只关注输入条件、编辑区域(掩码)和输出质量。通过将任务类型 + 评估维度作为提示注入 VLM,模型可以动态理解“现在是在评价文本对齐,还是结构一致性?”从而给出一致且可比的奖励反馈。

这个 VLM 就是 Qwen2.5-VL,作为 OneReward 的唯一奖励判别器。

核心技术架构

✅ 1. 统一强化学习流程

OneReward 的训练过程如下:

- 随机采样任务:从图像填充、扩展、对象移除、文本渲染等任务中按概率抽取样本;

- 双路径生成:

- 参考图像:由参考策略 π_ref 完全去噪生成(高质量基线);

- 评估图像:由当前策略 π_θ 在部分去噪步骤后预测结果;

- 奖励建模:将两幅图像送入 VLM 奖励模型,判断哪张更优;

- 策略更新:根据奖励差值优化 π_θ,使其逐步超越参考模型。

这种设计避免了对真实环境的在线交互,同时保留了强化学习对长期目标的优化能力。

✅ 2. 单一奖励模型,支持多维度评判

传统方法往往为每个评估指标训练独立奖励函数。OneReward 则通过自然语言指令引导 VLM 实现多维判断。

例如,输入查询可能是:

“请比较两张图像在‘文本渲染’任务中的‘文本对齐’表现:哪张图的文字位置更准确、字体更匹配原图风格?”

其中,“文本渲染”是任务,“文本对齐”是评估维度。其他常见维度还包括:

- 结构合理性

- 纹理与风格一致性

- 美学质量

- 对象移除完整性

通过灵活组合任务与维度,同一 VLM 可覆盖所有场景,极大提升了系统的通用性和扩展性。

✅ 3. 动态参考模型(EMA 更新)

为了防止奖励模型“惯性偏见”(即总是偏好旧样本),OneReward 引入了一个动态演进的参考策略 π_ref,采用指数移动平均(EMA)方式持续更新。

这意味着随着主模型进步,它的“对手”也在变强——形成良性竞争循环,推动性能持续上升。

✅ 4. 多任务联合优化

在每次训练迭代中,OneReward 同时优化多个任务和多个评估维度。策略模型不再局限于单一目标,而是学习成为一个“综合评分高”的编辑者。

这有助于提升模型在复杂现实场景中的鲁棒性——比如用户上传一张照片,要求“去掉路人,并在天空加一句生日祝福”,本质上是对象移除 + 文本渲染的复合任务。

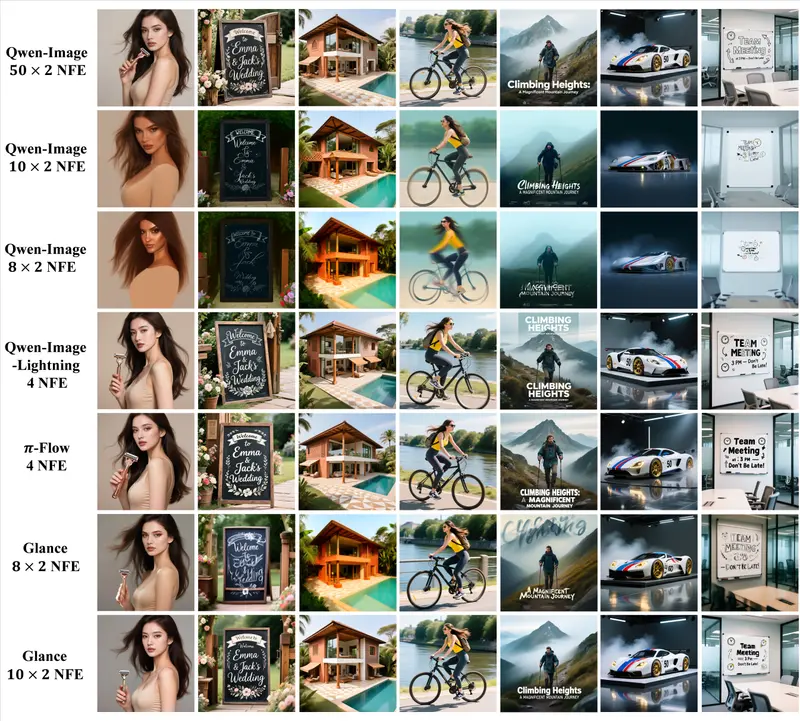

实验结果:全面领先

在多个公开基准和内部测试集上,基于 OneReward 训练的 Seedream 3.0 Fill 显著优于现有方案:

| 任务 | Seedream 3.0 Fill | 最佳竞品 | 提升幅度 |

|---|---|---|---|

| 图像填充 | 69.04% 可用性 | 52.11% | +16.93 pts |

| 图像扩展(带提示) | 64.72% | Ideogram (~64%) | 相当或略优 |

| 图像扩展(无提示) | 87.54% | FLUX Fill [Pro] | 显著领先 |

| 对象移除 | 82.22% 总体可用性 86.33% 移除质量 | Adobe PS / FLUX | 明显优势 |

特别是在无提示扩展和高质量文本渲染任务中,模型展现出更强的语义理解和上下文保持能力。

更重要的是,这些性能提升是在没有任务特定 SFT 的前提下实现的——直接在预训练扩散模型上进行端到端 RL 优化。

开源贡献:FLUX.1-Fill-dev-OneReward 发布

为进一步推动社区发展,研究团队基于 FLUX Fill [dev] 开源基础模型,应用 OneReward 框架进行了再训练,并发布:

FLUX.1-Fill-dev-OneReward

该模型在图像填充与扩展任务上的表现已超过闭源的 FLUX Fill [Pro],为后续统一图像编辑研究提供了新的开源基线。

这也验证了 OneReward 框架的良好适配性——不仅适用于自研模型,也能显著增强第三方架构。

应用前景

OneReward 的意义不仅在于性能突破,更在于它提供了一种可扩展的多任务训练范式,未来可应用于:

🔹 跨模态编辑:结合音频、3D 场景理解,实现视频帧修复或 AR 内容生成;

🔹 自动化设计工具:集成至设计软件中,支持一键去水印、智能延展画布等功能;

🔹 个性化内容生成:根据用户历史偏好动态调整奖励权重,生成更符合个人审美的图像。

随着 VLM 判断能力的提升,这类“通用评判者”有望成为下一代生成模型的标准组件。

相关文章