在文本到图像生成领域,如何让预训练模型快速适应新的空间控制条件(如边缘图、深度图、人体姿态等),一直是一个挑战。传统方法通常需要大量标注数据和高昂的训练成本,限制了其灵活性与实用性。

为此,韩国科学技术院(KAIST)的研究团队提出了一种创新解决方案——UFC(Universal Few-Shot Control)。该方法能够在仅使用极少量标注样本的情况下,实现对新空间条件的高效适应,并在生成过程中保持高度的结构一致性。

核心目标:用极少数据,实现精准控制

UFC 的设计初衷是解决现有控制适配器在面对未见过的空间条件任务时适应能力差、泛化性弱的问题。它允许用户将新的控制信号(例如某种特定类型的分割掩码或法线图)注入到一个已冻结的扩散模型中,而无需重新训练整个网络。

关键优势在于:

- 仅需 30 个图像-条件对(即“30-shot”)即可完成微调;

- 在某些任务中,使用完整数据集的 0.1% 就能达到与全监督基线相当的性能;

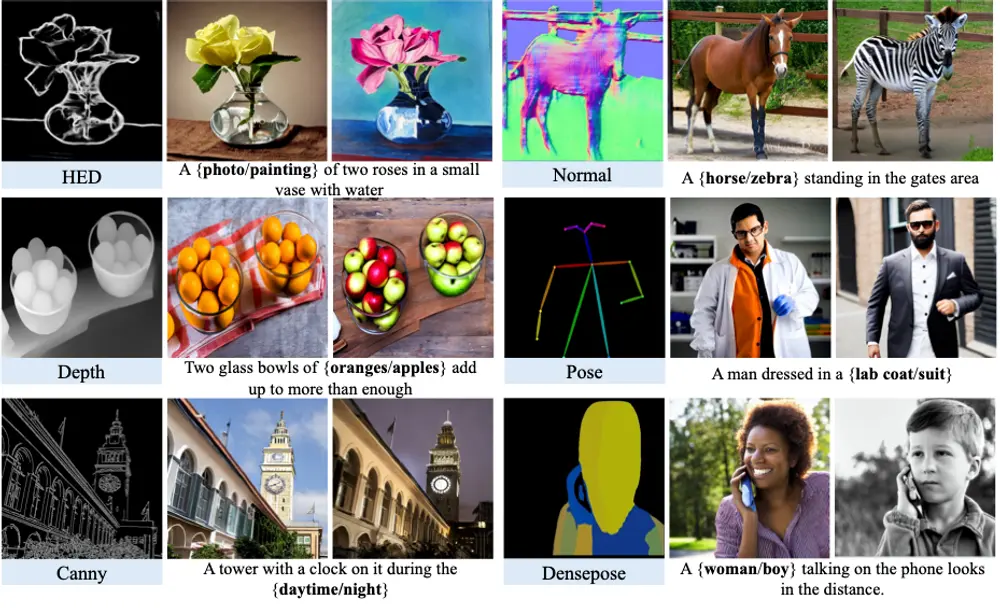

- 支持跨模态控制输入,包括边缘图(Canny/HED)、深度图、法线图、人体姿态、语义分割等。

主要功能

| 功能 | 说明 |

|---|---|

| ✅ 精细结构控制 | 实现对生成图像几何结构、布局和局部细节的高度可控。 |

| ✅ 快速任务迁移 | 面对全新控制任务(如一种新型草图风格),可在少量样本下快速适配。 |

| ✅ 多模态支持 | 兼容多种空间条件类型,适用于多样化的创作与编辑需求。 |

技术原理:类比匹配 + 轻量微调

UFC 的核心机制基于“类比推理”思想:给定一组支持样本(support pairs)和一个查询条件(query condition),模型通过计算两者之间的特征相似度,动态构建适合当前任务的控制表示。

工作流程如下:

- 特征提取

- 使用图像编码器 $ f $ 提取支持图像的内容特征;

- 使用条件编码器 $ g_\tau $ 编码查询条件(如边缘图)。

- 匹配机制

- 计算查询条件与各支持条件之间的注意力权重;

- 权重反映结构上的语义对齐程度。

- 特征插值

- 基于匹配权重,对支持图像的视觉特征进行加权融合;

- 生成统一的、任务特定的控制特征。

- 参数微调

- 仅更新一小部分任务专属参数 $ \theta_\tau $;

- 主干模型保持冻结,避免过拟合且节省资源。

这一机制使得 UFC 能够“举一反三”,即使从未见过某种控制形式,也能通过类比已有经验做出合理推断。

架构兼容性:支持 UNet 与 DiT

UFC 并不依赖特定的生成架构,已验证其在以下两类主流扩散模型上均有效:

- UNet:传统扩散模型主干;

- DiT(Diffusion Transformer):基于Transformer的新一代架构。

这表明 UFC 是一种模型无关(architecture-agnostic)的方法,具备良好的扩展潜力。

实验表现:小样本,大效果

在六个全新的空间控制任务上进行了广泛测试,结果表明:

| 指标 | 表现 |

|---|---|

| GenEval (SSIM) | 显著优于少样本基线,接近全监督水平 |

| FID 分数 | 在 Normal、Depth、Canny 等条件下大幅下降,图像质量更高 |

| ImgEdit Score | 控制保真度提升明显,结构一致性更强 |

示例:在仅使用 COCO 数据集 0.1% 标注的情况下,UFC 在 Depth-to-Image 任务中的 FID 达到 18.7,逼近全数据训练的 18.3。

定性结果显示,UFC 能准确遵循复杂的人体姿态、精细的边缘结构以及高维法线方向,生成自然且结构一致的图像。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...