一项来自罗德岛大学AI实验室的研究估算显示,OpenAI推出的GPT-5模型在能耗方面可能远超前代——其单次查询的电力消耗可能是GPT-4的8.6倍以上。

这一数据尚未得到OpenAI官方确认。由于该公司未公开GPT-5的实际运行参数和硬件部署细节,目前所有关于能耗的结论均基于第三方研究团队的推测。尽管如此,这些估算仍为评估大型语言模型(LLM)的能源影响提供了重要参考。

一次响应最高耗电40瓦时?

根据《卫报》报道,罗德岛大学的研究团队估算,生成一个中等长度(约1000个token)的GPT-5响应,最高可能消耗40瓦时(Wh) 的电力,平均约为18.35瓦时。

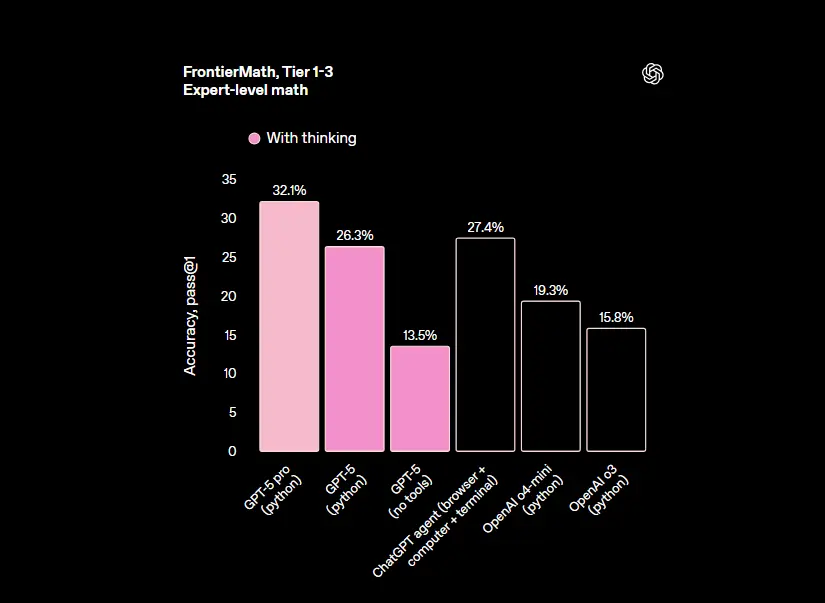

作为对比:

- GPT-4的同等任务能耗约为2.12瓦时

- Deepseek R1为20.90瓦时

- OpenAI o3为25.35瓦时

这意味着,在当前测试模型中,GPT-5的单位请求能耗仅次于o3,显著高于其他主流模型。

如果将这一数字扩展到实际使用规模——以ChatGPT每日处理约25亿次请求计算,全部由GPT-5支撑,则每天总能耗可能高达45吉瓦时(GWh)。

这是一个相当惊人的数值。作为参照,一座典型的现代核电站每小时发电量在1至1.6吉瓦之间。也就是说,若按此估算,支持GPT-5运行的数据中心所需电力,相当于需要两到三个核反应堆持续满负荷运转,足以供应一个小型国家的日常用电。

估算方法:基于响应时间与硬件假设

研究团队并未直接测量GPT-5的能耗,而是采用间接推算方式,结合两个关键变量:

- 响应时间:模型完成一次推理所需的时间;

- 硬件功耗:运行该模型所依赖的计算系统的平均功率。

由于OpenAI未披露GPT-5的具体部署架构,研究人员假设其运行在微软Azure云平台上的Nvidia DGX H100或H200系统上。这类系统是当前AI训练与推理的主流基础设施。

通过将实测的响应时间乘以设备的额定功率,并纳入数据中心整体效率因素(如PUE、WUE、CIF等),团队得出了最终的能耗估算值。

其中:

- PUE(电源使用效率) 反映数据中心除IT设备外的额外能耗(如冷却、供电损耗)

- CIF(碳强度因子) 用于估算电力来源的碳排放水平

值得注意的是,这一估算存在明显局限。如果OpenAI实际采用了更新的Nvidia Blackwell架构(性能最高可达H100的四倍),那么单位任务的能耗和时间都将大幅下降,现有估算结果将不再适用。

混合专家架构的影响

GPT-5据信采用了“混合专家”(Mixture of Experts, MoE)设计,即并非所有模型参数在每次请求中都被激活。这种机制在处理简单或短查询时可以有效降低资源消耗。

然而,对于复杂或长文本生成任务,系统需要调用更多专家模块,导致推理路径变长、计算密度上升。据研究人员Shaolei Ren指出,在某些情况下,相同输出的能耗可能因此增加5到10倍,甚至突破40瓦时/次。

这也意味着,用户请求的类型对整体能耗有显著影响——越是复杂的交互,背后的能源代价越高。

估算虽不精确,趋势不容忽视

必须强调的是,这项研究的结果属于估算性质,且高度依赖于未被验证的硬件与部署假设。OpenAI尚未回应相关数据的准确性问题,因此我们无法确认GPT-5的真实能效表现。

但一个清晰的趋势正在浮现:随着模型规模扩大、推理复杂度提升,AI系统的能源需求正在快速攀升。

在美国,已有多个地区报告因AI数据中心建设激增而导致电网压力加大、电价上涨。部分科技公司甚至开始与能源供应商合作,探索专用供电方案,包括重启退役电厂或投资可再生能源项目。

无论GPT-5的实际能耗是否真的达到估算水平,其背后反映的问题值得重视:当AI能力不断增强的同时,我们是否也为它的“能源账单”做好了准备?(来源)

相关文章