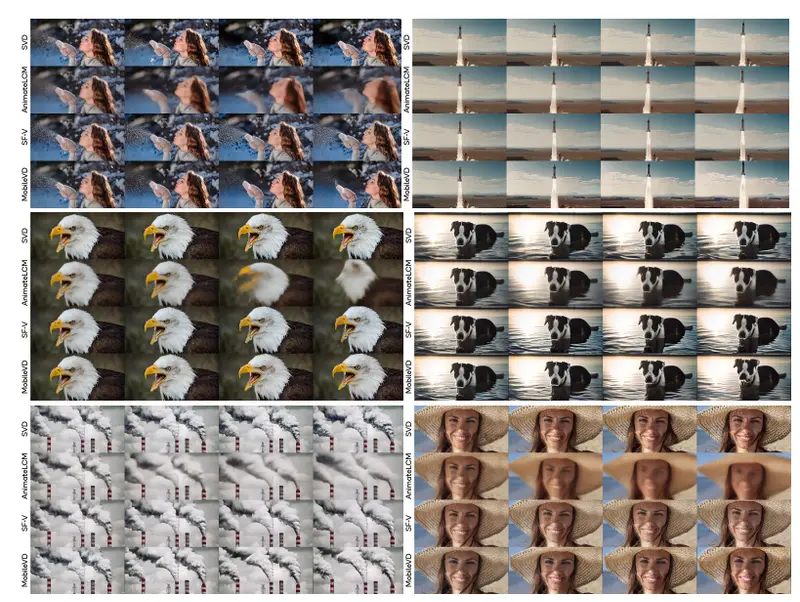

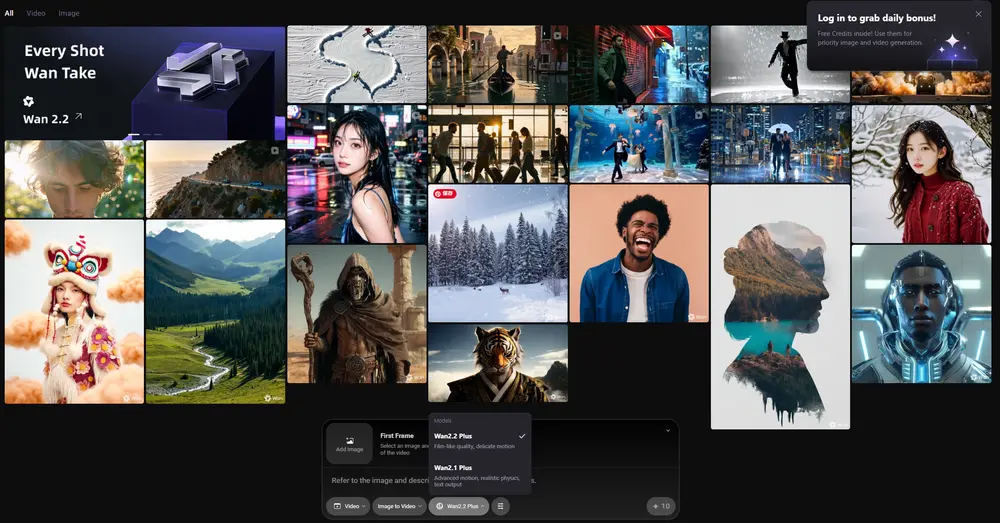

阿里云通义实验室推出的 Wan2.2 视频生成模型已全面支持 ComfyUI,并提供官方原生工作流模板。

Wan2.2 模型采用创新的 MoE架构,由高噪专家模型和低噪专家模型组成,能够根据去噪时间步进行专家模型划分,从而生成更高质量的视频内容。

Wan 2.2 具备三大核心特性:影视级美学控制,深度融合专业电影工业的美学标准,支持光影、色彩、构图等多维度视觉控制;大规模复杂运动,轻松还原各类复杂运动并强化运动的流畅度和可控性;精准语义遵循,在复杂场景和多对象生成方面表现卓越,更好还原用户的创意意图。 模型支持文生视频、图生视频等多种生成模式,适用于内容创作、艺术创作、教育培训等多种应用场景。

Wan2.2 核心能力概览

Wan2.2 是新一代多模态视频生成模型,采用创新的 混合专家(MoE)架构,通过高噪专家与低噪专家分工协作,实现高质量视频生成:

- ✅ 影视级美学控制:融合电影工业标准,支持光影、色彩、构图等维度精细调控。

- ✅ 大规模复杂运动建模:流畅还原人物动作、物体运动与镜头运镜。

- ✅ 精准语义理解:在多对象、复杂场景下更好遵循用户提示。

- ✅ 高效压缩设计:5B 版本支持高压缩 VAE,可在 8GB 显存设备上运行。

开源模型版本说明

| 模型类型 | 模型名称 | 参数量 | 主要功能 | 下载地址 |

|---|---|---|---|---|

| 混合模型 | Wan2.2-TI2V-5B | 5B | 支持文本+图像输入,单模型覆盖 T2V 与 I2V | 魔塔 |

| 图生视频 | Wan2.2-I2V-A14B | 14B | 静态图转动态视频,保持内容一致性 | 魔塔 |

| 文生视频 | Wan2.2-T2V-A14B | 14B | 从文本生成高质量视频,支持影视级控制 | 魔塔 |

- 本文所用模型来自官方Hugging Face仓库:Comfy-Org/Wan_2.2_ComfyUI_Repackaged

- 国内的朋友请从官方的魔塔仓库下载模型:Comfy-Org/Wan_2.2_ComfyUI_Repackaged

使用前提:确保 ComfyUI 环境正确

在加载 Wan2.2 工作流前,请确认以下条件:

- ✅ 使用 最新 nightly(开发版)ComfyUI

- ❌ 不推荐使用稳定版(release)或桌面版(desktop),可能缺少必要节点

- ✅ 若启动时报错“节点导入失败”,请重新拉取最新代码并重启

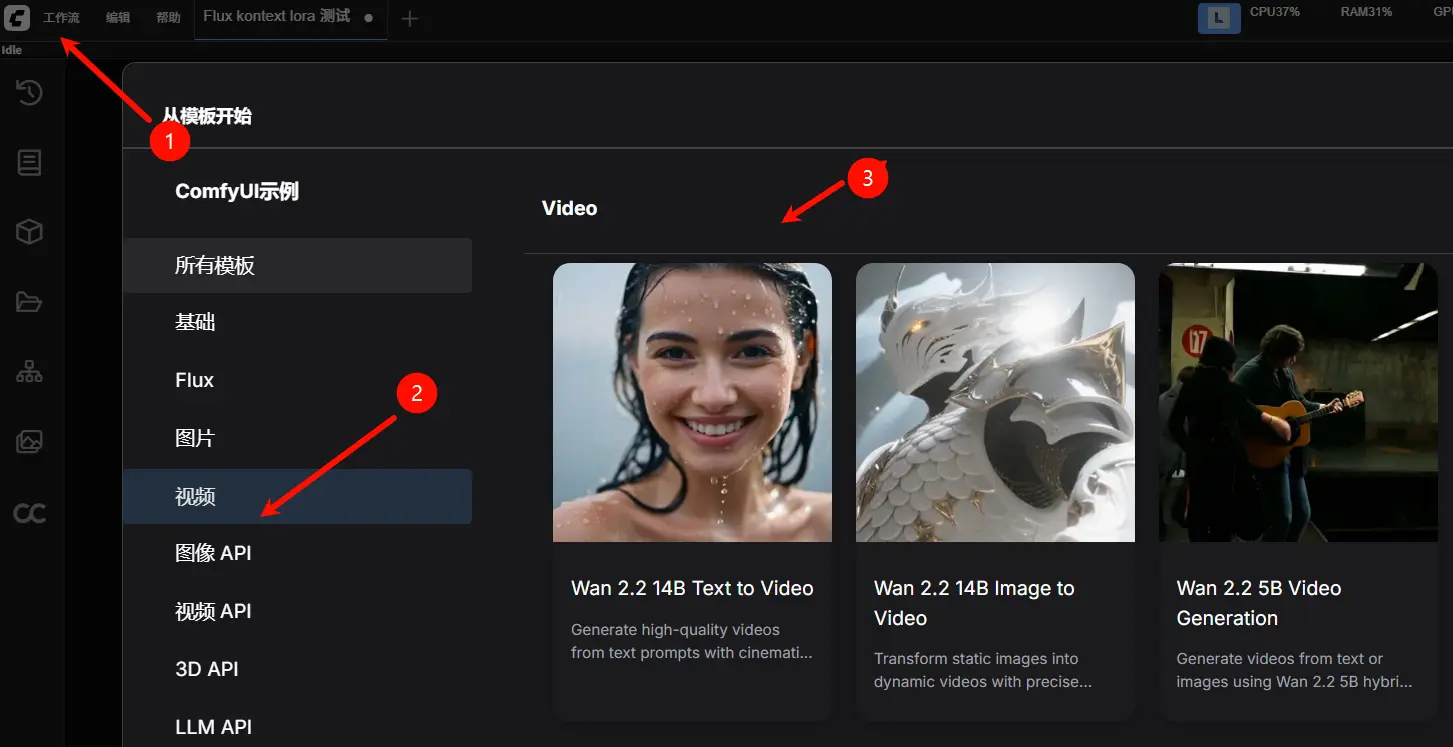

更新后重启 ComfyUI,即可在“工作流 → 浏览模板 → 视频”中找到 Wan2.2 相关模板。

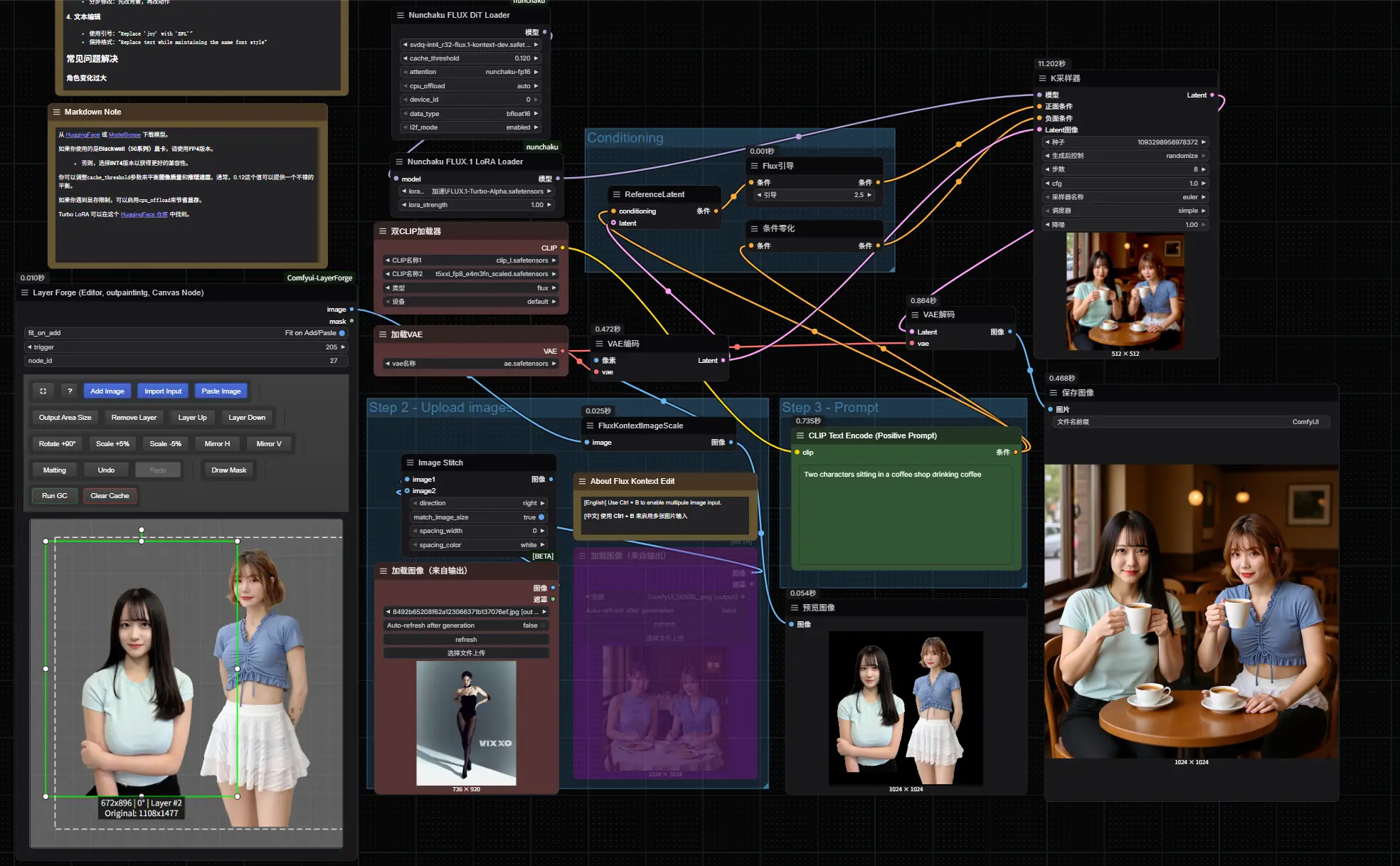

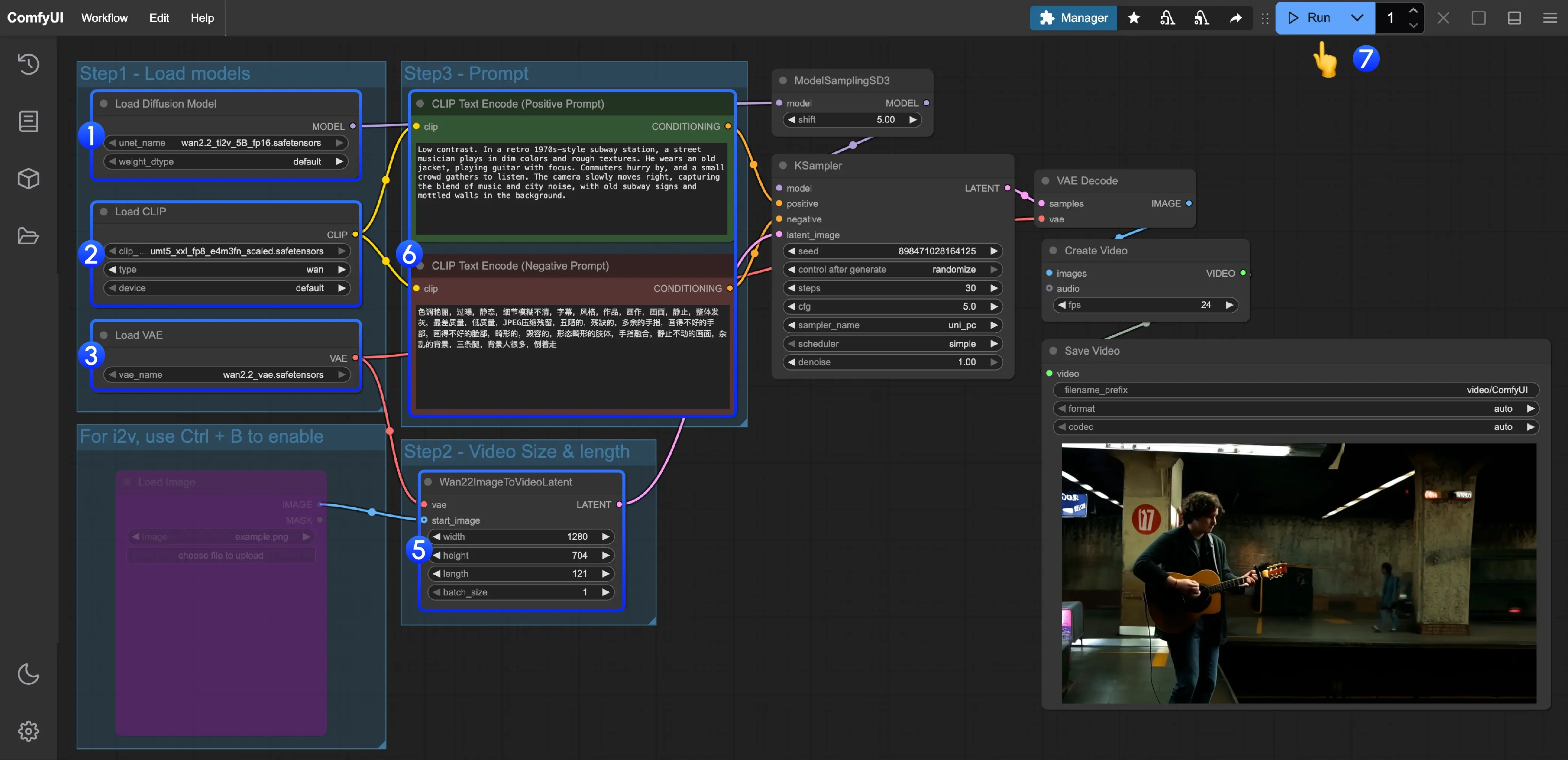

一、Wan2.2-TI2V-5B 混合模型工作流(推荐入门)

- 适用于:文本生成视频、图像生成视频

- 硬件要求:最低 8GB 显存(启用 offload 可进一步降低占用)

1. 加载工作流

进入 ComfyUI:

工作流 → 浏览模板 → 视频 → 选择 “Wan2.2 5B Video Generation”

或手动下载 .json 文件并拖入界面。

2. 手动下载模型文件

请将以下模型放入对应目录:

ComfyUI/

├───📂 models/

│ ├───📂 diffusion_models/

│ │ └───wan2.2_ti2v_5B_fp16.safetensors

│ ├───📂 text_encoders/

│ │ └─── umt5_xxl_fp8_e4m3fn_scaled.safetensors

│ └───📂 vae/

│ └── wan2.2_vae.safetensors| 模型组件 | 文件名 | 存放路径 |

|---|---|---|

| Diffusion Model | wan2.2_ti2v_5B_fp16.safetensors | models/diffusion_models/ |

| VAE | wan2.2_vae.safetensors | models/vae/ |

| Text Encoder | umt5_xxl_fp8_e4m3fn_scaled.safetensors | models/clip/ |

3. 配置与运行

- ✅ 确认

Load Diffusion Model节点已加载wan2.2_ti2v_5B_fp16.safetensors - ✅

Load CLIP加载umt5_xxl_fp8_e4m3fn_scaled.safetensors - ✅

Load VAE加载wan2.2_vae.safetensors - 🖼️ (可选)使用

Ctrl+B启用Load Image实现图生视频 - 🔤 (可选)在

CLIP Text Encoder节点修改正向/负向提示词 - 📏 (可选)调整

Wan22ImageToVideoLatent中的分辨率与帧数(length) - ▶️ 点击 Run 或按

Ctrl/Cmd + Enter开始生成

支持 720P @24fps,生成 5 秒视频约需 6–9 分钟(RTX 4090)

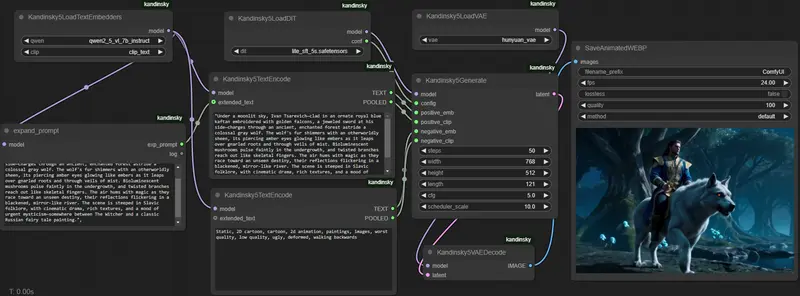

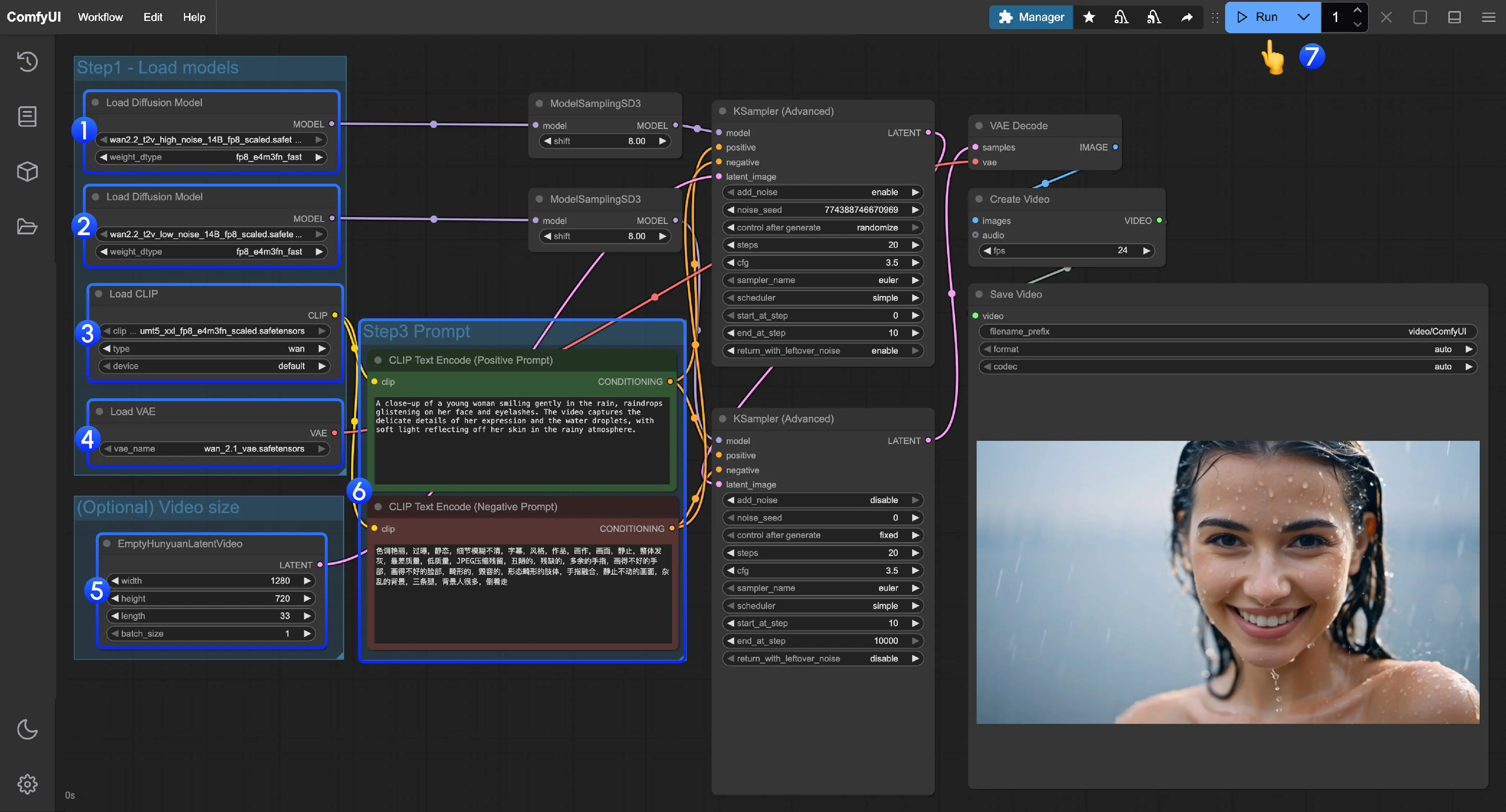

二、Wan2.2-T2V-A14B 文生视频工作流

适用于:纯文本驱动视频生成,追求高画质与美学控制

1. 加载工作流

工作流 → 浏览模板 → 视频 → 选择 “Wan2.2 14B T2V”

或手动下载并拖入。

2. 手动下载模型

ComfyUI/

├───📂 models/

│ ├───📂 diffusion_models/

│ │ ├─── wan2.2_t2v_low_noise_14B_fp8_scaled.safetensors

│ │ └─── wan2.2_t2v_high_noise_14B_fp8_scaled.safetensors

│ ├───📂 text_encoders/

│ │ └─── umt5_xxl_fp8_e4m3fn_scaled.safetensors

│ └───📂 vae/

│ └── wan_2.1_vae.safetensors| 模型组件 | 文件名 |

|---|---|

| Diffusion Model (High Noise) | wan2.2_t2v_high_noise_14B_fp8_scaled.safetensors |

| Diffusion Model (Low Noise) | wan2.2_t2v_low_noise_14B_fp8_scaled.safetensors |

| VAE | wan_2.1_vae.safetensors |

| Text Encoder | umt5_xxl_fp8_e4m3fn_scaled.safetensors |

MoE 架构拆分为两个专家模型,需分别加载

3. 配置与运行

- ✅ 第一个

Load Diffusion Model加载 high noise 模型 - ✅ 第二个

Load Diffusion Model加载 low noise 模型 - ✅

Load CLIP加载umt5_xxl_fp8_e4m3fn_scaled.safetensors - ✅

Load VAE加载wan_2.1_vae.safetensors - 📏 在

EmptyHunyuanLatentVideo中设置分辨率与帧数(默认 480P/720P, 5s) - 🔤 在

CLIP Text Encoder修改提示词 - ▶️ 点击运行

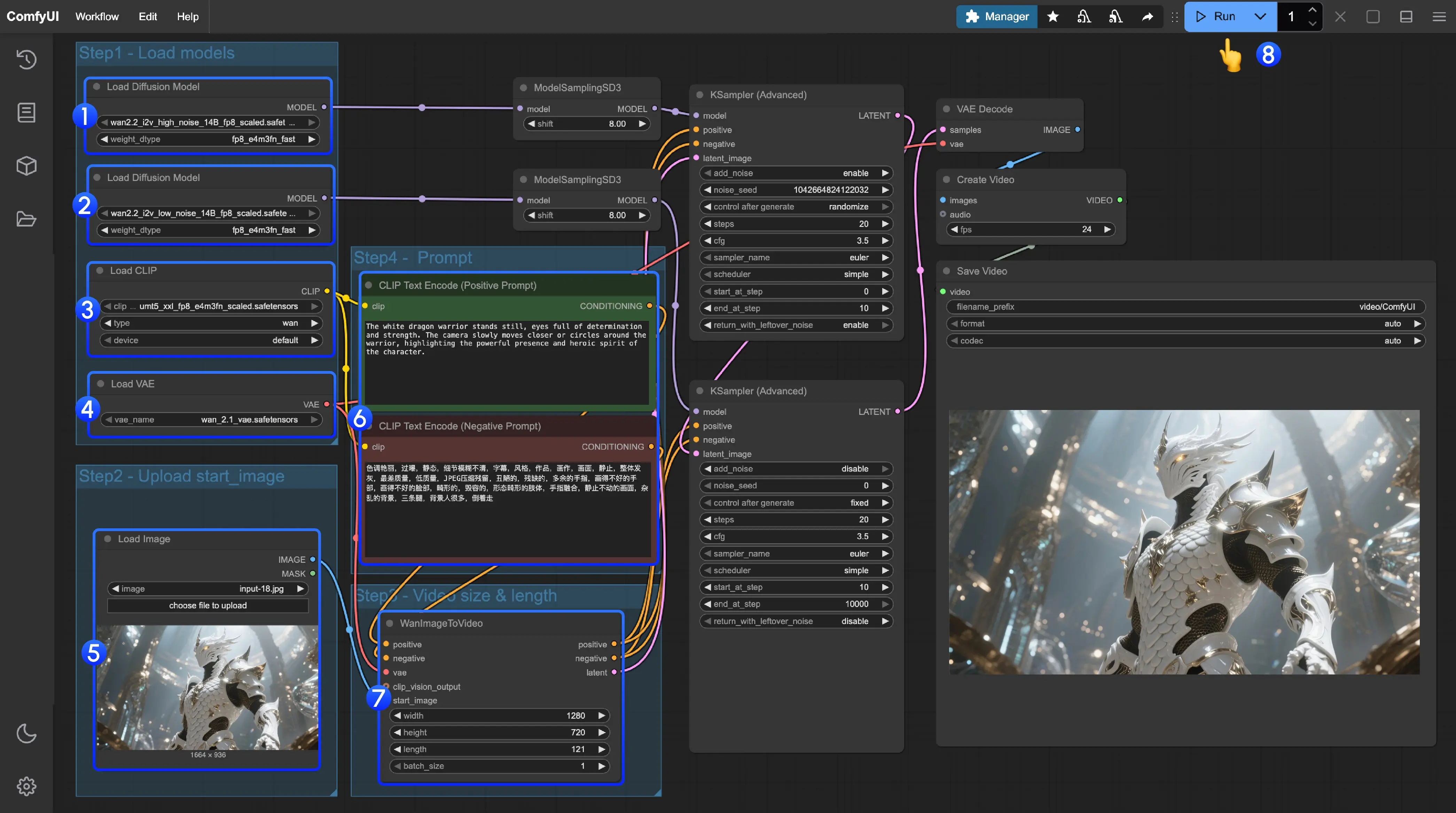

三、Wan2.2-I2V-A14B 图生视频工作流

适用于:静态图像转动态视频,如让照片“动起来”

1. 加载工作流

工作流 → 浏览模板 → 视频 → 选择 “Wan2.2 14B I2V”

或手动导入。

2. 手动下载模型

ComfyUI/

├───📂 models/

│ ├───📂 diffusion_models/

│ │ ├─── wan2.2_i2v_low_noise_14B_fp16.safetensors

│ │ └─── wan2.2_i2v_high_noise_14B_fp16.safetensors

│ ├───📂 text_encoders/

│ │ └─── umt5_xxl_fp8_e4m3fn_scaled.safetensors

│ └───📂 vae/

│ └── wan_2.1_vae.safetensors| 模型组件 | 文件名 |

|---|---|

| Diffusion Model (High Noise) | wan2.2_i2v_high_noise_14B_fp16.safetensors |

| Diffusion Model (Low Noise) | wan2.2_i2v_low_noise_14B_fp16.safetensors |

| VAE | wan_2.1_vae.safetensors |

| Text Encoder | umt5_xxl_fp8_e4m3fn_scaled.safetensors |

注意:I2V 与 T2V 的 diffusion 模型不同,请勿混用

3. 配置与运行

- ✅ 正确加载两个 I2V 专家模型

- ✅ 加载 VAE 与 CLIP 模型

- 🖼️ 在

Load Image节点上传起始帧图像(建议 720P 内) - 🔤 在

CLIP Text Encoder添加描述性提示词(如动作、风格) - 📏 (可选)调整

EmptyHunyuanLatentVideo的尺寸与帧数 - ▶️ 点击运行

模型会基于输入图像生成连贯动态,适合制作短视频、艺术动画等

常见问题与建议

❓ 为什么加载工作流时报错“节点缺失”?

- 原因:ComfyUI 版本过旧或未完整更新

- 解决:使用

git pull更新至最新 nightly 版本

❓ 是否支持显存不足设备?

- Wan2.2-TI2V-5B 支持 8GB 显存,启用 ComfyUI 原生 offload 功能可进一步降低占用

- A14B 系列建议 24GB+ 显存,或等待后续多卡支持

❓ 如何提升生成质量?

- 使用具体、结构化的提示词,例如:

cinematic lighting, slow zoom in, golden hour, realistic skin texture - 避免模糊描述如“好看”“酷炫”

- 官方提示词技巧:超详细提示词教程|玩转Wan2.2

❓显存不足怎么办?

使用第三方开发者的量化模型或kijai的第三方插件:

- ComfyUI-WanVideoWrapper:https://github.com/kijai/ComfyUI-WanVideoWrapper

- kijai版模型:https://huggingface.co/Kijai/WanVideo_comfy_fp8_scaled

- bullerwins版GGUF模型:Wan2.2-T2V-A14B-GGUF | Wan2.2-I2V-A14B-GGUF

- QuantStack版GGUF模型:Wan2.2-TI2V-5B-GGUF | Wan2.2-T2V-A14B-GGUF

相关文章