Sakana AI 发布了一项令人瞩目的研究成果:他们开发出一种名为 AB-MCTS(自适应分支蒙特卡洛树搜索) 的新算法。该算法在 ARC-AGI-2 基准测试中表现出色,显著优于单独使用 o4-mini、Gemini-2.5-Pro 或 DeepSeek-R1-0528 等主流模型。

- Algorithm Implementation: https://github.com/SakanaAI/treequest

- ARC-AGI-2 Experiment Code: https://github.com/SakanaAI/ab-mcts-arc2

更重要的是,这项研究首次实现了多个前沿 AI 模型的高效协作,为“AI 集体智能”的实现提供了新路径。

什么是 AB-MCTS?

AB-MCTS 是一种推理时扩展算法(Reasoning-Time Scaling),它使 AI 能够像人类一样通过试错不断改进解决方案,并在多模型之间动态分配任务。

简单来说,AB-MCTS 让 AI 在面对复杂问题时不再“单打独斗”,而是像一支由不同专家组成的团队那样协同工作——有时深入优化已有方案,有时重新生成新思路,甚至可以在多个 LLM 之间灵活切换,以发挥各自优势。

推理时扩展:不只是“训练后调用”

当前很多模型都在追求“训练更强”或“参数更大”,但 Sakana AI 的研究指出一个被忽视的方向:推理时如何利用更多计算资源提升性能?

这类似于人类解决问题的方式:我们不会一上来就得出答案,而是反复尝试、修改、验证。AB-MCTS 正是模拟了这一过程,通过高效的搜索机制,让 AI 在推理阶段也能“思考更久”、“试错更多”。

为何需要 AI 协作?

尽管每个大模型都能力出众,但它们各有擅长领域:

- 有的擅长代码生成

- 有的在创意写作上表现突出

- 有的则更适合执行顺序任务

将这些模型看作“AI 专家”,让他们根据问题特性自动分工,就能形成一种集体智能系统。这种系统不仅能弥补单一模型的短板,还能解决那些仅靠一个模型无法完成的问题。

例如,在某个任务中,一个模型提出总体策略,另一个负责编写具体实现代码,第三个再进行优化调整。整个流程就像多人协作的项目团队。

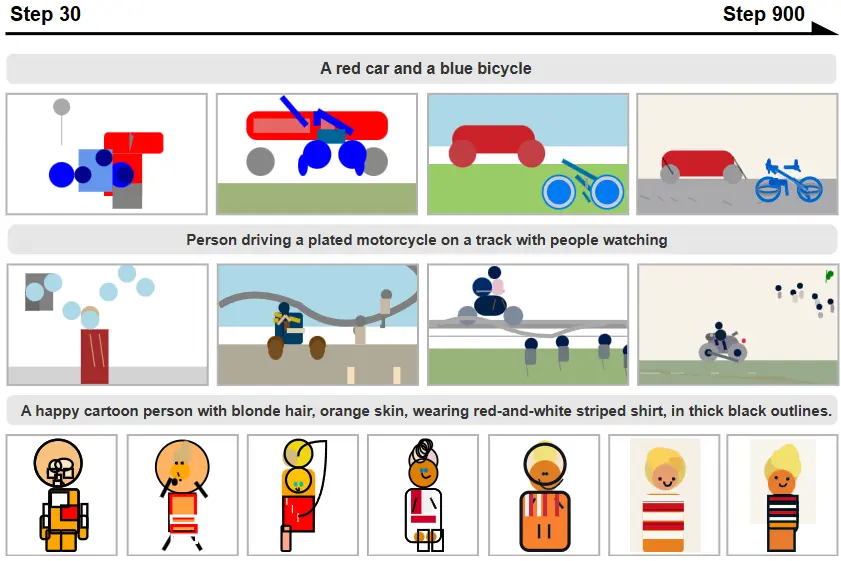

实验结果:30% 的问题被成功解决

研究人员在极具挑战性的 ARC-AGI-2 基准测试 上进行了实验。这个测试旨在评估类似人类的抽象推理能力,长期以来被认为是 AI 难以突破的难题。

实验结果显示:

| 方法 | 解决率 |

|---|---|

| 单一模型(o4-mini)+ 重复采样 | 23% |

| AB-MCTS(o4-mini) | 27.5% |

| Multi-LLM AB-MCTS(o4-mini + Gemini-2.5-Pro + R1-0528) | 30%+ |

值得注意的是,虽然 DeepSeek-R1-0528 单独表现不佳,但在 AB-MCTS 中却能与其他模型互补,最终提升了整体效果。

核心技术亮点

🧠 自适应搜索:深度 vs 广度

AB-MCTS 借鉴了 AlphaGo 中使用的 蒙特卡洛树搜索(MCTS),并引入了 汤普森采样(Thompson Sampling)来决定探索方向。

- 广度优先:生成多个新方案,寻找潜在突破口

- 深度优先:对已有方案持续优化,逐步完善

通过动态平衡这两种策略,AB-MCTS 能在有限的模型调用次数下,找到最优解。

🤝 多模型协作机制

Multi-LLM AB-MCTS 还新增了一个维度:选择使用哪个模型。

系统会根据历史表现动态调整模型权重,优先调用在特定问题上更有效的模型。这种机制使得 AI 团队能够根据问题特性“按需分配人力”,大幅提升效率。

开源工具 TreeQuest

为了让更多开发者和研究人员参与这一方向的研究,Sakana AI 同步开源了 TreeQuest —— 一个用于推理时扩展的树搜索框架。

它具备以下特点:

- 支持 AB-MCTS 和 Multi-LLM AB-MCTS 算法

- 提供灵活 API,适配各种任务场景

- 内置检查点功能,便于长时间运行和恢复

- 使用 Apache 2.0 协议,完全开源免费

展望未来

AB-MCTS 的出现标志着 AI 推理方式的一次重要演进:

- 它证明了推理时扩展的巨大潜力

- 也为构建 AI 集体智能系统提供了可行路径

Sakana AI 表示将继续围绕“进化”与“群体智能”展开研究,探索更强大的 AI 系统架构。

相关文章