近日,MiniMax 宣布推出全新大语言模型 MiniMax-M1,这是全球首款开源的大规模混合注意力推理模型,专为复杂任务和长上下文场景设计。

- GitHub:https://github.com/MiniMax-AI/MiniMax-M1

- 模型:https://huggingface.co/collections/MiniMaxAI/minimax-m1-68502ad9634ec0eeac8cf094

- DEMO:https://chat.minimax.io

该模型基于此前发布的 MiniMax-Text-01 模型进一步优化,在架构、训练效率与推理能力上实现多项突破,成为当前开源模型中最具竞争力的代表之一。

核心亮点:参数量、上下文长度与计算效率兼具

MiniMax-M1 采用 混合专家(MoE)架构 与 闪电注意力机制 相结合的设计方案,总参数量高达 4560 亿,每 token 激活 459 亿个参数,在性能与成本之间实现了良好平衡。

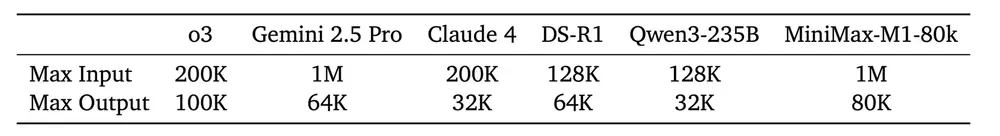

其原生支持 100 万 token 上下文长度,是 DeepSeek R1 的 8 倍,接近 Google Gemini 2.5 Pro 的水平,并提供最高 8 万 token 的输出长度,适用于超长输入处理和深度推理任务。

更重要的是,M1 在处理长序列时展现出极高的计算效率。例如,在生成 10 万 token 的情况下,其所需 FLOPs 仅为 DeepSeek R1 的 25%,显著降低了部署与推理成本。

创新技术:混合注意力 + 强化学习算法 CISPO

1. 闪电注意力机制:高效处理长上下文

MiniMax-M1 的核心创新之一是其 闪电注意力机制,它在处理百万级 token 输入时依然保持高效运算能力。例如,在进行 8 万 token 的深度推理时,其计算消耗仅为 DeepSeek R1 的约 30%,为训练和部署带来显著优势。

2. CISPO 算法:强化学习的新突破

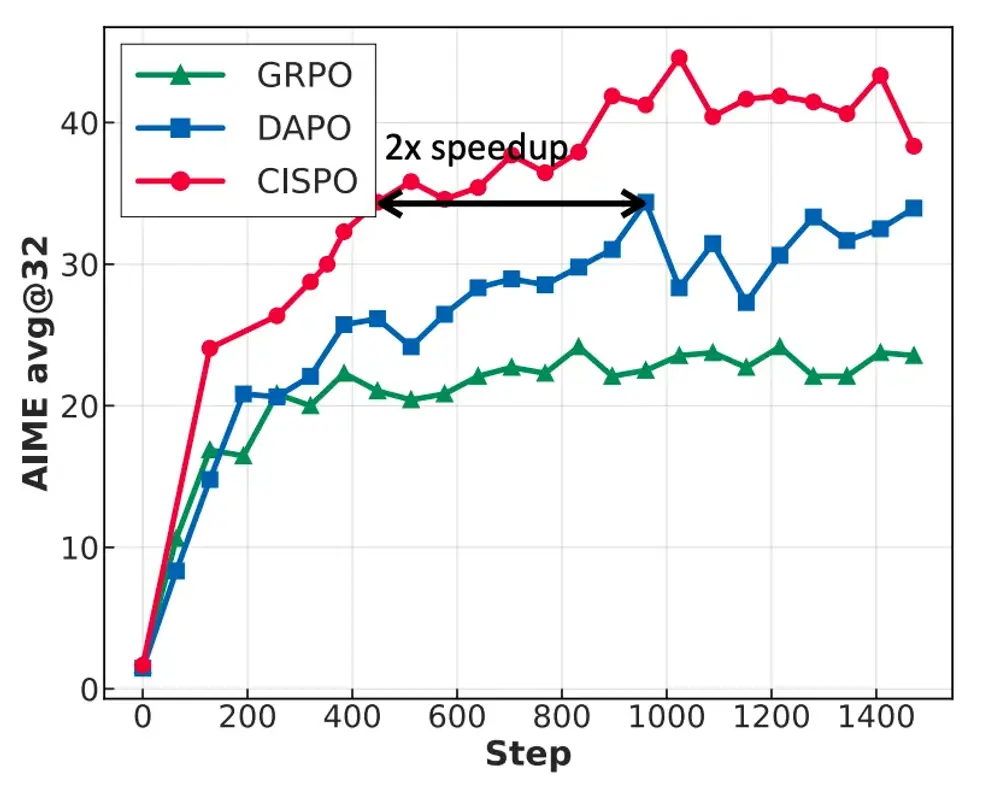

在训练方面,MiniMax 团队开发了高效的 RL 扩展框架,其中最引人注目的是新提出的 CISPO 算法。

与传统方法不同,CISPO 不依赖于对每个 token 进行更新,而是通过对重要性采样权重进行裁剪来提升训练效率。在 AIME 实验中,CISPO 的收敛速度是目前主流 RL 方法(如 DAPO 和 GRPO)的 两倍以上,大幅提升了训练效率。

得益于这些技术革新,整个强化学习阶段仅使用 512 张 H800 GPU,耗时 三周,租赁成本控制在 537,400 美元,比预期低一个数量级。

性能表现:多维度领先,尤其在软件工程与工具使用场景

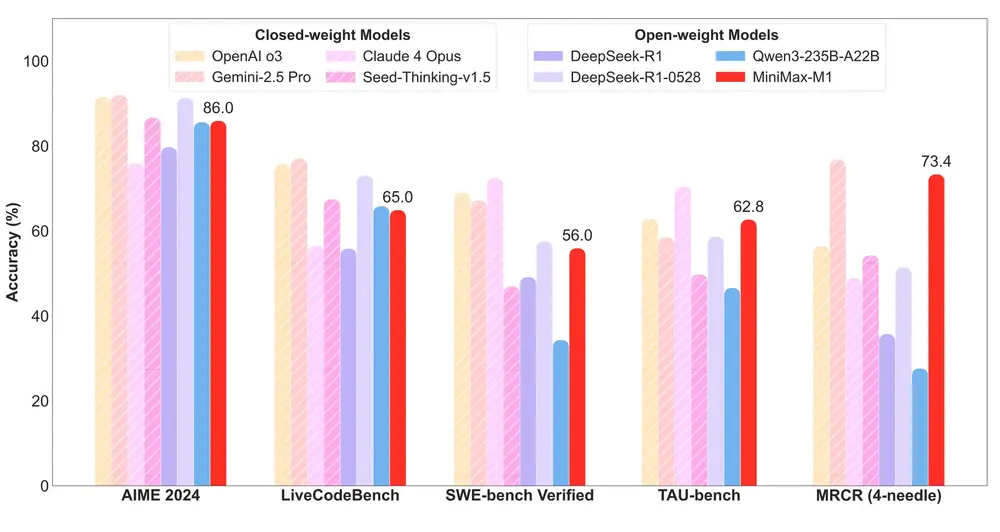

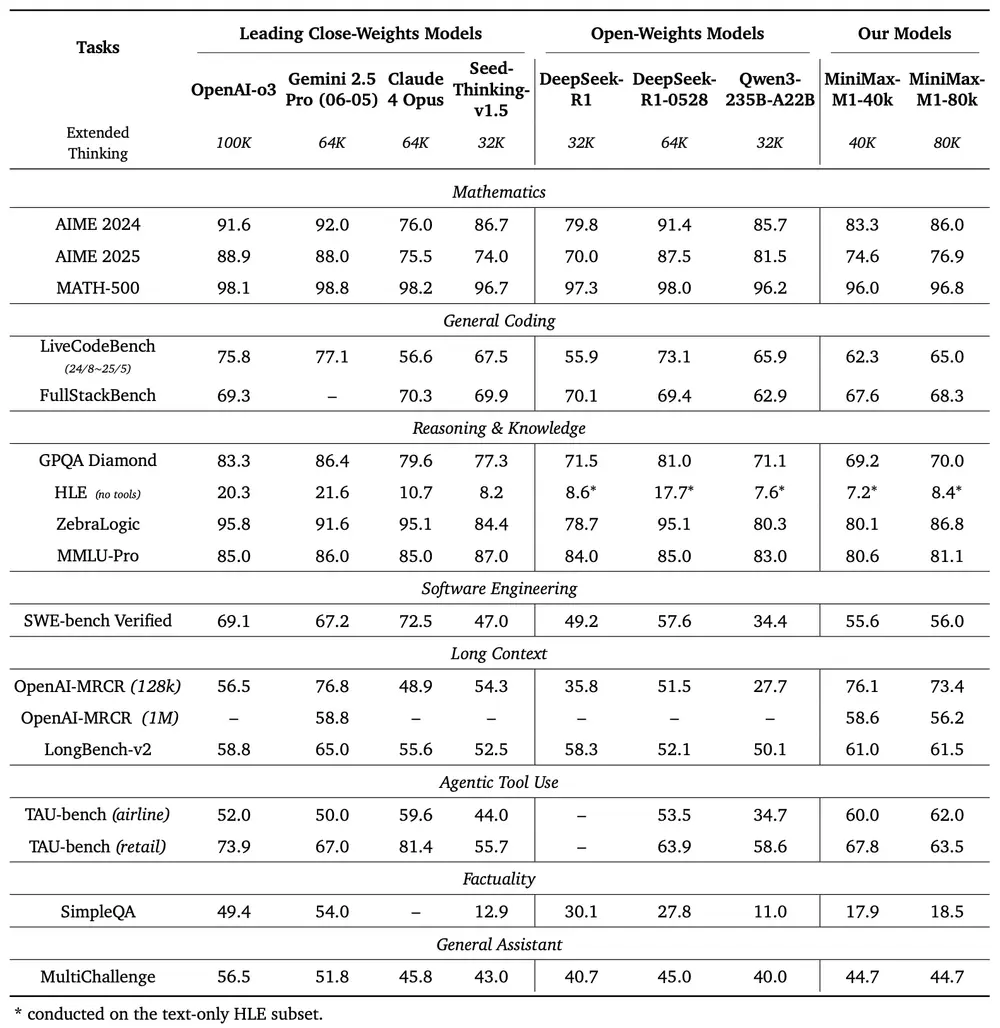

MiniMax-M1 提供两个版本,分别支持 4 万 和 8 万 token 的思考预算。在多个主流基准测试中,其表现优于其他开源模型,甚至接近部分闭源模型。

SWE-bench 验证集成绩:

- MiniMax-M1-40k:55.6%

- MiniMax-M1-80k:56.0%

这一成绩略低于 DeepSeek-R1-0528 的 57.6%,但远高于其他开源模型。

长上下文理解:

凭借百万 token 上下文窗口,MiniMax-M1 在长文本理解任务中表现优异,超越 OpenAI o3 和 Claude 4 Opus,排名全球第二,仅次于 Gemini 2.5 Pro。

工具使用能力(TAU-bench):

MiniMax-M1-40k 在代理工具使用任务中也表现出色,超过 Gemini-2.5 Pro,位列所有开源模型之首。

此外,MiniMax-M1-80k 在多数基准测试中均优于 MiniMax-M1-40k,验证了扩展推理预算的有效性。

开源开放:支持本地部署与 API 接入

为了推动模型研究与应用落地,MiniMax 已将 MiniMax-M1 全面开源,包括:

- 模型权重

- 训练与推理代码

- 技术白皮书(持续更新)

开发者可通过 Hugging Face 和 GitHub 获取相关资源。社区项目如 vLLM、Transformer 和 SGLang 也已提供部署支持。

此外,MiniMax 还在自家 APP 和 Web 平台提供 无限免费使用,并以行业最低价格开放 API 接口:

| 输入长度区间 | 输入价格(元/百万 token) | 输出价格(元/百万 token) |

|---|---|---|

| 0 - 32K | 0.8 | 8 |

| 32K - 128K | 1.2 | 16 |

| 128K - 1M | 2.4 | 24 |

相比 DeepSeek R1,前两档价格更具性价比,最后一档更是 DeepSeek 无法覆盖的范围。

展望未来:打造下一代语言模型代理的核心基础

MiniMax-M1 凭借其卓越的推理能力、高效的训练策略与低成本的部署方式,为构建新一代语言模型代理系统提供了坚实基础。

未来,我们将继续探索其在复杂软件工程、自动化工具链集成与多模态任务中的应用潜力,并持续优化模型性能与稳定性。

我们欢迎广大开发者、研究人员与企业用户共同参与 MiniMax-M1 的生态建设,一起推动开源 AI 技术的发展。

相关文章