中国科学技术大学、香港科技大学和滑铁卢大学的研究人员推出基于 Qwen2 的开源视觉语言模型Pixel Reasoner,它通过引入像素空间推理(pixel-space reasoning)的概念,显著提升了视觉语言模型(VLMs)在视觉密集型任务中的表现。传统的推理过程主要在文本空间中进行,这限制了模型在处理视觉任务时的有效性。Pixel Reasoner通过赋予VLMs一系列视觉推理操作(如放大图像和选择视频帧),使其能够直接检查、询问和从视觉证据中推断信息,从而提高了视觉任务的推理精度。

- 项目主页:https://tiger-ai-lab.github.io/Pixel-Reasoner

- GitHub:https://github.com/TIGER-AI-Lab/Pixel-Reasoner

- 模型:https://huggingface.co/collections/TIGER-Lab/pixel-reasoner-682fe96ea946d10dda60d24e

- Demo:https://huggingface.co/spaces/TIGER-Lab/Pixel-Reasoner

例如,当Pixel Reasoner被问及“基于杯子上的标志,我应该去哪里买一个这样的杯子?”时,它首先会检查视觉输入,然后通过放大图像或选择视频帧等视觉操作来迭代地细化其理解并发展推理,最终得出结论。

主要功能

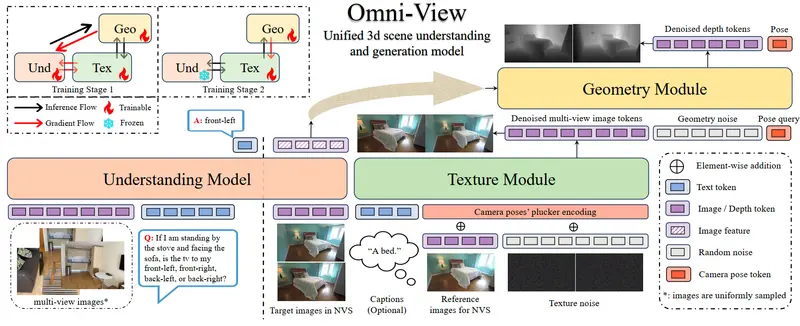

- 像素空间推理:能够直接在视觉输入上执行操作,如放大图像(zoom-in)和选择视频帧(select-frame),以增强对视觉细节的理解。

- 多模态任务处理:能够处理复杂的视觉和语言任务,如信息图问答(InfographicVQA)和视频理解(MVBench)。

- 动态视觉操作:根据任务需求动态选择和应用视觉操作,以优化推理过程。

主要特点

- 创新的推理框架:首次提出像素空间推理的概念,突破了传统文本推理的限制。

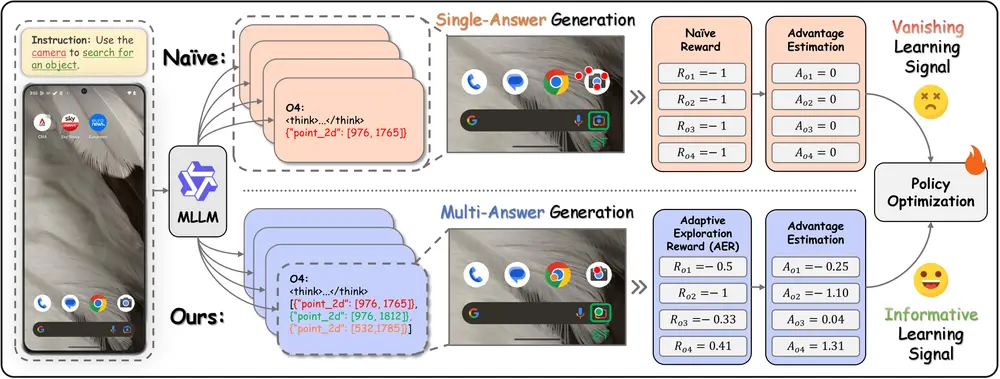

- 两阶段训练方法:结合指令微调(instruction tuning)和基于好奇心的强化学习(curiosity-driven reinforcement learning),有效培养模型的像素空间推理能力。

- 高效的数据利用:通过合成高质量的推理轨迹,为模型提供丰富的训练数据,支持其学习和优化。

工作原理

- 指令微调(Instruction Tuning):通过合成的推理轨迹对模型进行微调,使其熟悉新的视觉操作,并培养其自我修正能力。

- 基于好奇心的强化学习(Curiosity-Driven RL):利用好奇心驱动的奖励机制,激励模型探索像素空间推理,平衡视觉推理和文本推理的使用。

- 视觉操作集成:将视觉操作(如放大图像和选择视频帧)集成到推理过程中,使模型能够直接与视觉输入交互,提高推理的准确性和深度。

测试结果

Pixel Reasoner在多个视觉推理基准测试中取得了显著的性能提升。例如:

- 在V* Bench上达到了84.3%的准确率。

- 在TallyQA-Complex上达到了73.8%的准确率。

- 在InfographicsVQA上达到了84.0%的准确率。

这些结果表明,Pixel Reasoner在处理视觉密集型任务方面优于现有的开源模型,甚至超过了某些专有模型。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...