Meta 发布了其最新 AI 研究成果 —— V-JEPA 2,一个基于视频训练的“世界模型”,旨在帮助 AI 更好地理解现实世界的物理规律,并用于机器人控制、任务规划等复杂场景。

- 项目主页:https://ai.meta.com/vjepa

- GitHub:https://github.com/facebookresearch/vjepa2

- 模型:https://huggingface.co/collections/facebook/v-jepa-2-6841bad8413014e185b497a6

这一模型是去年发布的 V-JEPA(Video Joint Embedding Predictive Architecture) 的升级版,在超过一百万小时的视频数据上训练而成,目标是让 AI 像人类一样具备基础的“物理直觉”,从而在陌生环境中完成任务。

什么是“世界模型”?

“世界模型”是一种模拟环境并预测其变化的系统。它能帮助 AI 在采取行动前进行“内部思考”,就像我们人类会预判物体是否会掉落、球是否会反弹一样。

这种能力对机器人尤其重要。例如:

- 当你拿着铲子走向炉灶上的鸡蛋时,AI 可以预测下一步最可能的动作是用铲子把鸡蛋移到盘子里;

- 在冰球场上,AI 能判断球员应该滑向球将要去的位置,而不是它现在所在的地方。

这些看似简单的推理,实际上是人类通过观察世界逐步建立的常识性认知。而 Meta 正在尝试让 AI 也拥有类似的能力。

V-JEPA 2 的核心能力

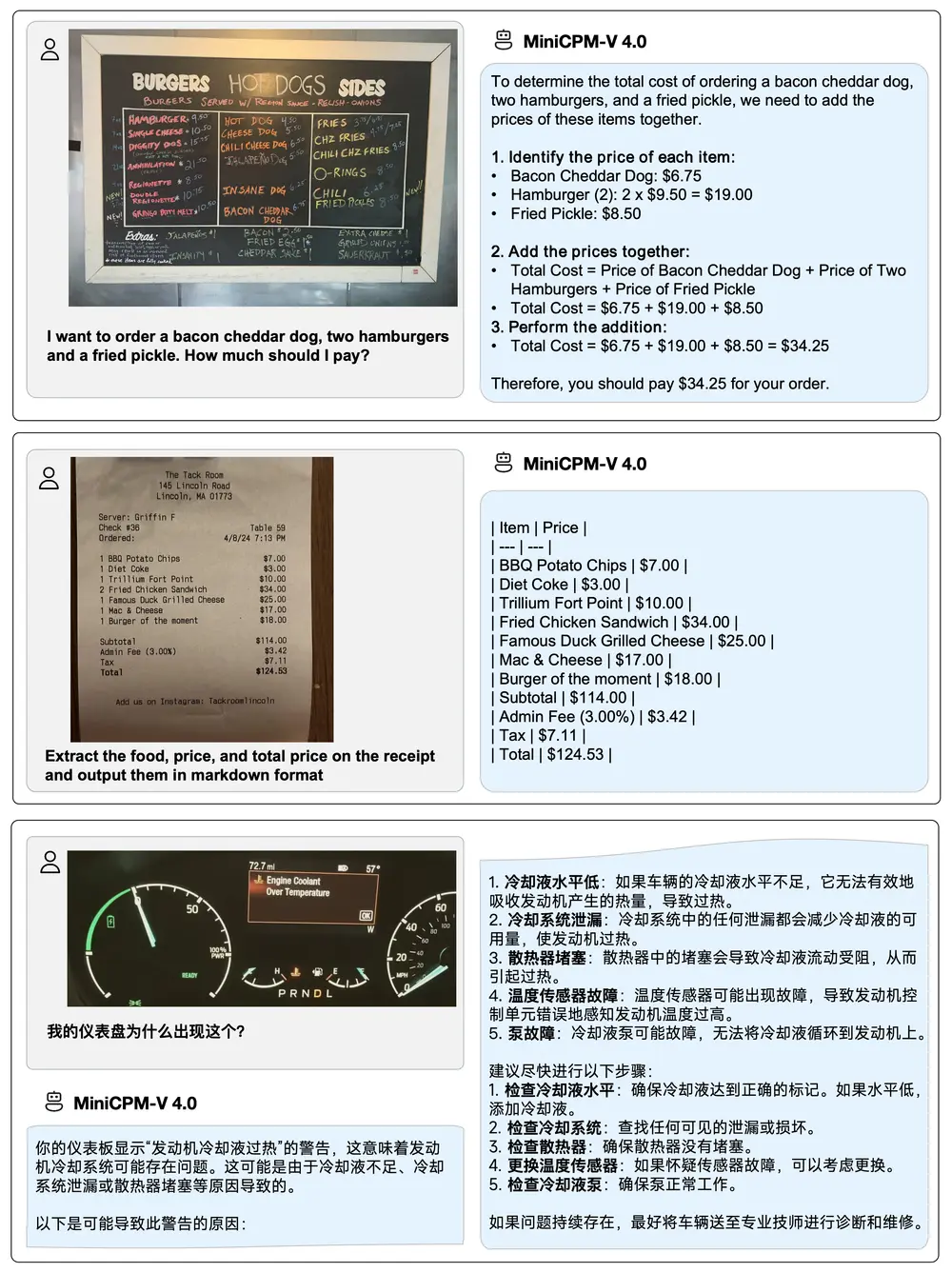

✅ 视觉理解 + 动作预测

V-JEPA 2 是首个在大规模视频数据上训练的世界模型,能够:

- 理解视频中的物体、动作和运动轨迹;

- 预测在特定动作下,世界将如何变化;

- 在没有额外训练的情况下,用于陌生环境中的机器人任务规划。

✅ 极低数据依赖

不同于传统机器人学习方法需要大量定制化训练数据,V-JEPA 2 仅使用 62 小时机器人数据,就能实现基本的拾取、放置等操作,成功率高达 65%-80%。

这表明该模型具有良好的泛化能力,适用于多种任务和环境。

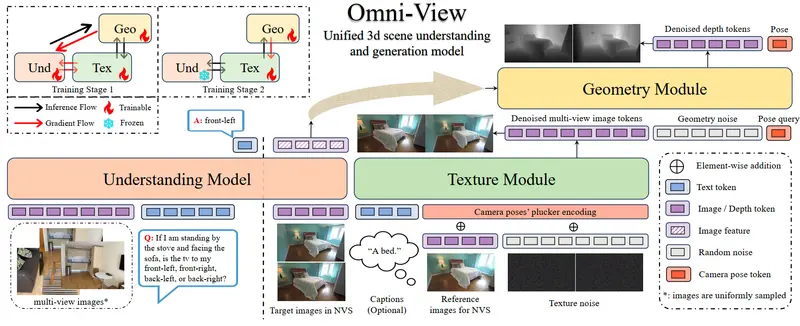

✅ 多阶段训练机制

V-JEPA 2 的训练分为两个阶段:

- 无动作预训练:使用百万小时视频和图像,学习世界运行的基本规律;

- 动作条件训练:结合机器人数据,让模型学会根据具体动作预测结果。

整个过程无需人工标注,完全采用自监督学习方式。

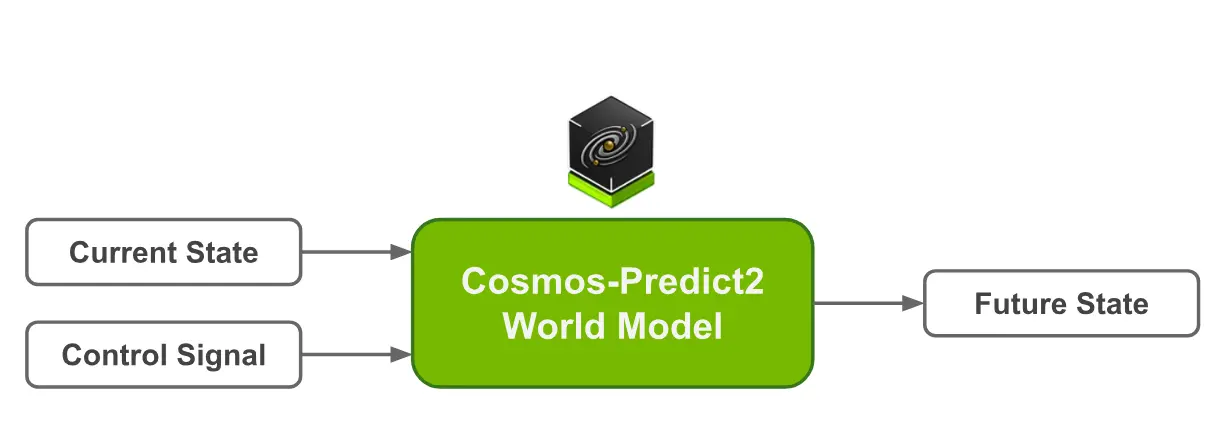

与现有模型对比

Meta 表示,V-JEPA 2 在某些基准测试中比英伟达的 Cosmos 模型快 30 倍,后者同样致力于提升 AI 对物理世界的理解能力。

不过需要注意的是,Meta 的性能评估可能基于不同的测试标准,因此不能直接等同于跨模型比较。

新推出的三大物理理解基准

为了推动研究进展,Meta 同步发布了三个新的评测基准,用于衡量 AI 模型对物理世界的理解和推理能力:

1. IntPhys 2

- 测量模型是否能识别违反物理规律的场景;

- 使用游戏引擎生成“合理 vs 不合理”的视频对;

- 类似儿童发展心理学实验,测试模型是否具备“预期违背”判断力。

2. 最小视频对基准(MVPBench)

- 通过多选题形式评估视频-语言模型的物理理解;

- 设计上避免模型依赖表面特征或文本偏见;

- 强调“最小变化”下的准确判断能力。

3. CausalVQA

- 专注于物理因果关系的理解;

- 包括反事实问题(如果…会发生什么)、预测问题(接下来可能发生什么)和规划问题(为实现目标下一步应做什么);

- 目前模型表现仍显著落后于人类水平。

这些新基准为研究人员提供了统一的评估框架,有助于推动世界模型领域的持续进步。

V-JEPA 2 的架构特点

V-JEPA 2 基于 JEPA(Joint Embedding Predictive Architecture)架构构建,包含两个核心组件:

- 编码器:接收原始视频,提取语义信息;

- 预测器:基于当前状态和动作输入,预测未来状态。

整个系统不依赖像素级重建,而是通过嵌入空间建模来高效处理复杂视觉信息。

通向高级机器智能的关键一步

Meta 首席 AI 科学家 Yann LeCun 表示:“我们相信世界模型将开启机器人技术的新时代,使现实世界的 AI 代理能够协助完成家务和其他物理任务,而无需海量的机器人训练数据。”

目前,V-JEPA 2 主要在单一时间尺度上进行建模。但许多真实任务需要多层级规划,如“洗碗”可拆解为多个步骤,“烘焙蛋糕”则涉及更长时间序列的决策。

Meta 的下一步研究方向包括:

- 开发分层 JEPA 模型,支持跨多个时间和空间尺度的推理;

- 探索多模态 JEPA 模型,整合视觉、音频、触觉等多种感官信息;

- 进一步缩小 AI 与人类在物理理解方面的差距。

总结

V-JEPA 2 是 Meta 在世界模型领域的一项重要突破,标志着 AI 在理解物理世界、执行机器人任务方面迈出了关键一步。

尽管当前模型在复杂推理和泛化能力上仍有局限,但它展示了自监督学习和嵌入空间建模的巨大潜力。

随着更多研究者加入这一方向,以及社区对新型基准和工具的支持,我们有望看到 AI 在现实世界中扮演越来越重要的角色。

相关文章