近年来,音频驱动人物动画(Audio-driven Avatar Animation)取得了显著进展,但仍有几个关键挑战尚未完全解决:

- 如何在保持角色一致性的前提下生成高度动态的视频;

- 实现角色与音频之间的情感精准对齐;

- 支持多个角色在同一场景中进行独立音频驱动。

为了解决这些问题,腾讯混元团队推出了 HunyuanVideo-Avatar —— 一款基于多模态扩散变换器(MM-DiT)的创新模型,能够生成高动态、情感可控且支持多角色对话的高质量视频。

- 项目主页:https://hunyuanvideo-avatar.github.io

- GitHub:https://github.com/Tencent-Hunyuan/HunyuanVideo-Avatar

- 模型:https://huggingface.co/tencent/HunyuanVideo-Avatar

- Demo:https://hunyuan.tencent.com/modelSquare/home/play?modelId=126

该项目不仅在多个基准测试中表现优异,还具备广泛的应用潜力。本文将为你详细介绍其核心创新、功能特性与实际应用价值。

三大核心技术创新

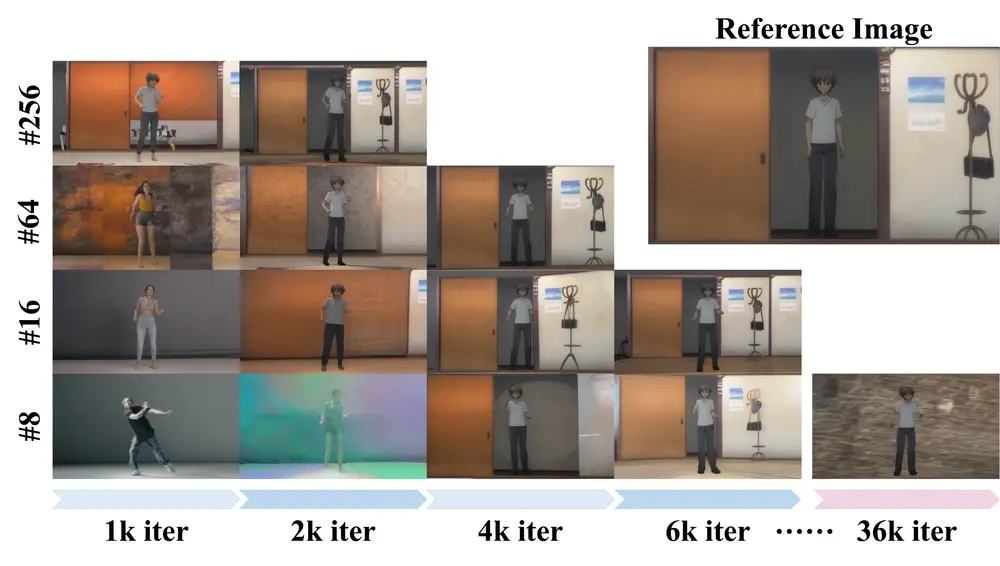

1. 角色图像注入模块(Character Image Injection Module)

传统方法通常采用“加法”方式注入角色条件信息,这种方式在训练和推理阶段存在固有的不匹配问题,影响了视频动态性和角色一致性。

HunyuanVideo-Avatar 提出了新的角色特征注入机制:

- 将角色图像特征转换为更适合模型学习的表示形式;

- 沿通道维度直接注入,避免训练与推理之间的条件偏差。

✅ 效果:更自然的动作表达 + 更强的角色稳定性。

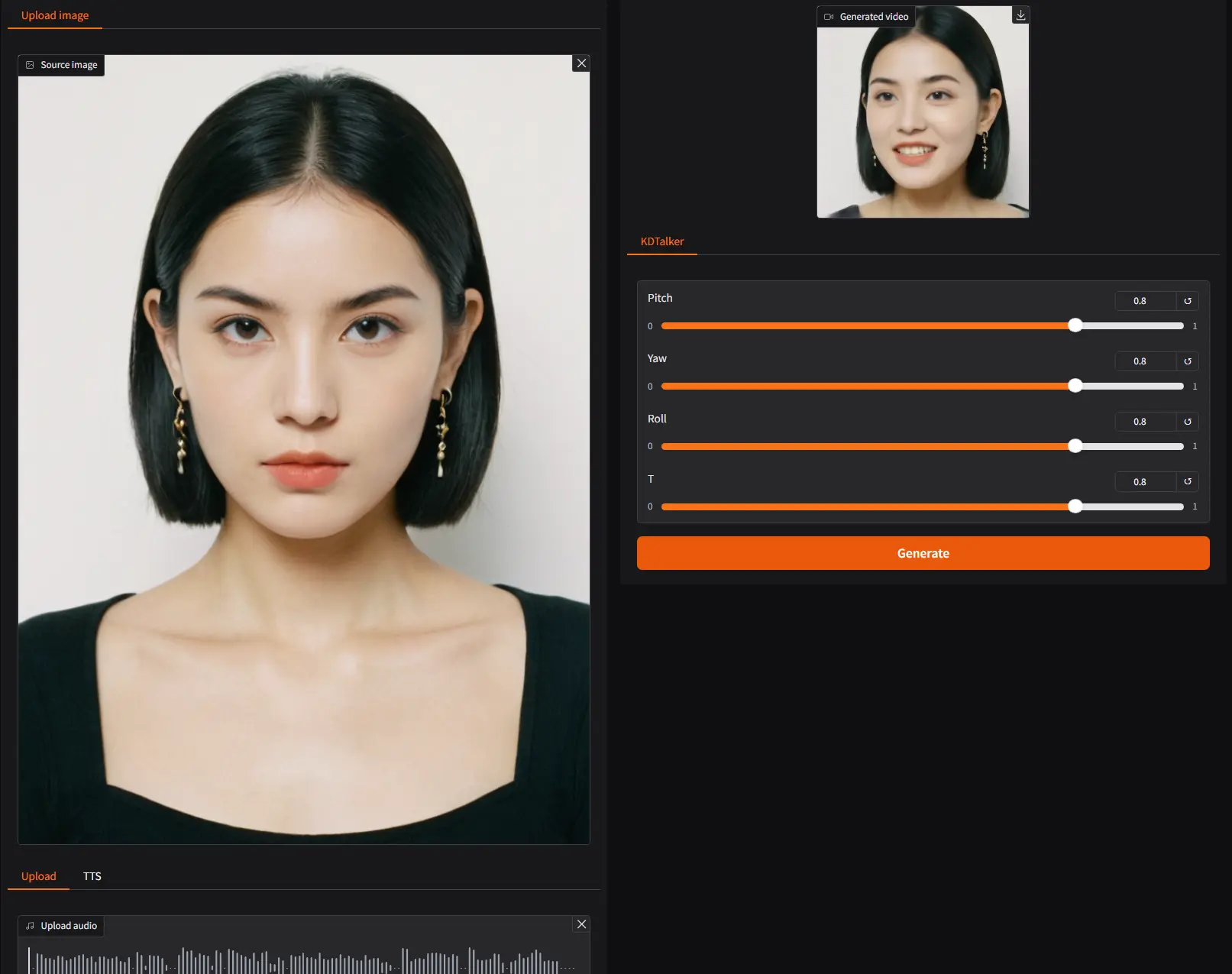

2. 音频情感模块(Audio Emotion Module, AEM)

情感是人物表达的核心要素之一。该模块从参考图像中提取情感线索,并将其映射到目标视频生成中,实现精细的情感控制。

- 可以根据输入音频中的语调、节奏等信息,调整面部表情和肢体语言;

- 适用于多种情绪状态,如高兴、悲伤、愤怒、惊讶等。

✅ 效果:让生成的视频更具“人性化”,增强沉浸感与真实度。

3. 面部感知音频适配器(Facial-Aware Audio Adapter, FAA)

在多角色场景中,如何让每个角色根据自己的音频独立做出反应是一个难题。

FAA 模块通过跨注意力机制,结合潜在空间中的面部掩码,实现了:

- 独立音频注入;

- 多角色同步响应;

- 更精确的语音-动作对齐。

✅ 效果:在多人对话、直播互动等复杂场景中,角色行为更加协调自然。

主要功能亮点

✅ 多角色动画生成

支持多个角色在同一画面中根据各自音频生成独立动画,满足虚拟会议、直播带货、剧情创作等需求。

✅ 情感可控

通过音频分析自动调节角色的情绪表达,如微笑、皱眉、点头等细节动作,提升视觉感染力。

✅ 高保真输出

生成视频具有高分辨率、丰富细节和自然流畅的动作表现,适用于头像、上半身及全身等多种场景。

工作原理简述

HunyuanVideo-Avatar 基于 多模态扩散变换器(MM-DiT)架构,整合文本、音频、图像等多模态信息,完成从音频到视频的端到端生成。

主要流程如下:

- 角色图像注入:将用户提供的头像图像编码并注入模型中,确保角色一致性。

- 音频情感处理:利用 AEM 模块提取音频中的情感特征,并与参考图像情感进行匹配。

- 音频驱动控制:使用 FAA 模块结合面部掩码,实现面部区域的独立音频驱动。

- 视频生成:最终生成包含自然动作、情感表达和唇形同步的高质量视频。

测试结果与性能指标

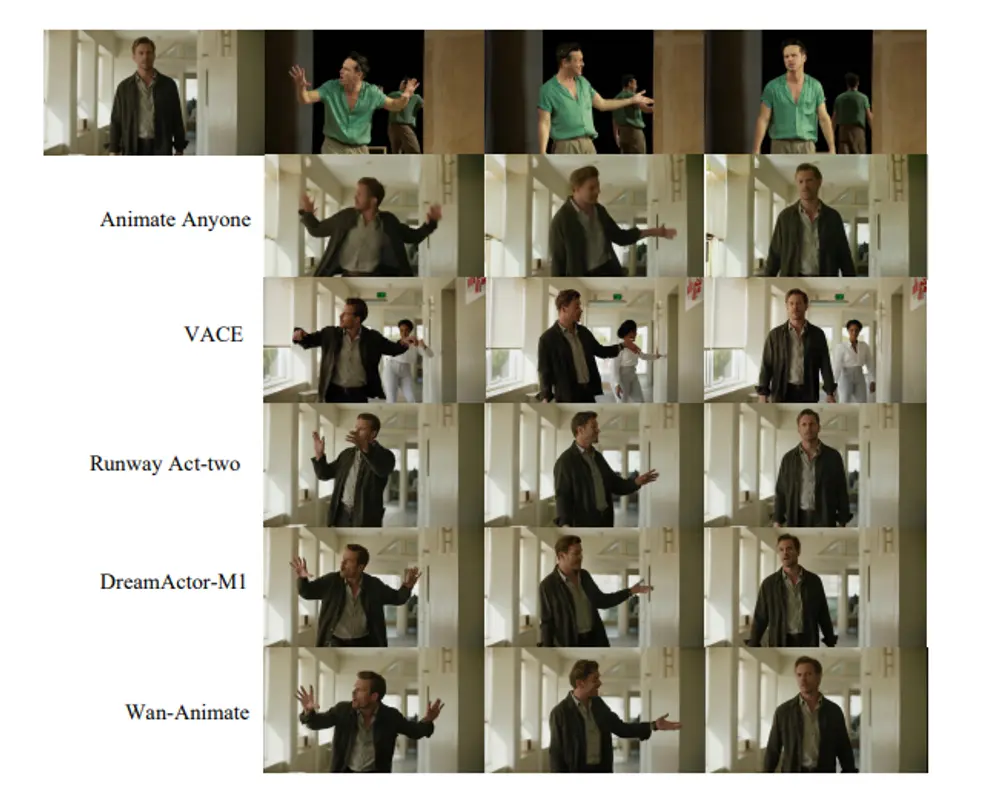

论文实验表明,HunyuanVideo-Avatar 在多个关键评价指标上优于现有方法:

| 指标 | 说明 | HunyuanVideo-Avatar 表现 |

|---|---|---|

| FID | 图像质量评估 | 显著优于SOTA方法 |

| FVD | 视频动态性评估 | 动态表现更强 |

| IQA | 视觉质量评分 | 得分更高 |

| ASE | 音频-表情同步性 | 对齐精度领先 |

| Sync-C | 唇形同步准确率 | 同步效果更好 |

此外,在自建的“野外数据集”上的测试也验证了其在复杂现实场景下的鲁棒性。

系统要求与部署建议

目前,HunyuanVideo-Avatar 是一个计算密集型模型,推荐使用高性能 GPU 运行:

- 最低配置:英伟达 GPU(CUDA支持),显存至少24GB(720x1280x129帧视频生成)

- 推荐配置:80GB 显存的GPU(如A100/H100),以获得更优的生成质量和速度

- 硬件环境:建议使用8卡GPU服务器进行训练与大规模推理

📌 注:源代码和模型权重将在未来公开发布,敬请关注官方渠道。

相关文章