阿里巴巴达摩院、浙江大学、湖畔实验室、南方科技大学和深圳大学的研究人员推出可控角色动画生成框架RealisDance-DiT,其在处理稀有姿态、风格化角色、角色与物体的交互、复杂光照和动态场景等挑战性问题时表现出色。RealisDance-DiT通过简单的模型修改和灵活的微调策略,利用强大的视频基础模型Wan-2.1,实现了在开放场景中的可控角色动画生成。

- 项目主页:https://thefoxofsky.github.io/project_pages/RealisDance-DiT/index

- GitHub:https://github.com/damo-cv/RealisDance

- 模型:https://huggingface.co/theFoxofSky/RealisDance-DiT

主要功能

- 角色动画生成:RealisDance-DiT能够根据给定的角色姿态和外观生成高质量的动画视频。例如,给定一个静态角色图像和一系列姿态序列,RealisDance-DiT可以生成角色按照这些姿态移动的视频。

- 风格化角色处理:该框架能够处理风格化角色(如动漫角色),生成符合角色风格的动画。

- 角色与物体交互:RealisDance-DiT能够生成角色与物体交互的动画,例如角色手持物体或与物体进行物理交互的场景。

- 复杂光照和动态场景:该框架能够处理复杂光照条件和动态场景变化,生成逼真的动画效果。

主要特点

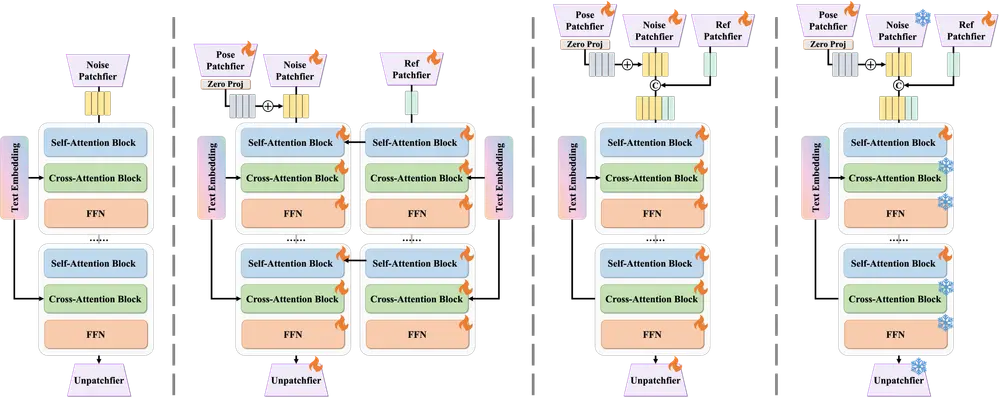

- 简单模型修改:RealisDance-DiT通过简单的模型修改(如添加条件输入层和修改位置编码)实现了强大的基线性能。

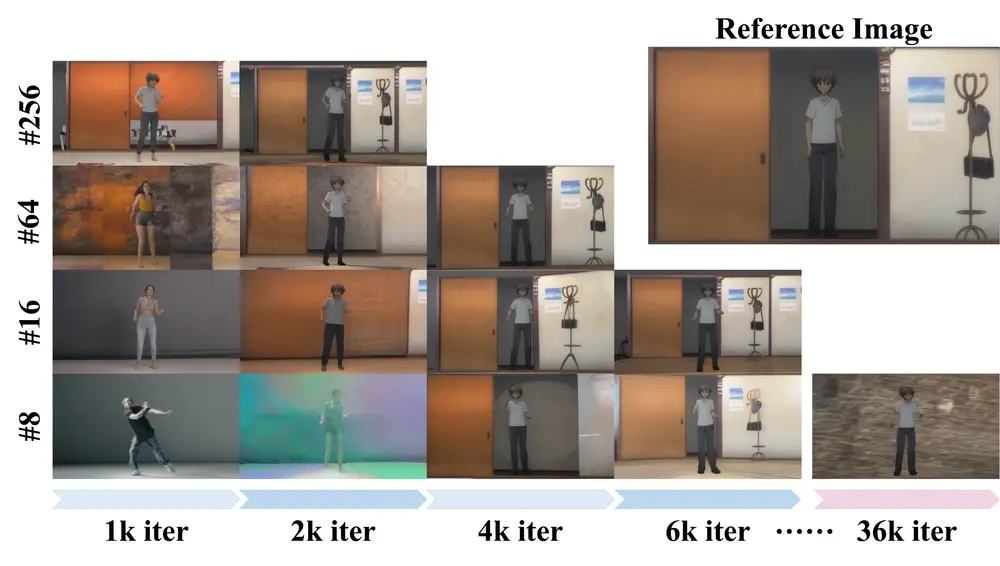

- 灵活的微调策略:提出了低噪声预热和“大批次小迭代”两种微调策略,加速模型收敛,同时最大限度地保留基础模型的先验知识。

- 强大的基础模型:基于Wan-2.1视频基础模型,RealisDance-DiT继承了其强大的生成能力和先验知识,能够适应各种下游任务。

- 开放场景适应性:通过在开放场景中的测试数据集RealisDance-Val,验证了RealisDance-DiT在处理稀有姿态、风格化角色和复杂场景时的优越性能。

工作原理

RealisDance-DiT的工作原理基于以下几个关键点:

- 模型修改:在Wan-2.1的基础上,RealisDance-DiT通过添加条件输入层和修改位置编码,实现了对角色姿态和外观的控制。这些修改使得模型能够更好地处理角色动画生成任务。

- 低噪声预热策略:在微调的早期阶段,通过减少添加的噪声量,加速模型的收敛。低噪声样本更容易被模型处理,有助于稳定微调过程。

- 大批次小迭代策略:通过使用较大的批次大小和较少的迭代次数,模型能够从更有信息量的梯度中受益,同时减少过拟合下游数据的风险。

- 推理策略:在推理阶段,通过随机丢弃参考图像和文本提示,以及优化SMPL-X模型的形状参数,RealisDance-DiT能够生成高质量的动画视频。

测试结果

- 定性评估:RealisDance-DiT在处理角色与物体交互、复杂光照条件、稀有姿态和风格化角色时表现出色。例如,在生成角色手持物体的动画时,RealisDance-DiT能够自然地处理物体的运动。

- 定量评估:在TikTok数据集和UBC时尚视频数据集上,RealisDance-DiT在FVD和FID等指标上显著优于其他方法。在RealisDance-Val数据集上,RealisDance-DiT在所有评估指标上均表现出色,特别是在FVD和FID上。

- 消融研究:通过对比不同的模型设计和微调策略,RealisDance-DiT证明了简单模型修改和灵活微调策略的有效性。例如,低噪声预热策略和大批次小迭代策略均能加速模型收敛,同时保留基础模型的先验知识。

RealisDance-DiT通过简单的模型修改和灵活的微调策略,利用强大的视频基础模型Wan-2.1,实现了在开放场景中的可控角色动画生成。它在处理稀有姿态、风格化角色和复杂场景时表现出色,为可控角色动画生成领域提供了一个强大的基线模型。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...