ComfyUI 团队正式宣布推出 API Nodes第二波大更新,此次更新不仅新增了对 大语言模型(LLM) 和 3D 资产生成 的原生支持,还引入了多个行业领先的 AI 模型接口,让创作者和开发者可以在一个统一的工作流中完成从文本、图像到视频、3D 内容的全流程生成。

🌊 Wave 2 新增亮点功能

✅ 支持的大语言模型(LLM)

现在你可以在 ComfyUI 中直接调用以下主流 LLM:

- Google Gemini 系列:

- Gemini 2.5 Pro

- Gemini 2.5 Flash

- OpenAI GPT 系列:

- GPT-4.1 / GPT-4o

- o1 / o3 / o4 等新一代推理模型

这些节点不仅可以用于生成高质量文本提示,还能实现逻辑判断、流程控制、多步骤任务串联等功能,极大提升了自动化创作与交互能力。

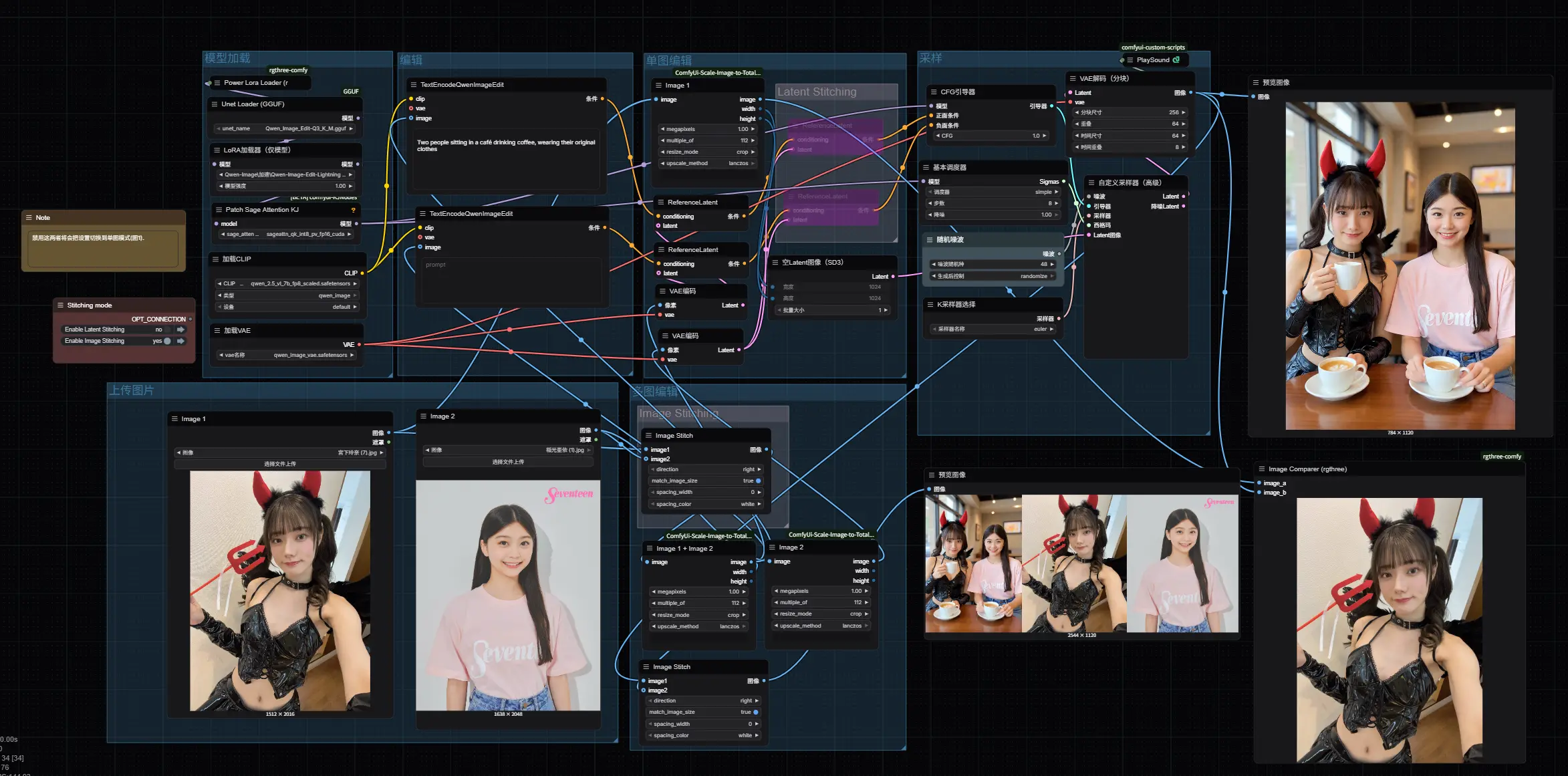

✅ 图像与视频生成新成员

Wave 2 带来了更强的媒体生成能力:

- RunwayML

- Gen-4 图像生成(支持图像参考)

- Gen-4 Turbo(快速生成)

- Gen-3 Alpha Turbo(视频风格迁移)

- Vidu(即将上线)

- 高质量视频生成模型,预计将在后续版本中开放使用

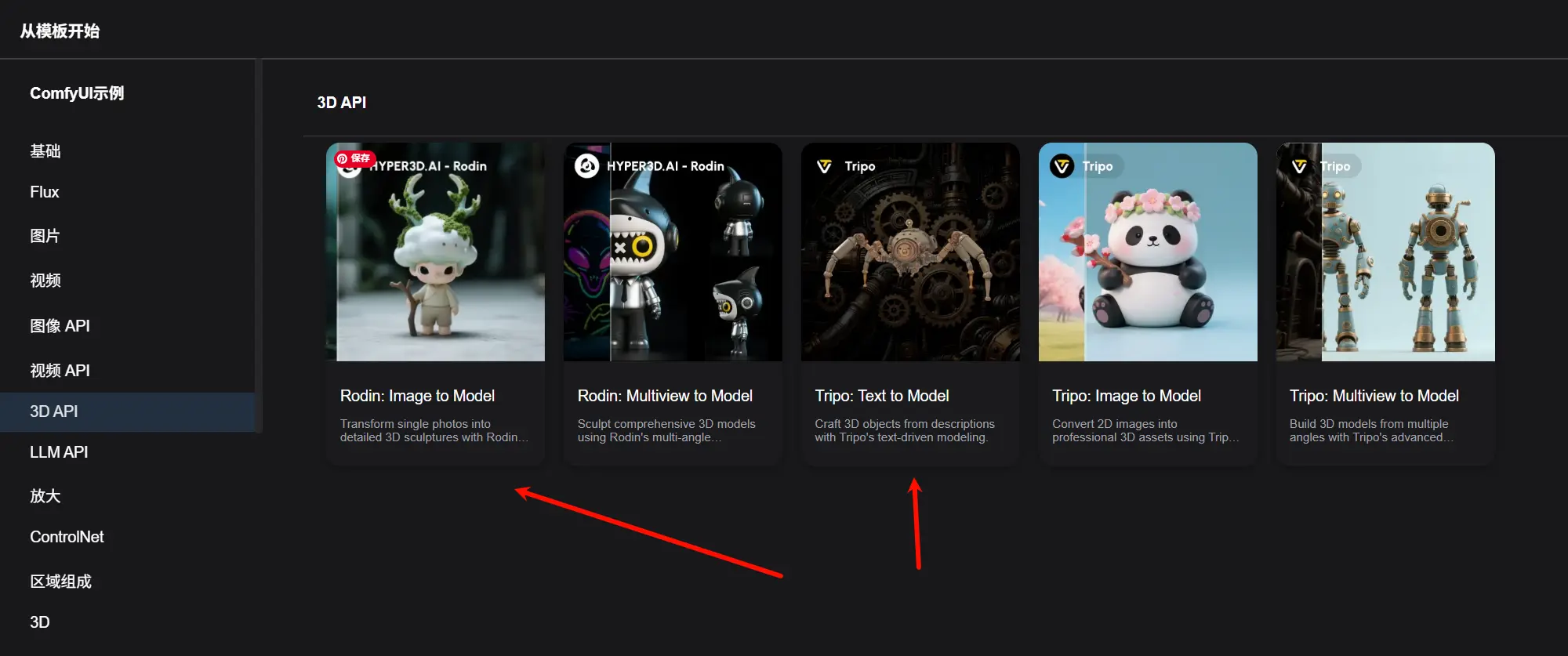

✅ 全面支持 3D 资产生成

这次更新最令人振奋的部分之一是将 3D 内容生成 引入了 ComfyUI 工作流图中,无需在多个工具之间切换即可完成从 2D 到 3D 的转换。

🔹 Hyper3D AI | Rodin

Rodin 是一个高质量的 3D 网格生成器,支持多种风格和细节控制,包括:

- 素描、常规、平滑、详细等预设

- 输出低多边形或高分辨率网格

- 可控多边形数量,便于优化渲染性能

🔹 Tripo AI

Tripo 提供了一套完整的 3D 创建管道,涵盖:

- 文本/图像/多视图输入生成 3D 模型

- 纹理编辑、绑定、网格优化

- 格式转换(如 OBJ、GLB)

工作流均可在官方工作流模板中找到

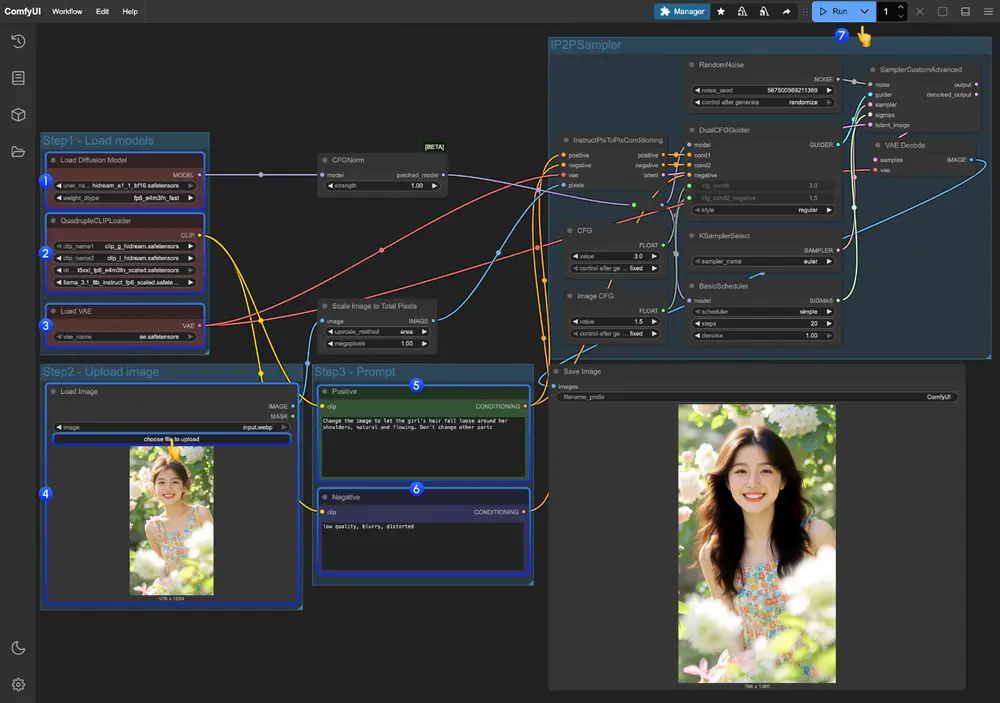

🧠 LLM API 节点全面解锁

LLM 节点现已完全集成进 ComfyUI,你可以:

- 动态生成提示词

- 实现逻辑分支决策

- 控制整个工作流流程

- 构建多步任务链(如“先写文案 → 再生成图像 → 最后合成视频”)

例如,你可以使用 Gemini 或 GPT-4o 分析一段视频内容,并自动生成描述性文本;或者由 LLM 自动生成图像提示,再交给图像生成节点执行,真正实现“AI + 自动化”的创意流程。

🔄 混合使用 API 与开源模型

ComfyUI 的强大之处在于它不仅仅是一个平台,更是一个可扩展的生态。Wave 2 进一步强化了这一理念:

- 在同一个工作流中混合使用 API 模型与本地开源模型

- 使用 Runway 图像生成 + OpenAI 提示生成 + Flux 高清修复 + Runway 视频合成

- 适用于原型设计、内容生产、批量生成等多种场景

📦 快速入门指南

想要立即体验 API Nodes Wave 2?只需几步即可上手:

- 更新 ComfyUI

- 使用最新版本或 ComfyUI 桌面版(推荐使用

nightly版本)

- 使用最新版本或 ComfyUI 桌面版(推荐使用

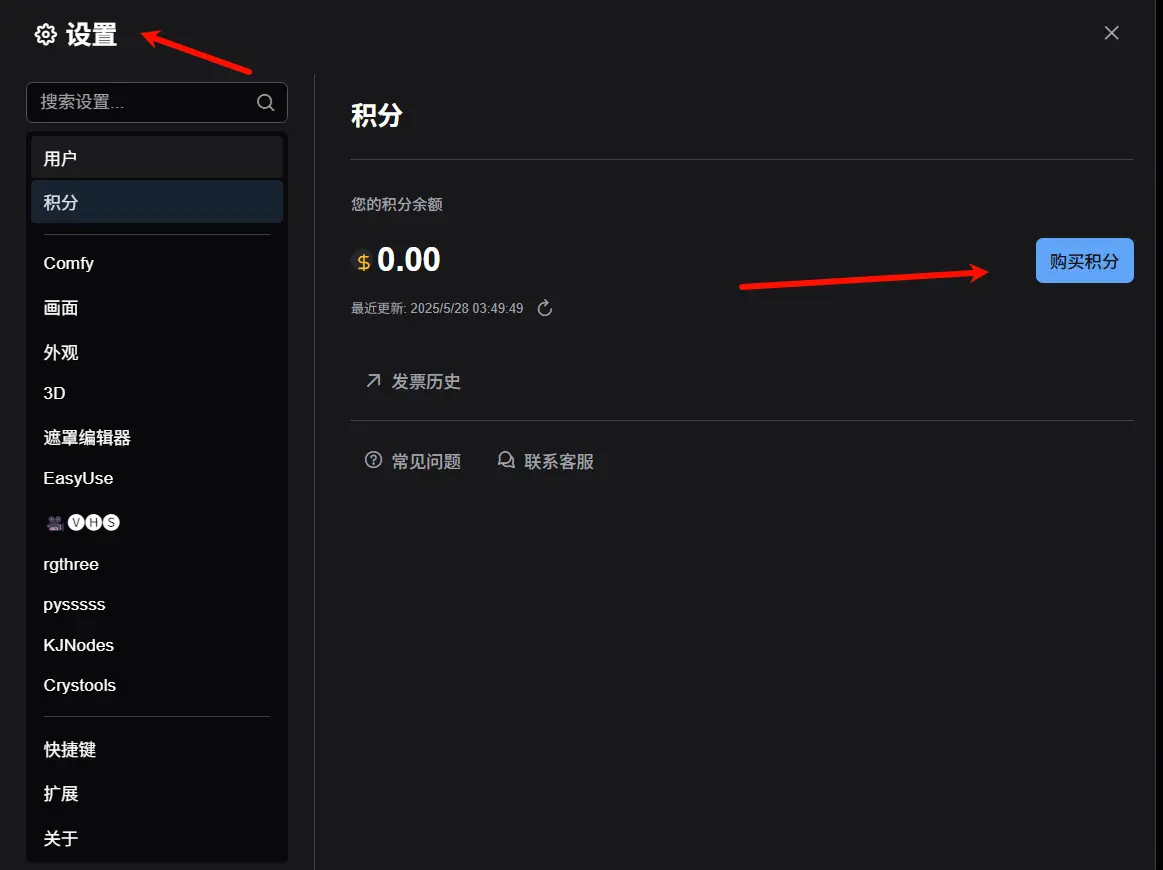

- 登录并充值点数

- 登录你的 Comfy 账号

- 在设置中购买 Credits(预付费模式,无隐藏费用)

- 加载模板

- 打开 ComfyUI,点击菜单中的 “工作流” > “浏览模板”

- 选择你喜欢的分类(图像 API / 视频 / 3D / LLM API)

- 运行工作流

- 拖拽模板节点,设置参数,点击运行即可

- 了解更多

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...