微软在今天宣布推出 Phi 系列小型语言模型(SLM)的两款新成员——Phi-4-multimodal 和 Phi-4-mini。这两款模型旨在为开发者提供更强大的 AI 功能,分别在多模态处理和文本任务中表现出色,现已在 Azure AI Foundry、HuggingFace 和 NVIDIA API Catalog 上线,供开发者探索和创新。(相关:微软正式开源了Phi-4:拥有140亿参数的小型语言模型)

- GitHub:https://github.com/microsoft/PhiCookBook

- 模型:https://huggingface.co/collections/microsoft/phi-4-677e9380e514feb5577a40e4

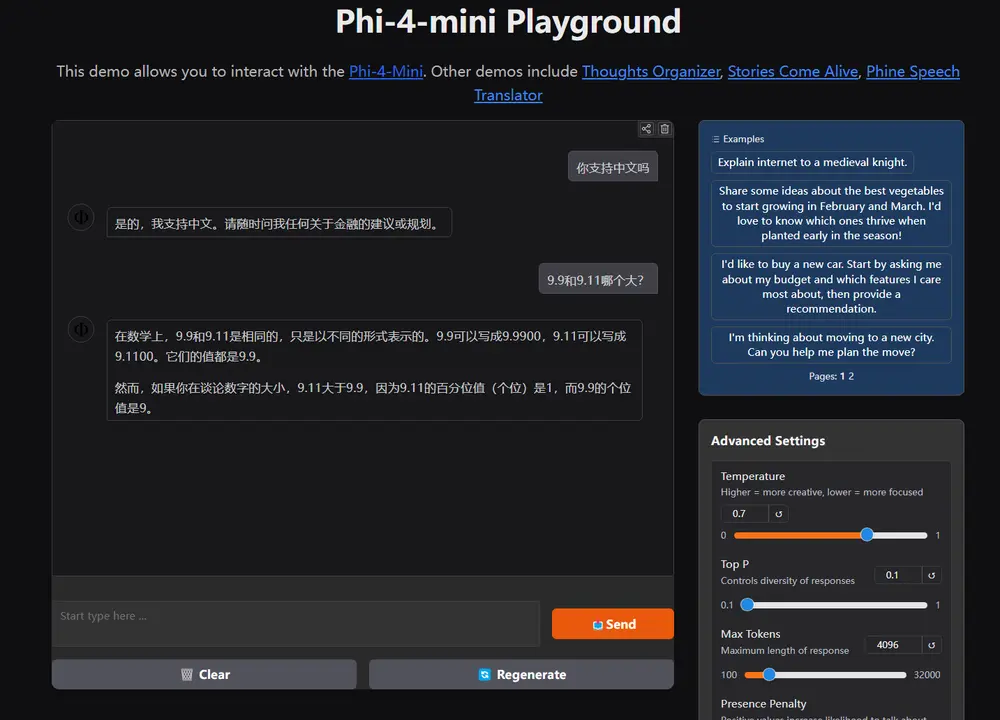

- Demo:https://huggingface.co/spaces/microsoft/phi-4-mini

Phi-4-multimodal:多模态融合的创新突破

Phi-4-multimodal 是微软首款多模态语言模型,拥有 56 亿参数,能够同时处理语音、视觉和文本信息。这一模型的开发源于对客户需求的深度倾听,将语音、视觉和文本处理无缝集成到一个统一架构中,为创新应用提供更强大的支持。

核心优势

- 高效多模态处理

Phi-4-multimodal 通过先进的跨模态学习技术,实现了自然且上下文感知的交互。它能够同时理解和推理多种输入模态,无论是语音识别、图像分析还是文本处理,都能提供高效且低延迟的推理能力。 - 强大的性能表现

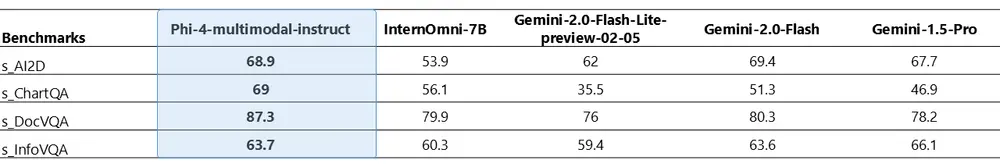

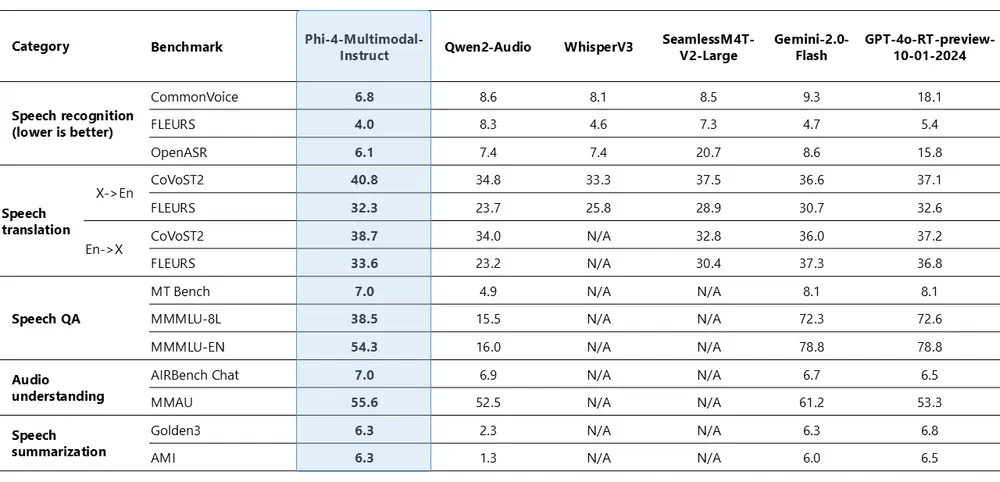

在语音相关任务中,Phi-4-multimodal 表现卓越,尤其在自动语音识别(ASR)和语音翻译(ST)方面,超越了 WhisperV3 和 SeamlessM4T-v2-Large 等专用模型。截至 2025 年 2 月,该模型在 HuggingFace OpenASR 排行榜上以 6.14% 的词错误率位居榜首。此外,它在视觉推理任务中也展现出强大的能力,尤其在数学和科学推理方面表现突出。 - 紧凑高效的架构

Phi-4-multimodal 采用了一种增强效率和可扩展性的新架构,支持多语言功能,并将语言推理与多模态输入紧密结合。它适用于在移动设备和边缘计算平台上部署,为开发者提供了一个高效且多功能的选择。

应用场景

- 智能设备集成:将 Phi-4-multimodal 集成到智能手机中,可实现语音命令处理、图像识别和文本解释等功能,提升用户体验。

- 车载系统优化:集成到汽车的车载助理系统中,该模型能够理解和响应语音指令、识别驾驶员手势,并分析视觉输入,提高驾驶安全性和便捷性。

Phi-4-mini:紧凑高效的文本处理专家

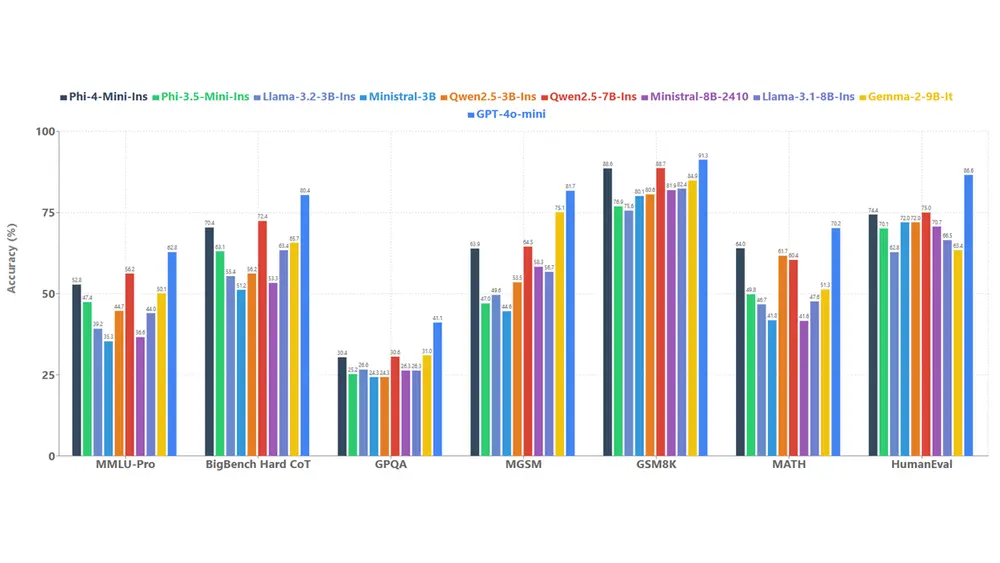

Phi-4-mini 是一款 38 亿参数的密集型解码器 Transformer 模型,专为速度和效率设计,支持高达 128,000 个标记的长上下文和函数调用。尽管体积小巧,它在推理、数学计算、编码、指令遵循和函数调用等文本任务中表现优异,甚至优于一些更大的模型。

核心优势

- 高精度与可扩展性

Phi-4-mini 在长文本处理和复杂任务中表现出色,支持高达 128K 的上下文窗口,能够处理大量文本内容,适用于文档分析、网页解析和代码生成等任务。 - 强大的函数调用能力

通过标准化协议,Phi-4-mini 能够与外部工具、API 和数据源无缝集成,实现基于代理的系统,增强模型的功能。 - 易于定制和跨平台部署

该模型的紧凑设计使其易于微调和定制,同时借助 ONNX Runtime,能够实现跨平台优化,降低计算需求,适合在资源受限的环境中使用。

应用场景

- 智能家居控制:Phi-4-mini 可作为智能家居代理,通过语音指令控制设备,提升家居智能化水平。

- 金融服务优化:集成到金融服务系统中,Phi-4-mini 能够自动执行复杂的财务计算、生成报告,并将文件翻译成多种语言,提升工作效率。

安全与保障

微软始终致力于 AI 的安全和可持续发展。Phi-4-multimodal 和 Phi-4-mini 均经过严格的安全测试,采用微软 AI 红队(AIRT)制定的策略,确保模型在网络安全、公平性和多语言支持等方面的表现符合高标准。

探索更多可能性

Phi-4-multimodal 和 Phi-4-mini 的推出为开发者带来了更多创新机会。无论是多模态应用的开发,还是高效文本处理的需求,这两款模型都能提供强大的支持。我们期待看到开发者利用这些新工具创造出更多令人瞩目的成就。更多详情可查看 GitHub 上的 Phi Cookbook,或在 Azure AI Foundry、HuggingFace 和 NVIDIA API Catalog 上体验模型的全部功能。

相关文章