悉尼大学、东南大学、中南大学、上海交通大学、商汤科技研究院和香港科技大学的研究人员推出新型视频生成框架ConFiner,它通过一系列现成的扩散模型专家(diffusion model experts)来生成高质量的视频,而无需进行额外的训练。这些专家模型各自负责视频生成过程中的不同子任务,通过协同工作生成结构合理、细节丰富的视频内容。

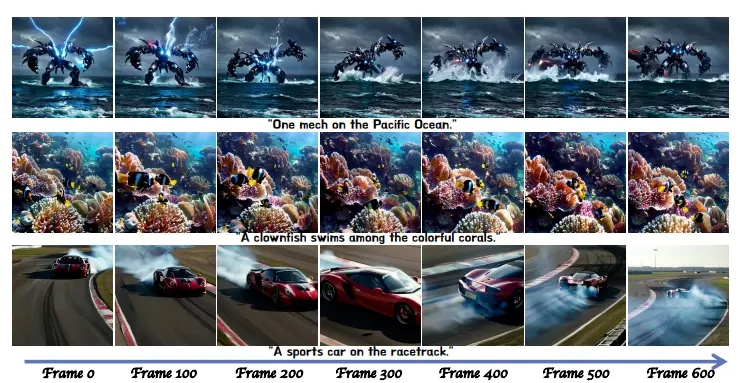

例如,你是一名电影制作人,需要快速生成一段描述“太平洋上的机械战士”的视频。使用ConFiner,你只需提供一个文本提示,系统就会通过其控制专家生成视频的基本结构,然后空间和时间专家进一步细化每一帧的细节,最终生成一段连贯、高质量的视频片段。

主要功能:

- 结构控制:生成视频的整体结构和情节。

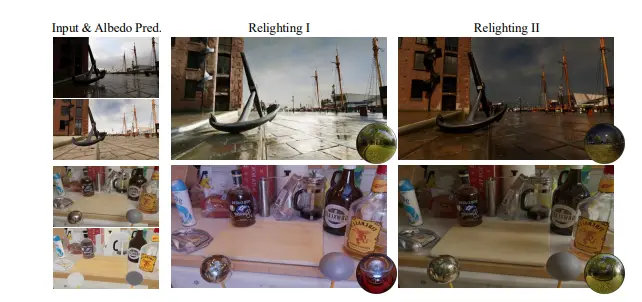

- 空间-时间细节细化:确保每一帧都具有足够的清晰度和高审美评分,并保持帧与帧之间的连贯性和一致性。

主要特点:

- 高效性:ConFiner通过解耦视频生成任务,提高了生成视频的质量和速度。

- 无需训练:利用现成的扩散模型,避免了额外的训练成本。

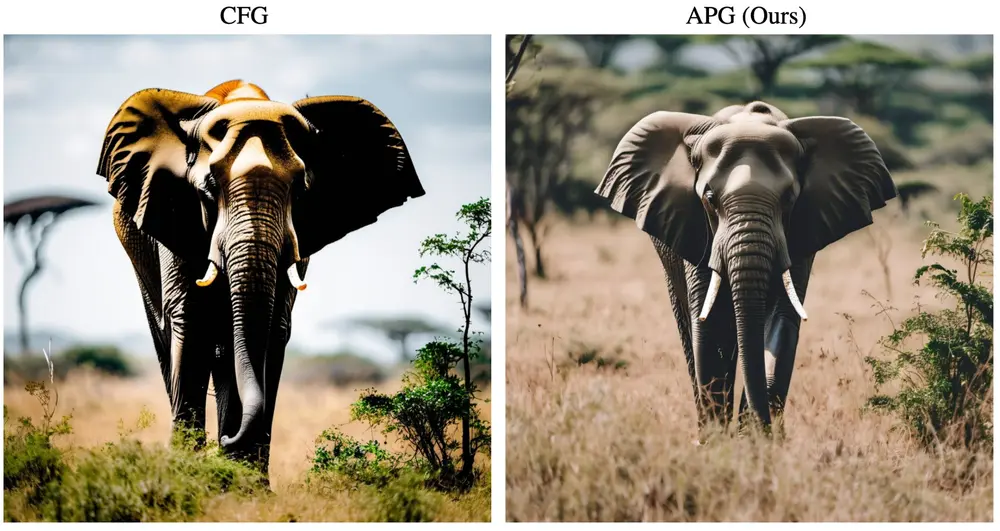

- 协调去噪:提出了一种新的去噪方法,允许在单次采样过程中同时使用空间和时间专家的知识。

工作原理:

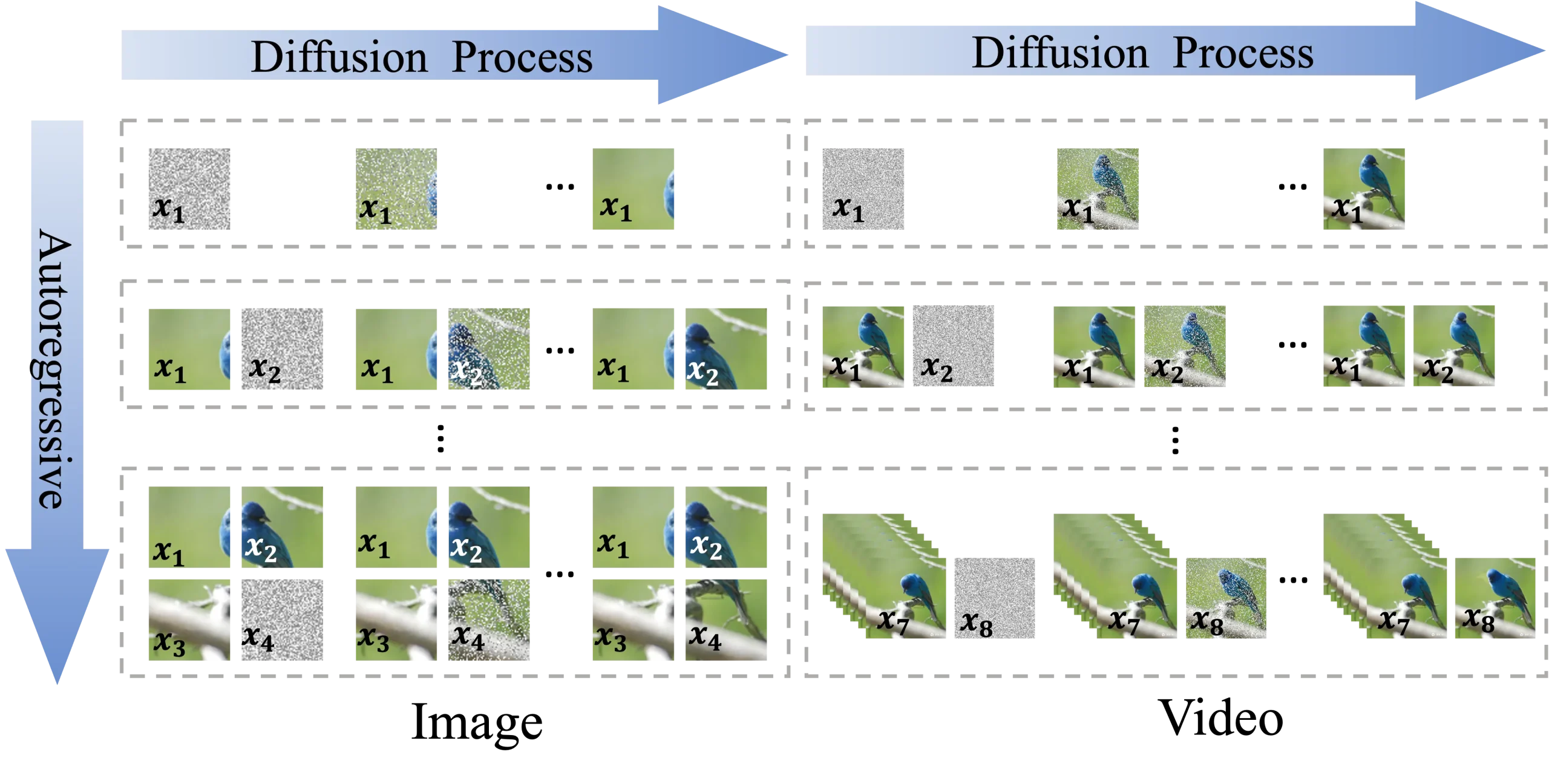

- 控制阶段:使用一个高度可控的文本到视频(T2V)模型作为控制专家,生成包含粗略空间-时间信息的视频结构。

- 细化阶段:在这一阶段,使用空间专家和时间专家基于视频结构来细化空间和时间细节。提出了一种协调去噪方法,使得两个专家能够在不同的噪声调度器下协同工作。

具体应用场景:

- 电影制作:在电影制作和动画领域,ConFiner可以用于生成高质量的视频草图或特效场景。

- 视频编辑:在视频编辑中,ConFiner可以快速生成视频内容,提高编辑效率。

- 动画生产:动画师可以使用ConFiner来生成动画序列,减少创作时间。

总结来说,ConFiner是一个创新的视频生成框架,它通过结合多个专家模型的能力,以一种高效且无需训练的方式,生成高质量且连贯的视频内容,为视频制作和相关创意产业提供了新的可能性。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...