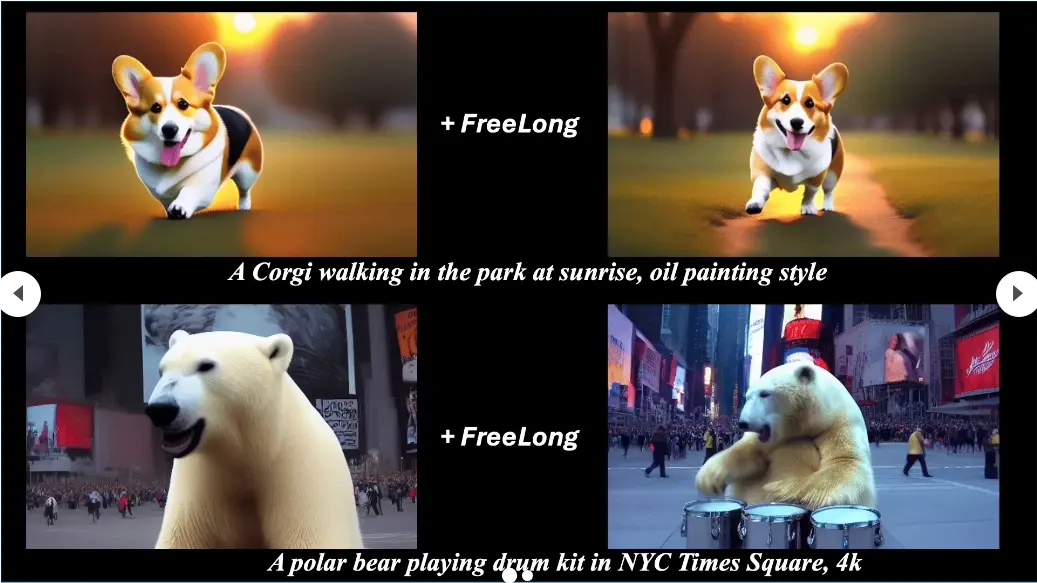

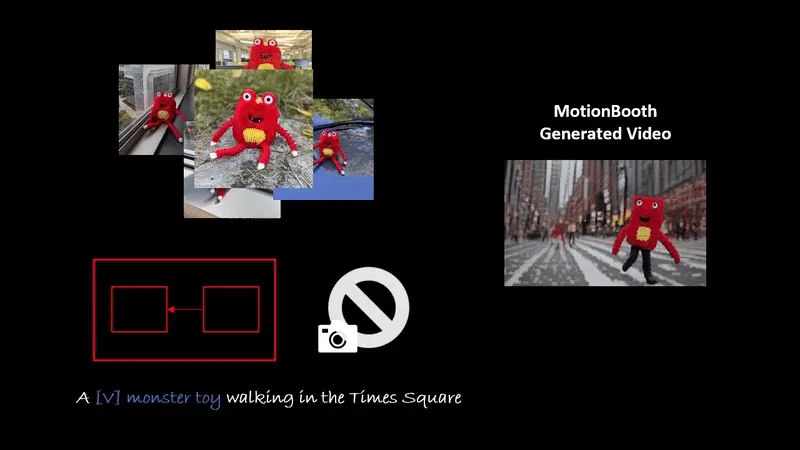

北京大学、南洋理工大学、上海人工智能实验室、浙江大学和上海交通大学的研究人员推出创新框架MotionBooth,它专门用于生成具有定制主体和可控主体及摄像机运动的动画视频。简单来说,MotionBooth可以根据你提供的一些特定对象的图片,学习这个对象的形状和属性,然后根据你的描述生成一段视频。MotionBooth在保持主题外观的同时,还能够控制生成视频中的动作,通过大量的定量和定性评估,展示了其优越性和有效性。

- 项目主页:https://jianzongwu.github.io/projects/motionbooth

- GitHub:https://github.com/jianzongwu/MotionBooth

例如,你想要生成一段视频,内容是一只猫在海滩上奔跑。你可以提供几张猫的图片给MotionBooth,然后描述你想要的视频场景和动作。MotionBooth会利用这些信息,结合它的训练数据,生成一段猫在海滩上奔跑的视频。在这个过程中,你还可以控制摄像机的运动,比如让镜头跟随猫的移动,或者在猫跳跃时做特写镜头。

主要功能和特点:

- 定制化视频生成:用户可以指定视频的主题、风格和运动。

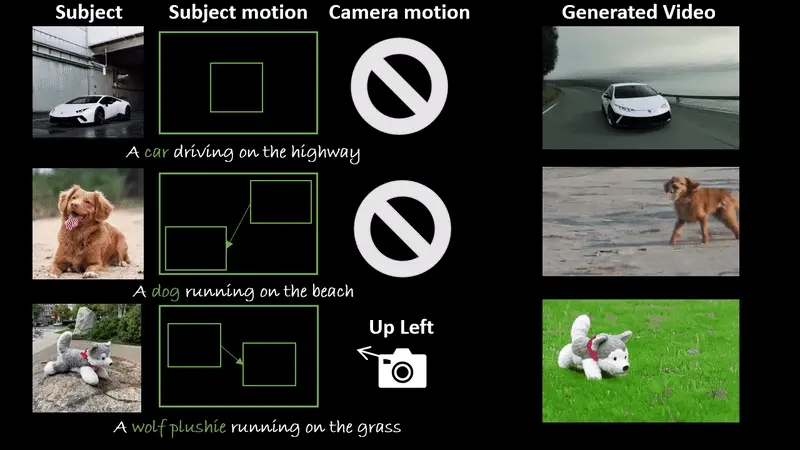

- 精确控制:MotionBooth能够精确控制视频中的主体动作和摄像机视角。

- 训练免费技术:在推理阶段,MotionBooth使用了一些无需训练的技术来管理主体和摄像机的运动。

工作原理:

- 主题学习:通过少量特定对象的图片对文本到视频(T2V)模型进行微调,以准确捕捉对象的形状和属性。

- 损失函数增强:引入了主体区域损失和视频保留损失来提高主体的学习能力,并通过主体令牌交叉注意力损失将定制主体与运动控制信号整合。

- 推理阶段控制:在生成视频时,通过直接操作交叉注意力图来控制主体运动,并引入一种新颖的潜在位移模块来控制摄像机运动。

具体应用场景:

- 个人短片制作:用户可以根据自己的创意生成个性化视频内容。

- 电影制作:在电影制作中,可以用于生成特定场景的动画草图或特效预览。

- 虚拟现实内容生成:为虚拟现实应用创造动态背景或交互式故事。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...