在 AI 图像生成工作流中,提示词质量直接决定输出上限。然而,大多数用户仍依赖手动编写或在线工具,既低效又难以与 ComfyUI 深度集成。ComfyUI Prompt Helper 正是为解决这一痛点而生——它是一套专业的自定义节点,完全在本地运行,无需联网调用 API,即可实现高质量提示词增强与系统提示提取。

- GitHub:https://github.com/flybirdxx/ComfyUI-Prompt_Helper

- 模型:https://huggingface.co/BennyDaBall/Qwen3-4b-Z-Image-Engineer-V4

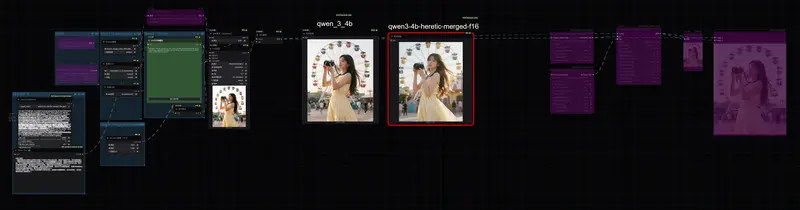

核心亮点在于对 Qwen3-4B-Z-Image-Engineer 模型的深度集成,专为当前主流图像模型(如 Z-Image、Qwen Image)优化提示结构,强调正向约束、纹理细节与电影级相机参数。

两大核心节点

1. Qwen3 Engineer:本地 GGUF 提示词增强器

- 运行方式:基于

llama-cpp-python,加载 GGUF 量化模型,在 CPU/GPU 上本地推理; - 输入:简短用户描述(如“赛博朋克城市夜景”);

- 输出:结构化、高密度的正向提示词,包含:

- 光线方向与质感(“霓虹灯反射在湿漉漉的街道上”)

- 材质细节(“金属表面带有划痕与氧化痕迹”)

- 相机设置(“85mm 镜头,f/1.4,浅景深”)

- 构图逻辑(“三分法构图,主角位于右交叉点”)

- 优势:

✅ 无需网络,隐私安全

✅ 支持 GPU 加速(通过n_gpu_layers参数)

✅ 输出可直接接入 KSampler、CLIP Text Encode 等下游节点

模型要求:需将

Qwen3-4B-Z-Image-Engineer.Q5_K_M.gguf等文件放入ComfyUI/models/text_encoders/目录。

2. System Prompt Extractor:系统提示词提取器

- 功能:提取官方或社区验证的高质量系统提示模板;

- 语言支持:英文 / 中文双语切换;

- 典型用途:

- 获取 Z-Image 官方推荐的提示结构;

- 作为其他 LLM 节点(如 Oobabooga、OpenAI Proxy)的系统指令输入;

- 对比不同语言下的提示策略差异。

- 输出示例(中文):

“你是一位专业视觉艺术家,请根据用户描述生成详细、结构化的图像提示词,包含光线、材质、镜头、构图四要素,避免负面词汇,使用正向引导。”

安装与配置

基本安装

# 1. 克隆到 custom_nodes

cd ComfyUI/custom_nodes

git clone https://github.com/your-repo/ComfyUI-Prompt_Helper.git

# 2. 安装依赖

cd ComfyUI-Prompt_Helper

pip install -r requirements.txt

# 3. 下载 GGUF 模型

# 放置至 ComfyUI/models/text_encoders/

Windows 优化(推荐)

- 使用项目提供的预编译

llama-cpp-pythonwheel 文件,避免编译错误; - 启用 CUDA 支持,实现 GPU 加速推理。

使用流程

- 启动 ComfyUI,节点自动注册:

QwenTextEngineer类别 → QwenImageEngineerPromptHelper类别 → SystemPromptExtractor

- Qwen3 Engineer 工作流:

- 选择 GGUF 模型(自动扫描

text_encoders目录) - 输入简短提示(如“日式庭院,樱花飘落”)

- 调整参数(推荐

temperature=0.8,max_new_tokens=256) - 输出连接至 CLIP Text Encode 节点

- 选择 GGUF 模型(自动扫描

- System Prompt Extractor 串联:

- 选择语言(English/Chinese)

- 将输出连接至其他 LLM 节点的

system_prompt输入端 - 实现“系统指令 + 用户提示”的完整链路

关键参数说明

| 节点 | 参数 | 建议值 | 说明 |

|---|---|---|---|

| Qwen3 Engineer | n_gpu_layers | -1(全 GPU)或 20–30(混合) | 提升推理速度 |

temperature | 0.7–0.9 | 平衡创意性与稳定性 | |

max_new_tokens | 200–300 | 避免截断关键细节 | |

| System Prompt Extractor | language | Chinese / English | 按工作流语言选择 |

为什么选择本地 GGUF?

- 隐私保障:提示词不离开设备,适合处理商业或敏感内容;

- 离线可用:无网络依赖,稳定可靠;

- 成本可控:无需支付 API 调用费用;

- 定制灵活:可替换为任意 GGUF 格式的提示优化模型。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...