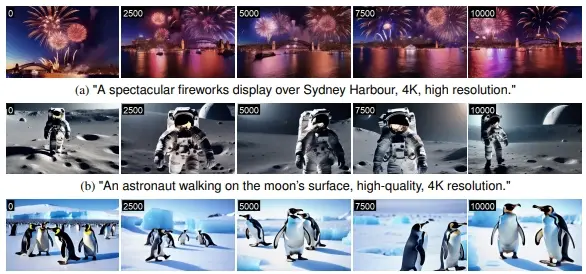

首尔国立大学推出文生视频新技术FIFO-Diffusion,它基于预训练的扩散模型,用于文本条件视频生成。简单来说,FIFO-Diffusion能够根据文本描述生成无限长度的视频,而且不需要额外的训练。这项技术的核心在于它如何有效地利用预训练模型来生成长视频,同时保持视频质量不下降,并确保场景的动态和语义得以保留。例如,你想要创建一个描述“悉尼港上空壮观的烟花表演”的视频。使用FIFO-Diffusion,你只需要提供文本描述,模型就能够生成一个4K高分辨率的烟花视频,整个过程无需任何额外的训练,而且可以生成任意长度的视频,满足不同的应用需求。

- 项目主页:https://jjihwan.github.io/projects/FIFO-Diffusion

- GitHub:https://github.com/jjihwan/FIFO-Diffusion_public

从理论上讲,FIFO-Diffusion能够在不重新训练模型的情况下生成无限长的视频。这是通过迭代执行对角去噪步骤实现的,该步骤会在队列中同时处理一系列噪声水平逐渐增加的连续帧。FIFO-Diffusion在队列头部移除一个完全去噪的帧,同时在队列尾部添加一个新的随机噪声帧。然而,对角去噪具有两面性,因为靠近队列尾部的帧可以通过向前引用利用较干净的帧,但这种策略会导致训练和推理之间的差异。为了减小这种差异,研究人员引入了潜在分区和向前查看去噪策略。

主要功能和特点:

- 无限视频生成:FIFO-Diffusion能够生成任意长度的视频,理论上可以无限长。

- 无需额外训练:与传统的基于训练的方法不同,FIFO-Diffusion不需要对长视频生成进行专门的训练。

- 高效率:通过迭代执行对角线去噪,FIFO-Diffusion能够同时处理一系列连续帧,提高了视频生成的效率。

- 质量保持:即便在视频的后期,生成的帧也能保持出色的视觉质量,没有质量下降。

- 动态和语义保持:生成的视频能够保持场景的动态变化和语义信息的一致性。

工作原理:

- 对角线去噪:FIFO-Diffusion使用对角线去噪技术,通过一个队列来处理不同噪声水平的连续帧序列。队列按照先进先出(FIFO)的原则,每次迭代从队列头部移除一个完全去噪的帧,并在尾部添加一个新的随机噪声帧。

- 潜在分割:为了减少训练和推理之间的差距,FIFO-Diffusion引入了潜在分割技术,通过增加噪声水平的离散化步骤来减少噪声水平差异。

- 前瞻去噪:利用对角线去噪的优势,FIFO-Diffusion通过前瞻去噪进一步增强了对噪声帧的去噪能力,从而提高了视频生成的准确性。

具体应用场景:

- 内容创作:FIFO-Diffusion可以用于生成电影、电视剧或视频广告的动态脚本草图。

- 虚拟现实和增强现实:在VR和AR应用中,可以根据用户的交互生成连续的视频内容。

- 社交媒体:用户可以根据自己的描述生成个性化的视频内容,用于社交媒体分享。

- 教育和培训:生成教学视频或模拟场景,用于教育和专业培训。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...