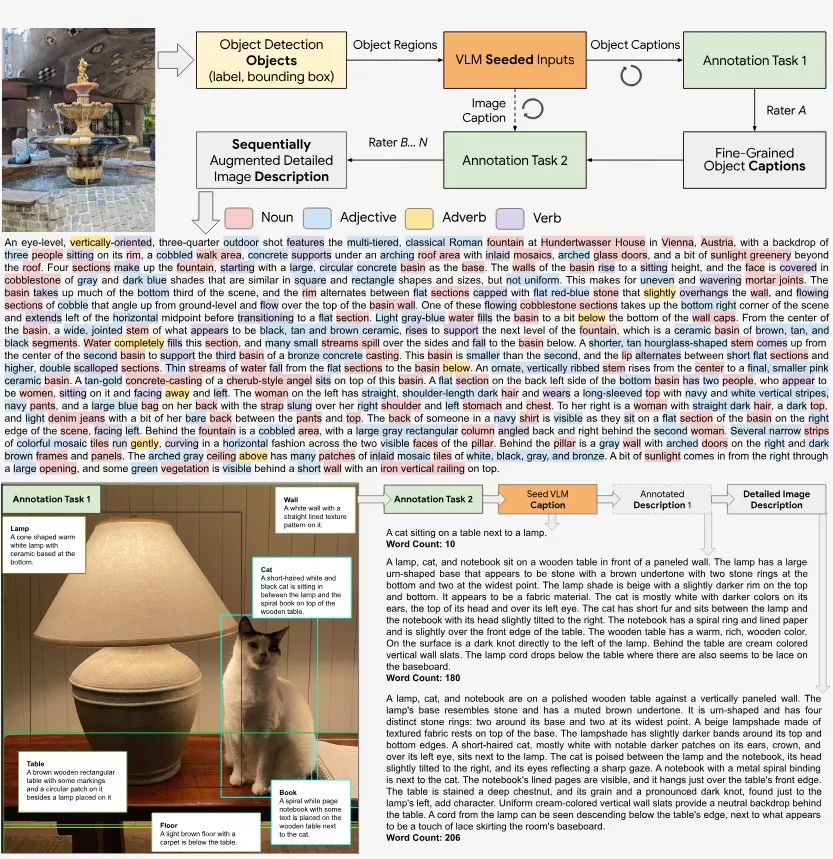

Google Research、Google DeepMind和华盛顿大学的研究团队推出新框架ImageInWords(IIW),此框架旨在创建准确且细节丰富的图像描述,以提高视觉-语言模型(VLMs)的训练效果。在日常生活中,我们经常需要描述图片内容,比如在社交媒体上分享照片时附上描述文字,或者帮助视觉障碍人士理解图片。但现有的图像描述数据集通常存在一些问题,比如描述简短、细节不足,有时还包含与视觉内容无关的信息。

- 项目主页:https://google.github.io/imageinwords

- GitHub:https://github.com/google/imageinwords

- Demo:https://huggingface.co/spaces/google/imageinwords-explorer

- 数据集:https://huggingface.co/datasets/google/imageinwords

例如,你有一张包含落日、沙滩和海浪的照片,使用IIW框架生成的描述不仅会告诉你照片中有落日、沙滩和海浪,还可能描述落日的颜色、沙滩上的脚印、海浪的形状和运动等细节。这样的描述对于训练AI模型来说是非常有价值的,因为它们提供了丰富的上下文信息,有助于模型更准确地理解和再现图像内容。

主要功能和特点:

- 超详细描述:IIW框架能够生成包含大量细节的图像描述,比如图像中物体的颜色、形状、大小,以及它们之间的空间关系等。

- 人工参与:通过一个精心设计的人工参与循环,不断丰富和优化机器生成的描述。

- 高质量数据集:IIW生成的数据集在多个维度上优于现有的数据集,比如描述的全面性、特定性、人类相似性等。

- 模型优化:使用IIW数据集微调的模型在生成图像描述时表现更好,减少了错误信息和幻觉现象。

- 多维度评估:通过自动和手动评估,证明了IIW数据集在多个方面的优势,包括文本的可读性、描述的丰富性等。

工作原理:

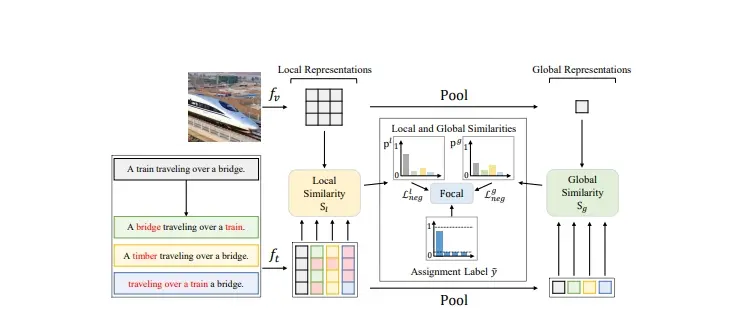

- 对象检测:首先使用对象检测器识别图像中的各个物体实例。

- 生成种子描述:视觉-语言模型(VLM)为每个检测到的物体生成详细的字幕,作为人类注释过程的种子。

- 人工丰富和修正:通过人工注释,增加和修正物体级别的描述,以提高描述的丰富性和准确性。

- 迭代优化:通过多轮注释,不断迭代优化描述,最终生成一个高质量的数据集。

具体应用场景:

- 视觉-语言模型训练:为视觉-语言模型提供更高质量的训练数据,提高模型在图像描述任务上的表现。

- 图像检索:利用详细的图像描述帮助用户更准确地搜索和检索图像。

- 辅助视觉障碍人士:为视觉障碍人士提供详细的图像描述,帮助他们更好地理解图像内容。

- 文本到图像生成:使用详细的描述作为输入,生成与原始图像更为接近的图像。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...