智谱AI最新发布的 GLM-4.7 在多个关键维度实现突破,特别是在开发者关注的编程、工具调用与复杂推理能力上,带来可观的性能提升。本文将系统梳理 GLM-4.7 的主要改进,并说明如何快速接入与使用。

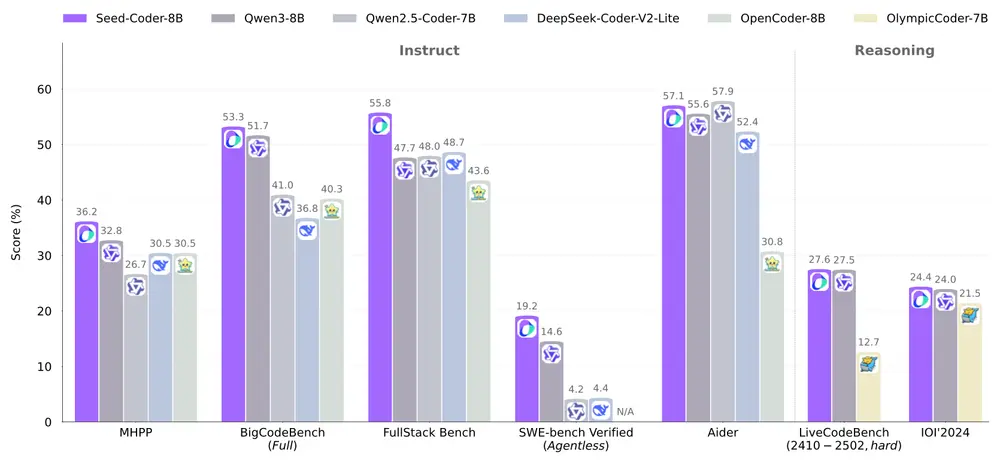

编程能力全面进阶

GLM-4.7 针对开发者工作流进行了深度优化,尤其在多语言智能体编程和终端任务处理方面表现突出:

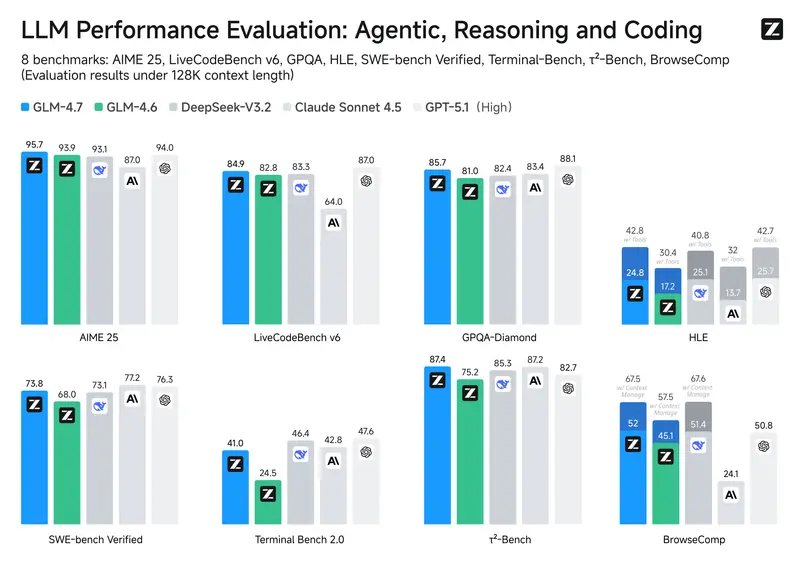

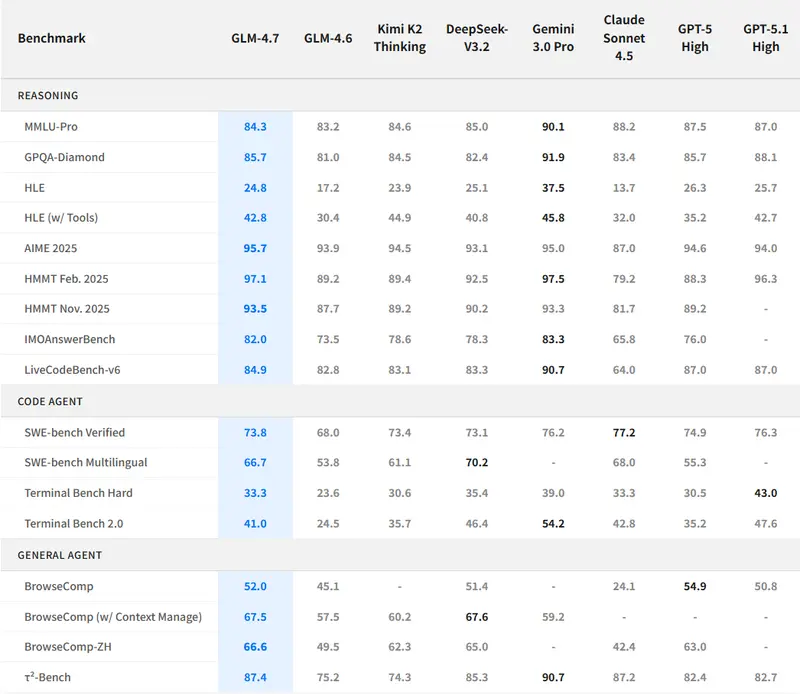

- SWE-bench(代码修复):73.8%,较 GLM-4.6 提升 +5.8%

- SWE-bench Multilingual(多语言):66.7%,提升 +12.9%

- Terminal Bench 2.0(终端指令理解):41%,提升 +16.5%

在 Claude Code、Kilo Code、Cline、Roo Code 等主流编程智能体框架中,GLM-4.7 也展现出更稳定的任务执行能力,能够更可靠地完成“三思而后行”式的复杂编程任务。

此外,在 UI 生成方面,GLM-4.7 能输出结构更清晰、样式更现代的网页代码,并能生成布局更准确、视觉效果更精致的幻灯片——这被官方称为“氛围编程”(vibe coding)。

工具调用与网页交互能力提升

GLM-4.7 在工具使用场景中也取得明显进步:

- 在 τ²-Bench(工具调用基准)中表现更优

- 通过 BrowseComp 进行网页浏览任务时,理解准确率和操作成功率均有提升

这意味着 GLM-4.7 能更可靠地与外部工具、浏览器或 API 交互,从而支持更复杂的智能体工作流。

复杂推理能力显著增强

在需要深度逻辑或数学推理的任务中,GLM-4.7 同样进步明显:

- HLE(人类终极考试)基准:得分 42.8%,较 GLM-4.6 提高 +12.4%

这一提升不仅体现在答题正确率上,更反映在多步推理的连贯性和中间结论的合理性上。

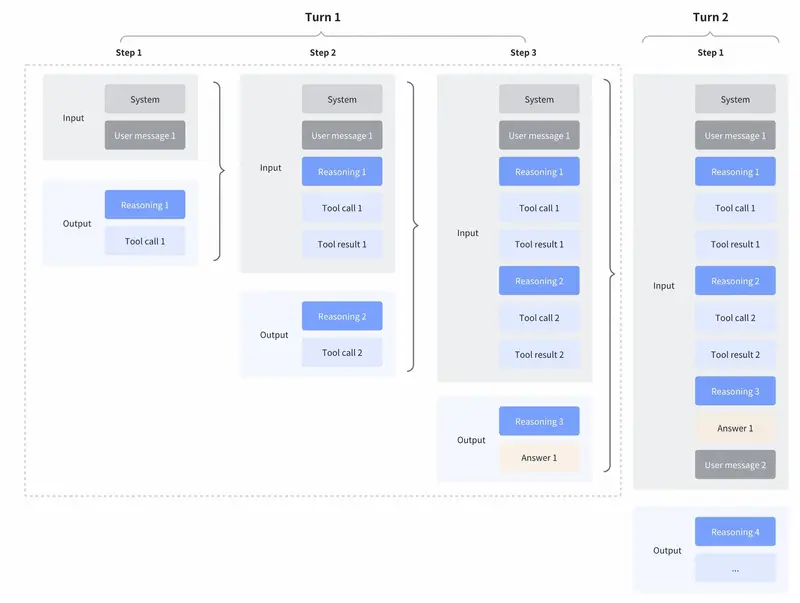

“思考”机制升级:交织、保留与轮次控制

GLM-4.7 引入并优化了三种“思考”模式,使模型在多轮对话与复杂任务中表现更稳定:

1. 交织思考(Interleaved Thinking)

自 GLM-4.5 起支持,GLM-4.7 进一步强化。模型在每次工具调用前后都会进行推理,确保每一步操作都基于最新上下文做出判断,提升指令遵循能力。

2. 保留思考(Preserved Thinking)

仅限编程端点默认开启。模型会保留前几轮的推理内容,避免在长会话中重复推导,提高一致性并减少 token 消耗。该功能目前不可手动开关,但对编程智能体尤为关键。

3. 轮次级思考(Turn-level Thinking)

允许在同一个会话中,对不同请求独立启用或关闭思考。

- 轻量请求(如“改个措辞”)可关闭思考,降低延迟与成本

- 复杂任务(如调试、规划)则启用深度推理,提升准确性

这一机制使 GLM-4.7 在智能体场景中能动态平衡效率与质量。

更多技术细节参见官方文档:Thinking Mode 说明

如何使用 GLM-4.7

1. 通过 Z.ai API 调用

GLM-4.7 已在 Z.ai 平台 提供完整 API 支持,包含 SDK、参数配置与示例代码。

2. 通过 OpenRouter 全球访问

模型也已上线 OpenRouter,兼容 OpenAI 接口,支持一键切换。

3. 在编程智能体中启用

- 现有 GLM 编程计划用户:自动升级至 GLM-4.7。若使用如 Claude Code,只需将配置文件中的模型名改为

"glm-4.7"。 - 新用户:GLM 编程计划提供 1/7 的价格 和 3 倍使用额度,对标 Claude 级编程能力。立即订阅

4. 本地部署

模型权重已在 Hugging Face 和 ModelScope 公开,支持 vLLM、SGLang 等主流推理框架。详细部署指南见官方 GitHub 仓库。

5. 网页端体验

访问 Z.ai,在聊天界面选择 GLM-4.7 即可直接试用(若未自动切换,手动选择即可)。

相关文章