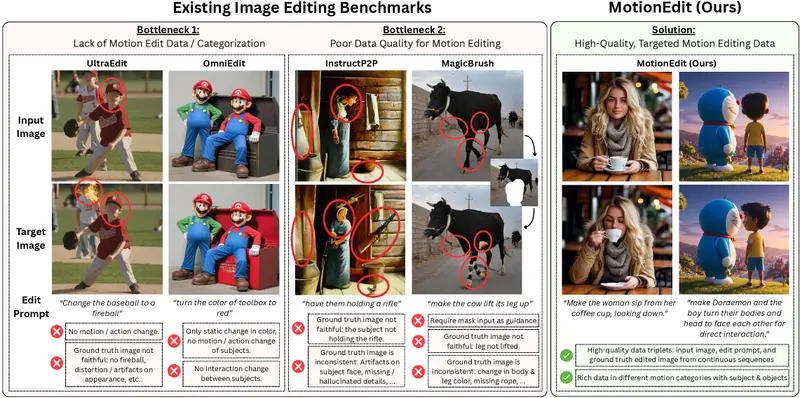

当前主流的图像编辑模型在处理静态属性(如颜色、纹理、物体替换)时已相当成熟,但在修改图像中主体的动作、姿势或交互行为时仍面临显著挑战。例如,让一个人从“站立”变为“坐下”,或让其“拿起桌上的杯子”,现有模型往往生成结果存在姿态扭曲、身份漂移、物理不合理等问题。

- 项目主页:https://motion-edit.github.io

- GitHub:https://github.com/elainew728/motion-edit

- 数据:https://huggingface.co/datasets/elaine1wan/MotionEdit-Bench

为系统性解决这一问题,腾讯 AI Lab 与加州大学洛杉矶分校(UCLA) 的研究团队提了 MotionEdit —— 一个专注于动作与交互编辑的图像编辑基准、数据集与学习框架。

核心目标

MotionEdit 致力于解决两个关键空白:

- 缺乏高质量的动作编辑数据集:现有图像编辑数据集多关注外观变化,几乎不包含动作或交互的语义对;

- 缺乏针对性的训练与评估方法:通用编辑模型未针对“运动一致性”进行优化,导致动作生成失真。

MotionEdit 数据集

研究团队从高帧率、高质量视频序列中提取连续帧对,构建了包含以下三元组的数据集:

- 输入图像(源帧)

- 文本编辑指令(如“坐下”、“伸手拿杯子”)

- 目标图像(下一帧或经人工验证的合理动作结果)

所有样本均经过严格筛选与人工验证,确保动作转换真实、自然、物理合理。这是目前首个专门面向“动作编辑”的高保真图像对数据集。

MotionEdit-Bench:动作编辑基准测试

为客观评估模型性能,团队设计了 MotionEdit-Bench,包含三类指标:

- 生成性指标:衡量生成图像的视觉质量与多样性;

- 判别性指标:通过光流(optical flow)计算编辑动作与目标动作之间的运动对齐程度(Motion Alignment Score, MAS);

- 偏好性指标:利用多模态大语言模型(MLLM)评估生成结果在身份保持、背景一致性、动作合理性等方面的综合表现。

MotionNFT:运动引导的负感知微调方法

为提升模型在动作编辑任务上的表现,团队提出 MotionNFT(Motion-aware Negative Feedback Tuning) 方法,其核心机制如下:

- 运动对齐奖励:通过光流计算输入图像与模型输出之间的运动场,与目标动作的运动场对齐,生成奖励信号;

- 语义一致性约束:结合文本指令与图像内容,确保动作语义匹配;

- 负感知微调:在训练中显式惩罚那些运动方向错误或身份失真的样本,引导模型聚焦于“合理动作”。

该方法可直接用于微调现有扩散模型,无需修改架构。

实验结果

在 MotionEdit-Bench 上的测试表明:

- 现有模型表现有限:主流扩散模型(如 FLUX.1-Kontext)在动作编辑任务上整体质量评分仅 3.84/5,MAS 为 53.73;

- MotionNFT 显著提升性能:同一模型经 MotionNFT 微调后,整体质量提升至 4.25,MAS 达 55.45;

- 用户偏好更高:在成对比较中,MotionNFT 生成结果的胜率从 57.97% 提升至 65.16%,表明其动作更自然、可信。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...