苹果推出新颖的弱监督方法CatLIP(Categorical Loss for Image-text Pre-training),旨在提高图像和文本数据集上的视觉模型预训练效率,同时保持与现有的对比学习(contrastive learning)方法CLIP相当的准确性。该方法将基于图像-文本数据的预训练任务重新构想为一个分类任务,从而彻底消除了对比损失函数中对成对相似性计算的需求,与在互联网规模数据上采用对比学习相比,实现了高达2.7倍的训练速度提升。

通俗介绍: 你有一大堆照片和相应的文字描述,你希望电脑能够通过这些照片和文字学习来更好地识别图像内容。以前的方法(比如CLIP)是通过比较照片和文字的匹配程度来学习,但这个过程非常耗时。CatLIP采用了一种新的策略,它将照片和文字的匹配问题转化为一个分类问题,这样电脑可以直接学习照片中的各种物体,而不是比较它们之间的相似度,从而大幅提高了学习速度。

主要功能:

CatLIP的主要功能是在大规模的网络图像和文本数据上预训练视觉模型,同时显著提高训练速度,并保持图像识别任务的高性能。

主要特点:

- 效率提升: CatLIP通过将对比学习转化为分类问题,实现了比传统CLIP方法快2.7倍的训练速度。

- 保持准确性: 尽管训练速度提升,CatLIP仍然保持了与CLIP相当的图像识别准确性。

- 简单性: CatLIP使用简单的二元交叉熵损失函数,而不是复杂的对比损失函数。

- 数据集规模: 它适用于从小规模到大规模的数据集,能够处理网络规模的图像-文本数据。

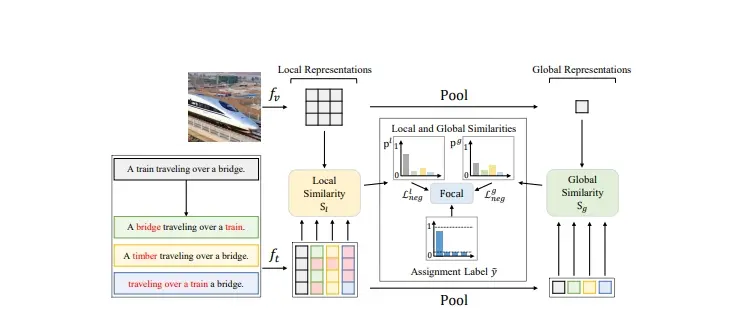

工作原理: CatLIP的工作原理包括以下步骤:

- 名词提取: 从文本描述中提取名词,并将其映射到WordNet同义词集中的同义词(synsets)。

- 分类标签生成: 利用这些同义词集作为分类标签,为每个图像生成一个多标签分类任务。

- 模型训练: 使用二元交叉熵损失函数来训练视觉模型,而不是计算图像和文本之间的成对相似度。

具体应用场景: CatLIP的应用场景包括但不限于:

- 图像分类: 在大规模数据集上预训练模型,然后在特定数据集上进行微调,以识别图像中的物体。

- 对象检测和实例分割: 使用预训练的模型来识别和定位图像中的具体对象。

- 语义分割: 在像素级别上理解图像内容,为图像中的每个区域分配语义标签。

总的来说,CatLIP通过将图像-文本预训练问题转化为分类问题,提供了一种既高效又保持高准确度的预训练方法,有助于推动大规模图像-文本数据集上的视觉模型研究。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...