AI生成视频正从“几秒特效”迈向“分钟级叙事”。

长期以来,生成高质量、长时间连贯的视频是AI内容创作的一大瓶颈。传统扩散模型虽能产出精美画面,却难以支持实时生成;自回归方法虽具备推理加速潜力,又常因内存限制导致长序列质量下降。

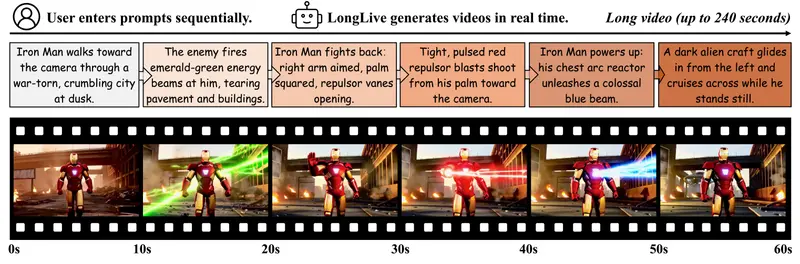

现在,英伟达推出了 LONGLIVE ——一个专为实时、交互式长视频生成设计的帧级自回归(Frame-level Autoregressive, AR)框架。它不仅突破了效率与质量之间的权衡,更首次实现了用户在生成过程中动态干预叙事的能力。

这标志着AI视频生成进入了一个新阶段:不再是“提交提示后等待结果”,而是“边生成、边引导”的协作式创作。

核心挑战:如何兼顾长视频的质量与速度?

要生成一段180秒的高清视频,相当于处理超过百万个视觉令牌(token),对计算资源和内存管理提出极高要求。现有主流方案面临两大难题:

- 扩散模型(如Wan-2.1):依赖双向注意力机制,无法有效缓存中间状态,推理速度慢,难以实现实时输出;

- 传统自回归模型:虽然可通过KV缓存提升效率,但在长序列训练中易出现上下文遗忘或视觉漂移,影响时间一致性。

LONGLIVE通过三项关键技术组合,系统性解决了这些问题:

✅ 1. 帧级自回归 + KV-recache机制

采用因果注意力结构,天然支持KV缓存以加速推理。更重要的是,引入 KV-recache 技术,在用户更改提示时智能刷新缓存状态,确保场景过渡自然、语义连贯,避免突兀跳跃。

类比:就像电影剪辑中的“淡入淡出”,让AI在换主题时不“断片”。

✅ 2. 流式长视频调优(Streaming Long-video Tuning)

训练过程直接使用长达数分钟的真实视频片段,使模型适应长程依赖,并与推理模式保持一致。这种“长训长测”策略显著提升了生成稳定性。

✅ 3. 短窗口注意力 + 帧锚点(Frame Anchors)

为缓解长序列带来的计算压力,LONGLIVE采用局部注意力窗口,同时设置稀疏的关键帧作为“锚点”,帮助模型维持全局时间一致性。

这些设计共同实现了——高保真、低延迟、可持续生成长达240秒的视频内容。

性能表现:高效且可落地

LONGLIVE并非仅停留在理论层面,其工程实现极具实用性:

| 指标 | 表现 |

|---|---|

| 模型参数 | 13亿 |

| 微调成本 | 仅需32个GPU日 |

| 推理平台 | 单块NVIDIA H100 GPU |

| 推理速度 | 20.7 FPS(满足实时播放需求) |

| 最大支持时长 | 240秒(4分钟) |

| 内存优化 | 支持INT8量化,模型体积从2.7GB压缩至1.4GB,质量损失极小 |

这意味着,即使在资源受限的环境中,也能部署运行LONGLIVE,为更多应用场景打开可能。

在VBench等标准基准测试中,LONGLIVE在短视频与长视频任务上均优于同类模型,尤其在时间连贯性和细节保留方面表现突出。

真正的创新:让用户参与生成过程

如果说过去的AI视频生成是“写剧本→拍电影”,那么LONGLIVE则开启了“导演现场指导拍摄”的新模式。

它支持流式提示输入(streaming prompts),允许用户在视频生成过程中随时调整指令,例如:

- “把主角换成穿红衣服的女孩”

- “让背景从城市转为森林”

- “加快节奏,加入紧张音乐感”

这类动态修改在过去几乎不可能实现——因为每次提示变更都会打断生成流程,造成画面断裂或风格突变。

而LONGLIVE通过KV-recache机制,能够在不中断生成的情况下平滑切换语义,实现真正的实时交互式叙事控制。

这一能力将极大赋能以下领域:

- 教育:教师可根据学生反馈即时调整教学动画内容;

- 影视原型:导演快速试错不同镜头语言与情节走向;

- 创意实验:艺术家探索不断演变的视觉叙事路径。

为什么这件事重要?

LONGLIVE的意义不止于技术指标的提升,更在于重新定义了人与AI在内容创作中的关系:

- 它打破了“一次性提示决定一切”的局限;

- 将AI从“执行者”转变为“协作者”;

- 让复杂长视频的创作门槛进一步降低。

随着AI逐步承担起视频生成的核心环节,我们需要的不再是更快的单次生成,而是可持续、可控、可干预的生成流程。LONGLIVE正是朝这个方向迈出的关键一步。

未来展望:向更长、更智能、更开放演进

尽管LONGLIVE已展现出强大能力,但仍有优化空间:

- 更长时长支持:当前上限为4分钟,未来有望扩展至10分钟以上;

- 多模态输入整合:结合语音、手势等信号增强交互维度;

- 轻量化版本开发:适配消费级显卡或移动端设备;

- 开源与生态建设:若能开放部分模型权重或推理接口,将进一步推动社区创新。

可以预见,随着类似LONGLIVE的技术普及,未来的视频创作将更加去中心化、个性化和动态化。

相关文章