腾讯混元项目组正式发布并开源HunyuanImage-3.0——当前开源社区规模最大、性能最强的文生图模型。该模型总参数量突破800亿,推理时每token仅激活130亿参数(兼顾性能与效率),基于原生多模态架构实现了“语义理解-图像生成”的深度融合,效果已比肩业界顶尖闭源模型。

- 项目主页:https://hunyuan.tencent.com/image

- GitHub:https://github.com/Tencent-Hunyuan/HunyuanImage-3.0

- 模型:https://huggingface.co/tencent/HunyuanImage-3.0

此次同步开放基础版与Instruct版模型权重,并提供完整的部署指南与提示词优化方案,为设计师、开发者等群体提供了高效的AI生图工具。

模型核心:架构与能力的双重突破

HunyuanImage-3.0的核心优势在于“架构创新”与“数据积淀”,摆脱了传统文生图模型的局限,具体可从三方面解读:

1. 突破传统的统一多模态架构

不同于主流文生图模型采用的DiT(Diffusion Transformer)架构,HunyuanImage-3.0基于自回归框架,将Diffusion(扩散模型)与LLM(大语言模型)训练深度耦合,实现了“文本理解”与“图像生成”的统一建模。这种设计带来两大关键能力:

- 长提示词理解:可精准解析长达千字的复杂提示词,捕捉用户对图像细节(如人物服饰纹理、场景光影层次)的具体要求;

- 世界知识推理:依托底层LLM的海量知识储备,能对简略提示词自动补充合理细节(例如输入“古代书生在窗边读书”,模型会自动添加“木质窗棂、案头砚台、窗外竹林”等符合语境的元素)。

2. 开源最大规模的MoE文生图模型

HunyuanImage-3.0采用MoE(混合专家模型)架构,内置64个“专家模块”,总参数量达800亿——这是目前开源社区参数量最大的文生图模型。其创新点在于“动态激活机制”:推理时仅激活130亿参数(约1/6专家),在保证模型容量(决定生图质量上限)的同时,大幅降低了计算资源消耗,平衡了“性能”与“效率”。

3. 兼顾真实感与艺术感的生图能力

模型训练依托庞大且高质量的数据集:涵盖50亿图文对、视频帧、交错图文数据,以及6万亿token的文本语料,再经强化学习后训练优化,最终实现“语义准确性”与“视觉表现力”的平衡。具体可生成:

- 摄影级真实图像(如“清晨逆光下的城市街道,路面有积水倒影”);

- 精细艺术创作(如“宫崎骏风格的乡村夏夜,萤火虫围绕老槐树”);

- 含精准文本的图像(如“复古海报,标题为‘夏日音乐节’,副标题为‘7月15日草地剧场’”);

- 漫画、表情包、教育插画等场景化内容。

模型信息与部署要求

1. 两款模型版本对比

| 模型名称 | 总参数量 | 激活参数量 | 核心功能 | 下载地址 | 显存要求 |

|---|---|---|---|---|---|

| HunyuanImage-3.0 | 80B | 13B | 基础文生图 | Hugging Face | ≥3×80GB |

| HunyuanImage-3.0-Instruct | 80B | 13B | 文生图、Prompt改写、CoT(思维链)思考 | Hugging Face | ≥3×80GB |

注:Instruct版新增的“Prompt改写”功能,可自动优化用户提示词;“CoT思考”则能拆解复杂需求(如“生成一幅包含3种动物的森林场景,每种动物动作不同”),提升生图精准度。

2. 部署硬性要求

HunyuanImage-3.0对硬件与系统环境有明确要求,需提前准备:

- 操作系统:仅支持Linux(暂不支持Windows、macOS);

- GPU:需英伟达GPU(支持CUDA),推荐4×80GB显存配置(最低要求3×80GB);

- 存储空间:至少170GB(用于存储模型权重文件);

- 软件环境:

- Python 3.12+(推荐版本);

- PyTorch 2.7.1;

- CUDA 12.8。

实用指南:从提示词到生图实操

1. 提示词优化技巧

模型效果高度依赖提示词质量,不同版本需采用不同策略:

(1)基础版(HunyuanImage-3.0)

无自动提示词优化功能,需手动编写详细描述,建议遵循“优先级框架”:主体与场景 → 图像质量/风格 → 构图/视角 → 光线/氛围 → 技术参数

示例:主体与场景:穿红色汉服的女子在庭院煮茶,桌上放着青瓷茶具;图像质量/风格:8K分辨率,写实风格,细节清晰;构图/视角:半身近景,镜头略微俯视;光线/氛围:午后自然光,柔和阴影,暖色调;技术参数:无噪点,超高对比度。

(2)Instruct版(HunyuanImage-3.0-Instruct)

支持Prompt改写,可借助官方提供的“系统提示词”优化:

- 仓库

PE目录下提供两类中文系统提示词(适配DeepSeek模型,中文效果更优):system_prompt_universal:将摄影、艺术风格提示转为详细描述(如输入“赛博朋克城市”,自动补充“霓虹灯光、全息广告牌、雨天街道、高楼错落”);system_prompt_text_rendering:针对UI、海报等含文本的图像,优化文本渲染效果(如输入“产品宣传图,标题‘无线耳机’”,自动补充“标题字体为无衬线体,颜色为深空灰,背景为浅灰色渐变”)。

- 也可直接使用腾讯元器工作流的

system_prompt_universal改写功能,无需手动配置。

2. 分辨率设置

模型支持“自动分辨率”与“手动指定”两种模式:

- 自动模式:输入

auto,模型会根据提示词内容(如“全景风景”“人物特写”)自动预测合适分辨率; - 手动模式:可指定具体像素(如

1280x768)或宽高比(如4:3“16:9)。

3. 评估参考:如何判断生图质量

官方提供两类评估维度,可用于验证模型效果:

- 机器指标(SSAE):基于多模态LLM,对图像的12个类别、3500个关键点进行对齐打分,核心看“Mean Image Accuracy”(图像级平均得分)与“Global Accuracy”(全关键点平均得分),分数越高说明“提示词-图像”对齐越精准;

- 人工评测(GSB):通过“好(Good)/相同(Same)/差(Bad)”标准对比模型与基线效果,官方在1000个提示词测试中,由100+专业评审员验证其效果优于主流开源模型。

未来规划与适用场景

1. 未来功能更新

当前版本聚焦“文生图”,腾讯混元项目组计划在后续更新中加入:

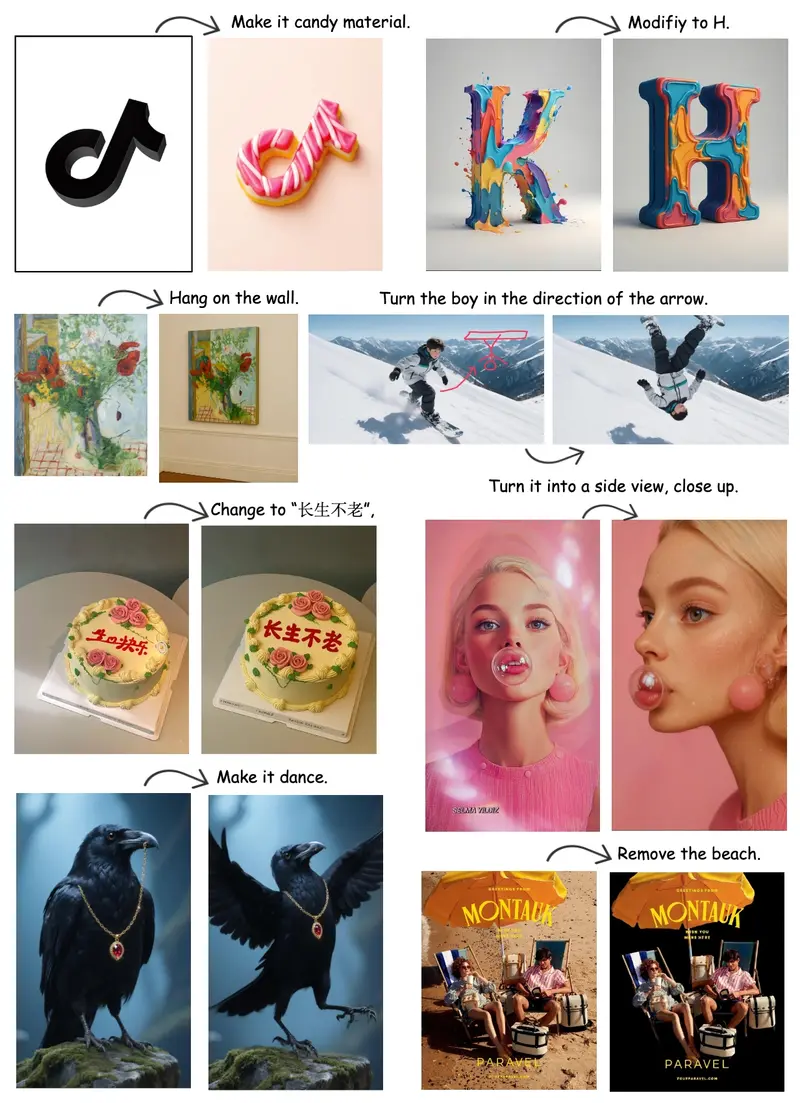

- 图生图(基于现有图像生成新内容);

- 图像编辑(如局部修改、风格转换);

- 多轮交互(支持“生成→反馈→调整”的闭环)。

2. 核心适用人群

- 设计师/插画师:快速生成创意初稿,将设计流程从数小时缩短至几分钟;

- 内容创作者:制作表情包、教育插画、自媒体配图等;

- 开发者/研究人员:基于开源权重二次开发,探索多模态生图技术。

相关文章