Google DeepMind 近日发布了其机器人专用 AI 模型的新版本——Gemini Robotics 1.5 和 Gemini Robotics-ER 1.5,标志着机器人从“执行指令”向“理解任务并自主决策”迈出关键一步。

新模型不仅能让机器人完成多步骤复杂任务,还赋予其使用网络搜索获取外部信息的能力。更进一步的是,不同构型的机器人之间可以共享经验,实现技能迁移。

从“听令行事”到“提前思考”:机器人开始具备规划能力

过去,大多数机器人 AI 的工作模式是:接收一条指令 → 执行一个动作。例如,“把杯子拿起来”或“打开抽屉”。

而这次升级的核心在于引入了“具身推理”(Embodied Reasoning)的概念。通过新的 Gemini Robotics-ER 1.5 模型,机器人可以在执行前对任务进行分步拆解和环境分析,相当于在行动前“想清楚怎么做”。

Google DeepMind 机器人部门负责人 Carolina Parada 表示:“之前的模型擅长一次执行一条指令,且通用性很强。但这一次,我们实现了对物理任务的真正理解与问题解决。”

这意味着机器人不再只是被动响应命令,而是能主动构建行动计划。

能上网的机器人:用搜索引擎辅助决策

一个显著的新能力是:机器人可以通过 Google Search 获取实时信息来完成任务。

例如,在执行“根据伦敦当前天气打包行李”这一任务时,机器人会:

- 先识别任务目标;

- 自动发起网络搜索,查询伦敦当天的气温与天气状况;

- 结合结果判断是否需要带上外套、雨伞等物品;

- 再依次完成整理、分类、装箱等操作。

类似地,在垃圾分类场景中,机器人可搜索某地具体的回收政策(如咖啡杯是否可回收),然后据此指导用户正确投放垃圾。

这种将数字工具接入物理行为决策链的做法,极大提升了机器人应对未知情境的能力。

多模态理解 + 自然语言转化:让指令更连贯

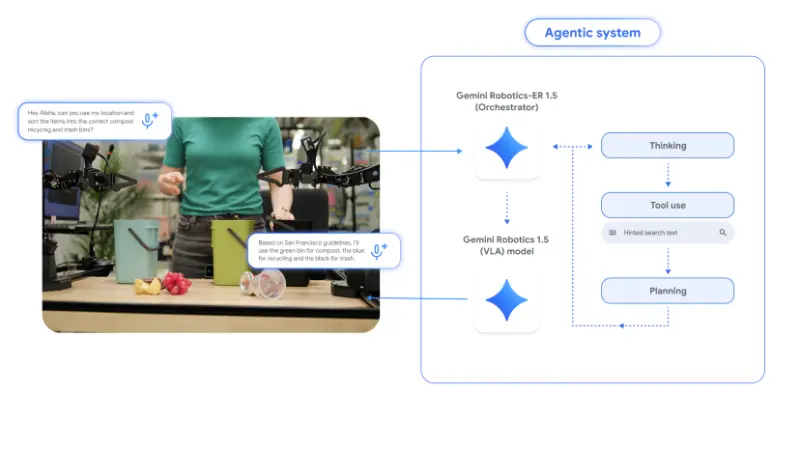

整个系统的工作流程如下:

- Gemini Robotics-ER 1.5 负责高层规划:

- 分析环境(通过视觉输入)

- 查询外部信息(如搜索天气、法规)

- 将综合判断转化为一系列自然语言子指令

- Gemini Robotics 1.5 负责底层执行:

- 接收上层生成的语言指令

- 利用自己的视觉与语言理解能力,控制机械臂完成每一步动作

这种方式类似于人类解决问题的过程:先想“要做什么”,再一步步“动手做”。

技能可迁移:不同机器人也能“互相学习”

此次更新另一项突破是:同一模型可控制多种不同结构的机器人,并实现技能迁移。

Google DeepMind 发现,训练好的策略在不同平台上具有高度通用性。例如:

- 在双臂机器人 ALOHA2 上学会的任务

- 可直接应用于 Franka 双臂系统

- 甚至适用于 Apptronik 的类人机器人 Apollo

软件工程师 Kanishka Rao 在发布会上表示:“这带来了两个好处:一是可以用单一模型控制非常不同的机器人,包括类人形态;二是,在一个机器人上学到的技能,现在可以转移到另一个机器人上。”

这大幅降低了为每种新硬件重新训练模型的成本,也为未来大规模部署机器人提供了可行性路径。

开放策略:部分功能已向开发者开放

作为更新的一部分,Google DeepMind 宣布:

- Gemini Robotics-ER 1.5 现已通过 Google AI Studio 中的 Gemini API 向开发者开放,可用于构建具备推理能力的机器人应用;

- Gemini Robotics 1.5 目前仍仅限于选定合作伙伴使用,尚未全面开放。

这意味着研究机构和初创团队现在可以基于 ER 模型开发自己的任务规划模块,再结合自有控制系统实现完整闭环。

相关文章

![ComfyUI已支持 FLUX.2 [klein]:4B 模型实现 1.2 秒本地图像生成与编辑](https://pic.sd114.wiki/wp-content/uploads/2026/01/1768500082-1768500082-FLUX.2-klein-4.webp~tplv-o4t1hxlaqv-image.image)