人脸交换(Face Swapping)技术旨在将一个人的身份特征迁移到另一个人的面部图像或视频中,同时保留目标人物的表情、姿态、发型和背景等属性。近年来,随着生成模型的发展,人脸交换已能生成高度逼真的结果。然而,一个普遍存在的问题是:在转移源身份的同时,模型常常“误伤”目标的表情细节,或未能完全剥离目标的身份信息,导致生成结果既不像源,也不够像目标应有的状态。

为解决这一问题,小红书、上海科技大学与上海交通大学的研究团队联合提出 DynamicFace ——一种基于扩散模型的新一代人脸交换框架。该方法不仅实现了更精准的身份迁移,还在表情保真、时间一致性和细粒度控制方面取得显著提升,适用于图像与视频场景。

传统方法的瓶颈

当前主流的人脸交换方法通常依赖于隐空间编辑或特征混合策略。尽管视觉效果已有明显进步,但仍面临三大挑战:

- 身份与表情耦合:身份信息与表情动态难以完全解耦,导致交换后表情僵硬或失真;

- 细节丢失:如眼动、口型变化等细微动作在生成过程中被模糊化;

- 视频闪烁:在视频应用中,帧间不一致引发闪烁、抖动等问题,影响观感。

DynamicFace 的设计正是针对这些问题展开,其核心思路是:通过可分解的 3D 面部先验实现条件解耦,并结合扩散模型的高质量生成能力,实现可控且一致的人脸重写。

DynamicFace 的三大技术亮点

1. 四种解耦的 3D 面部条件控制

DynamicFace 引入了基于 3DMM(3D Morphable Model)的四种细粒度条件输入,彼此独立、可组合使用:

| 条件 | 作用 |

|---|---|

| 背景图 | 保留原始图像背景,避免背景畸变 |

| 形状感知法线图 | 编码面部几何结构,融合源的脸型与目标的姿态 |

| 表情相关地标 | 精确捕捉目标的表情动态(如嘴角上扬、皱眉) |

| 身份移除的 UV 纹理图 | 提取目标的光照与皮肤质感,但去除身份特征,防止干扰源身份注入 |

这些条件在潜在空间中作为引导信号输入扩散模型,使生成过程更具可控性与物理合理性。

2. 双路径身份注入机制

为了确保源身份高保真地迁移到目标面部,DynamicFace 设计了两个互补的身份注入模块:

- Face Former:基于查询注意力机制,从预训练人脸识别模型中提取源人脸的全局身份特征,并将其注入扩散 U-Net 的中间层,增强语义一致性;

- ReferenceNet:引入额外的参考分支,通过空间注意力机制融合源人脸的局部纹理细节(如痣、皱纹),提升纹理真实感。

这种“全局+局部”的双重注入策略,有效避免了身份漂移问题。

3. 视频时间一致性优化:FusionTVO

针对视频场景,DynamicFace 提出 FusionTVO(Fusion Total Variation Optimizer),专门用于提升帧间稳定性:

- 段感知潜在融合:对短片段内的潜在表示进行平滑融合,减少突变;

- 时间总变分正则化:约束相邻帧之间的潜在变化幅度,抑制闪烁与抖动。

该模块无需额外训练,可在推理阶段直接集成,显著提升视频流畅度。

工作流程概览

- 条件提取:从目标图像/视频帧中提取上述四种 3D 条件;

- 身份编码:从源人脸提取身份特征,经 Face Former 与 ReferenceNet 处理;

- 扩散生成:在扩散模型的去噪过程中,通过 Mixture-of-Guiders 机制融合所有条件与身份信号;

- 视频优化:对生成序列应用 FusionTVO,进行时间一致性后处理;

- 输出合成:重建为最终的人脸交换图像或视频。

整个流程支持端到端推理,且各模块可灵活替换,具备良好扩展性。

实验表现:全面领先

研究团队在 FaceForensics++(FF++) 数据集上进行了系统评估,涵盖图像与视频任务,主要指标包括:

| 指标 | 含义 |

|---|---|

| 身份检索准确率 | 衡量生成人脸是否与源身份一致 |

| 姿势误差 | 评估头部姿态保留程度 |

| 表情误差 | 衡量表情动态的还原精度 |

| 眼动/嘴部误差 | 细粒度动作保真度 |

| CLIP 帧一致性、光流误差 | 视频时间稳定性 |

关键结果:

- 身份检索准确率:99.20% —— 接近完美识别,显著优于 SimSwap、FaceShifter 等方法;

- 表情误差:3.08,眼动误差:0.16,嘴部位置误差:1.69 —— 均为最优,说明细微表情动作得以精准保留;

- 视频一致性:在 CLIP 帧间相似度和光流误差上表现最佳,生成视频自然连贯,无明显闪烁。

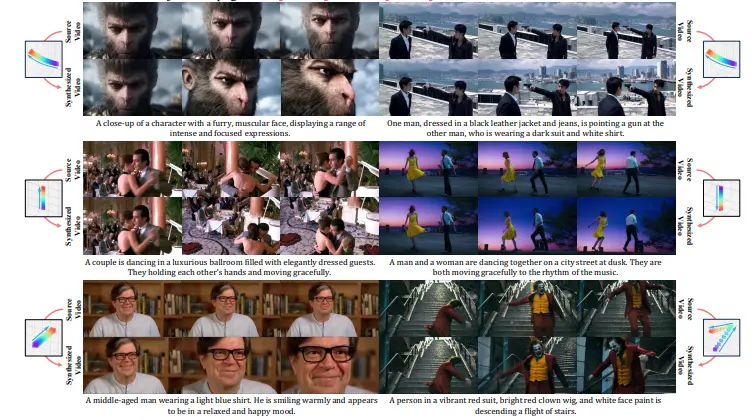

定性结果也显示,DynamicFace 在复杂光照、大角度姿态和夸张表情下仍能保持高质量输出。

轻量适配与多场景应用

DynamicFace 的设计兼顾实用性:

- 跨数据集鲁棒性:在 CelebA-HQ、FF++, 以及自建视频数据上均表现稳定;

- 图像与视频统一框架:无需单独训练模型,即可无缝切换应用场景;

- 未来可扩展性:模块化设计支持后续集成更多条件(如眼镜、胡须)或优化组件。

潜在应用场景包括:

- 视频内容创作中的人物替换;

- 虚拟主播定制化形象生成;

- 影视后期特效中的安全人脸替换;

- 社交平台的趣味互动功能。

相关文章