来自中国科学技术大学与香港科技大学的研究团队联合提出了一种名为 LongAnimation 的新型动画着色框架。该框架旨在实现长动画序列的自动化着色,并在整个动画过程中保持长期的颜色一致性。

- 项目主页:https://cn-makers.github.io/long_animation_web

- GitHub:https://github.com/CN-makers/LongAnimation

该研究引入了动态全局-局部记忆机制(Dynamic Global-Local Memory, DGLM),用于动态提取与当前生成帧相关的全局颜色一致特征;同时还引入了颜色一致性奖励(Color Consistency Reward, CCR),进一步优化整体色彩一致性。

动画上色的挑战与 LongAnimation 的突破

在传统动画制作中,动画师通常需要逐帧绘制并手动上色。对于一段10到30秒、包含300至1000帧的长动画来说,这一过程不仅耗时,而且对专业技能要求极高。

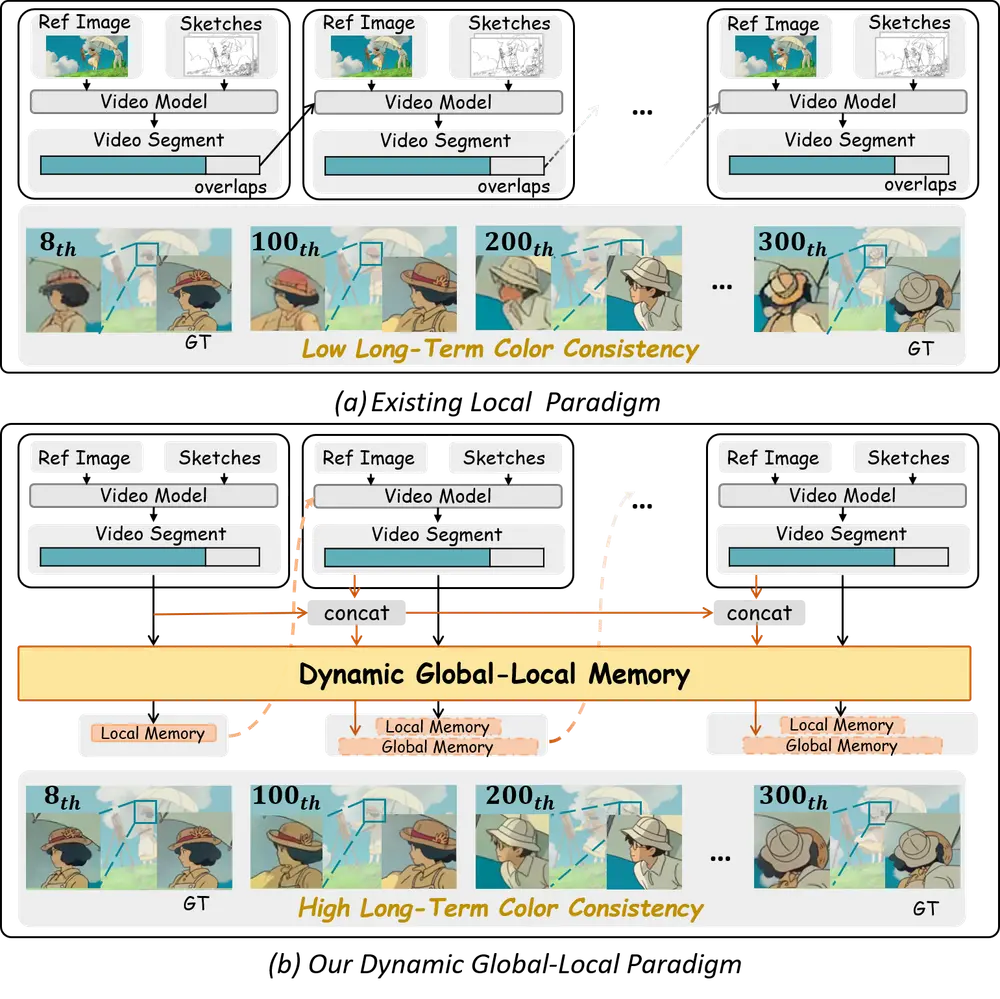

尽管已有部分研究尝试通过视频生成模型实现自动化上色,但大多局限于短期动画片段,采用的是局部范式,即通过融合相邻帧之间的重叠区域来实现局部一致性。然而,这种方法忽略了全局信息,难以维持长期的颜色统一性。

为此,研究人员提出了LongAnimation,一个全新的动画着色框架,主要包括三个核心模块:

- SketchDiT:用于混合参考图像、草图和文本特征;

- 动态全局-局部记忆机制(DGLM):动态提取与当前帧相关的历史全局颜色特征;

- 颜色一致性奖励(CCR):优化低频颜色分布,提升整体一致性。

主要功能

- 长动画着色:适用于平均 500 帧的长动画序列。

- 动态全局-局部记忆:结合历史与当前帧信息,实现长期一致性。

- 颜色一致性奖励(CCR):通过低频特征优化颜色分布。

- 文本与图像联合控制:支持多种输入形式指导动画生成。

框架设计详解

1. SketchDiT:多模态特征编码器

SketchDiT 负责将输入的参考图像、线条草图以及文本提示编码为统一的混合特征表示。这种多模态输入方式为后续的记忆机制提供了丰富的语义支持。

2. 动态全局-局部记忆机制(DGLM)

DGLM 是 LongAnimation 的核心创新之一。它通过以下步骤实现长期颜色一致性:

- 使用长视频理解模型(Video-XL)压缩历史帧的颜色特征;

- 根据当前生成帧的内容,自适应地提取最相关的全局颜色特征;

- 利用跨注意力机制,将全局记忆与局部新生成特征进行融合。

这种方式避免了传统方法中“只看邻近帧”的局限性,使模型能够从全局视角出发,做出更具一致性的颜色决策。

3. 颜色一致性奖励(CCR)

在训练阶段,研究人员引入了 CCR 模块,其目标是通过对生成动画与参考动画之间的低频颜色特征对比,进一步优化颜色一致性。

该模块采用非梯度优化策略,在不增加计算复杂度的前提下,有效提升了最终输出的视觉质量。

4. 颜色一致性融合(CCF)

在推理阶段,LongAnimation 还引入了颜色一致性融合(CCF)技术,用于平滑不同视频片段之间的过渡。该操作在去噪过程的后期执行,能显著减少拼接帧之间的突变现象,从而增强整体观感。

实验结果验证效果

研究人员在多个动画数据集上进行了广泛实验,涵盖了短动画(14帧)和长动画(平均500帧)。评估指标包括 LPIPS、SSIM、PSNR、FVD 和 FID 等,结果显示:

| 类型 | 指标 | 改进幅度 |

|---|---|---|

| 短动画 | LPIPS | 57.1% ↓ |

| 短动画 | SSIM | +6.9% ↑ |

| 短动画 | PSNR | +2.1% ↑ |

| 短动画 | FVD | 35.1% ↓ |

| 短动画 | FID | 28.6% ↓ |

| 长动画 | LPIPS | 58.0% ↓ |

| 长动画 | SSIM | +11.8% ↑ |

| 长动画 | PSNR | +15.3% ↑ |

| 长动画 | FVD | 49.1% ↓ |

| 长动画 | FID | 46.9% ↓ |

这些结果表明,LongAnimation 在保持高质量的同时,显著优于现有方法,尤其是在长动画场景下的颜色一致性方面表现突出。

定性比较与应用展示

与现有方法相比,LongAnimation 在多个测试视频中表现出更强的长期一致性。例如,在女孩裙子和树叶的颜色变化中,其他方法出现了明显的漂移或错位,而 LongAnimation 始终保持了稳定且自然的色彩呈现。

此外,LongAnimation 还支持文本引导的背景生成功能。给定前景参考图像和线条草图后,系统可以根据文本描述生成动态背景,这是此前方法无法实现的能力。

相关文章