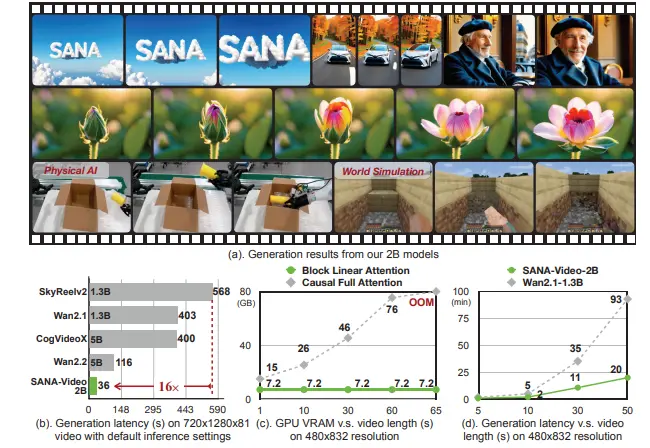

6月18日,Midjourney 宣布正式推出其首款视频生成模型 V1,标志着这家以图像生成闻名的 AI 公司,正式进军视频内容创作领域。

这一更新不仅打通了原有的图文生成生态,还实现了从文本直接生成视频的能力,为创作者带来更完整的 AI 创作体验。

核心功能一览

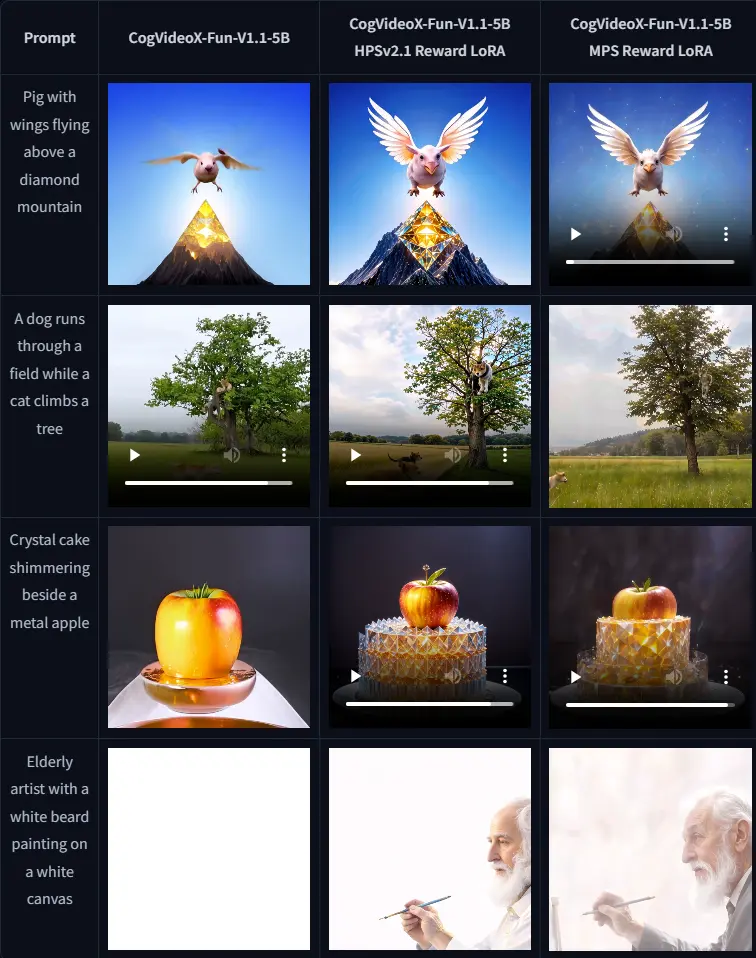

✅ 图像到视频生成(Image-to-Video)

用户仍可像往常一样在 Midjourney 中生成图像,现在只需点击“动画”按钮,即可将静态图像转化为动态视频。支持两种模式:

- 自动动画:系统自动生成“动作提示”,让画面自然动起来;

- 手动动画:用户自定义描述画面如何移动和演变。

此外,用户还可上传外部图像并标记为“起始帧”,再通过动作提示生成动画效果。

✅ 动态控制选项

提供两种动态风格选择:

- 高动态(High Motion):适合主体与镜头同时运动的场景;

- 低动态(Low Motion):适用于环境缓慢变化或主体微动的场景。

✅ 视频长度扩展

每次生成默认为 4 秒视频,用户最多可延长四次,实现最长约 20 秒的连续动画输出。

💰 定价策略:10美元/分钟,无试用点数

Midjourney 对视频任务的定价约为图像任务的 8 倍。每个任务将生成四个 5 秒视频,相当于每分钟视频收费 10 美元。

官方表示,该价格比此前市场推出的同类产品便宜超过 25 倍,极具性价比优势。

目前仅对网站端开放使用,且不提供免费试用额度。专业版及以上订阅用户还将优先获得“视频放松模式”的测试资格。

🧠 技术愿景:迈向实时开放世界模拟

Midjourney 在公告中首次明确表达了其技术演进方向:

“我们的终极目标是构建一个能够实时生成图像、视频、3D 场景,并允许用户自由交互的 AI 系统。”

这包括以下关键技术模块:

- 图像生成(已实现)

- 视频生成(V1 已上线)

- 3D 场景建模(未来规划)

- 实时响应能力(最终目标)

他们计划在未来一年内逐步发布这些模块,并最终整合成一个统一的 AI 创作系统。

⚠️ 使用提醒:负责任地生成内容

Midjourney 强调,AI 视频技术的正确使用可以带来趣味性、实用性甚至深远的文化影响。但同时也呼吁用户负责任地使用这项技术,避免滥用或传播误导性内容。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...