Menlo发布一款专为深度研究任务设计的小型语言模型 Jan-Nano 。该模型拥有 40亿参数规模,在保证轻量级部署的同时展现出强大的推理能力。此模型基于 Qwen3-4B 构建,并经过 DAPO 微调。

Jan-Nano 的一大亮点是其与 模型上下文协议(MCP)服务器 的原生兼容性,使其能够无缝整合多种研究工具和数据源,适用于需要高效信息检索与处理的研究场景。

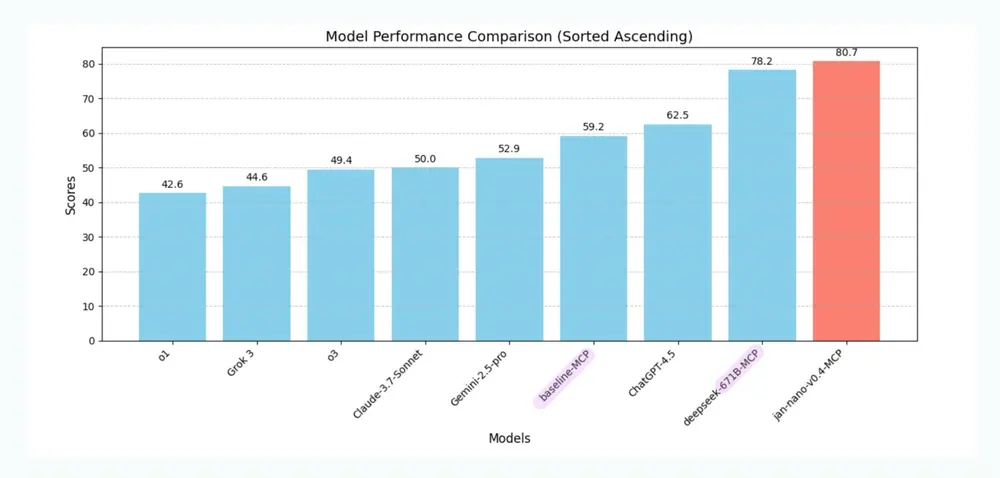

在 SimpleQA 基准测试中表现优异

Jan-Nano 在 SimpleQA 基准测试 中采用了基于 MCP 的评估方法,全面验证了其在事实准确性和任务整合能力方面的表现。

这种测试方式不仅衡量模型本身的语言理解能力,还考察其在真实研究环境中通过 MCP 协议获取外部知识并整合输出的能力。结果显示,Jan-Nano 在其参数规模下展现了非常出色的综合性能。

💻 如何本地运行 Jan-Nano?

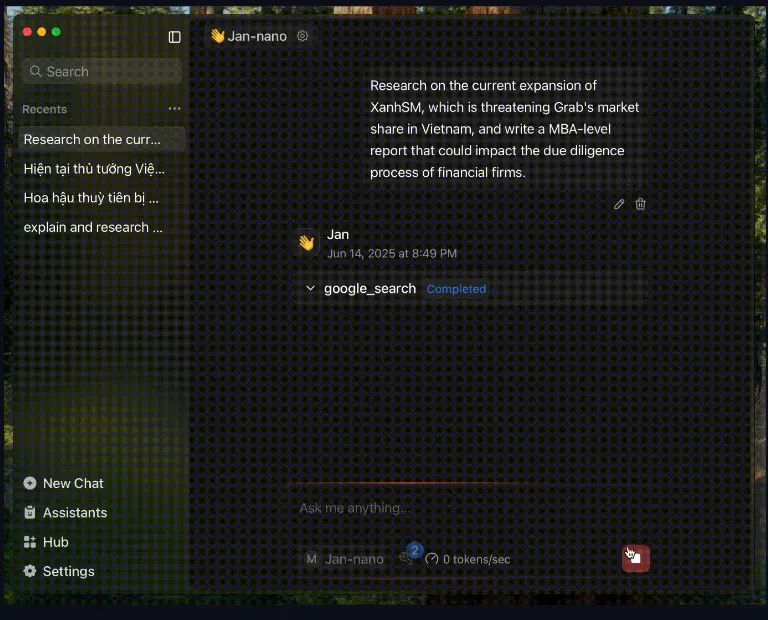

Jan-Nano 目前已集成于 Jan Beta 版本中,这是一个完全支持本地运行的开源 AI 助手,可作为 ChatGPT 的替代方案使用。

Jan 提供了一个简洁易用的界面,让用户可以在自己的电脑上运行 AI 模型,确保数据隐私和完全控制权。

如果你希望尝试本地部署,可以通过以下步骤快速上手:

- 下载并安装 Jan - beta;

- 在模型库中搜索并下载 Jan-Nano;

- 配置采样参数后即可开始本地运行。

⚙️ 推荐采样参数设置

为了获得最佳效果,官方推荐以下采样参数配置:

| 参数 | 推荐值 |

|---|---|

| 温度(Temperature) | 0.7 |

| Top-p | 0.8 |

| Top-k | 20 |

| Min-p | 0 |

这些参数组合在平衡生成多样性与稳定性方面表现出色,适用于大多数研究与问答任务。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...