随着大语言模型不断向轻量化和高性能方向演进,Arcee Homunculus-12B 成为一个值得关注的新成员。它是一款基于 Qwen3-235B 蒸馏而来、部署在 Mistral-Nemo 架构上的 120 亿参数指令模型,专为保留 Qwen 的双模式交互体验而设计,同时支持在单张消费级显卡上运行。

这意味着你可以在本地设备上获得接近大型模型的推理能力,而无需高昂的算力成本。

🔍 核心亮点解析

Homunculus 并非简单的模型压缩产物,而是一次深度优化与对齐的成果。以下是其技术层面的关键创新:

| 功能 | 技术细节 |

|---|---|

| 推理轨迹转移 | 不仅复制最终输出概率,还对教师模型(Qwen3)的完整 logit 轨迹进行对齐,从而生成更忠实、可解释的推理过程。 |

| 总变差距离损失 | 引入该损失函数以更好地匹配教师模型的置信度分布,使训练过程更稳定,损失曲面更平滑。 |

| 词元器替换 | 使用 Qwen3 的词元器替代原生 Mistral 词元器,确保语义表达的一致性与完整性。 |

| 双交互模式 | 支持两种使用方式: 🔹 /think 模式:逐步展示推理链,适合调试、教学或复杂分析任务;🔹 /nothink 模式:直接给出简洁答案,适用于生产环境快速响应。 |

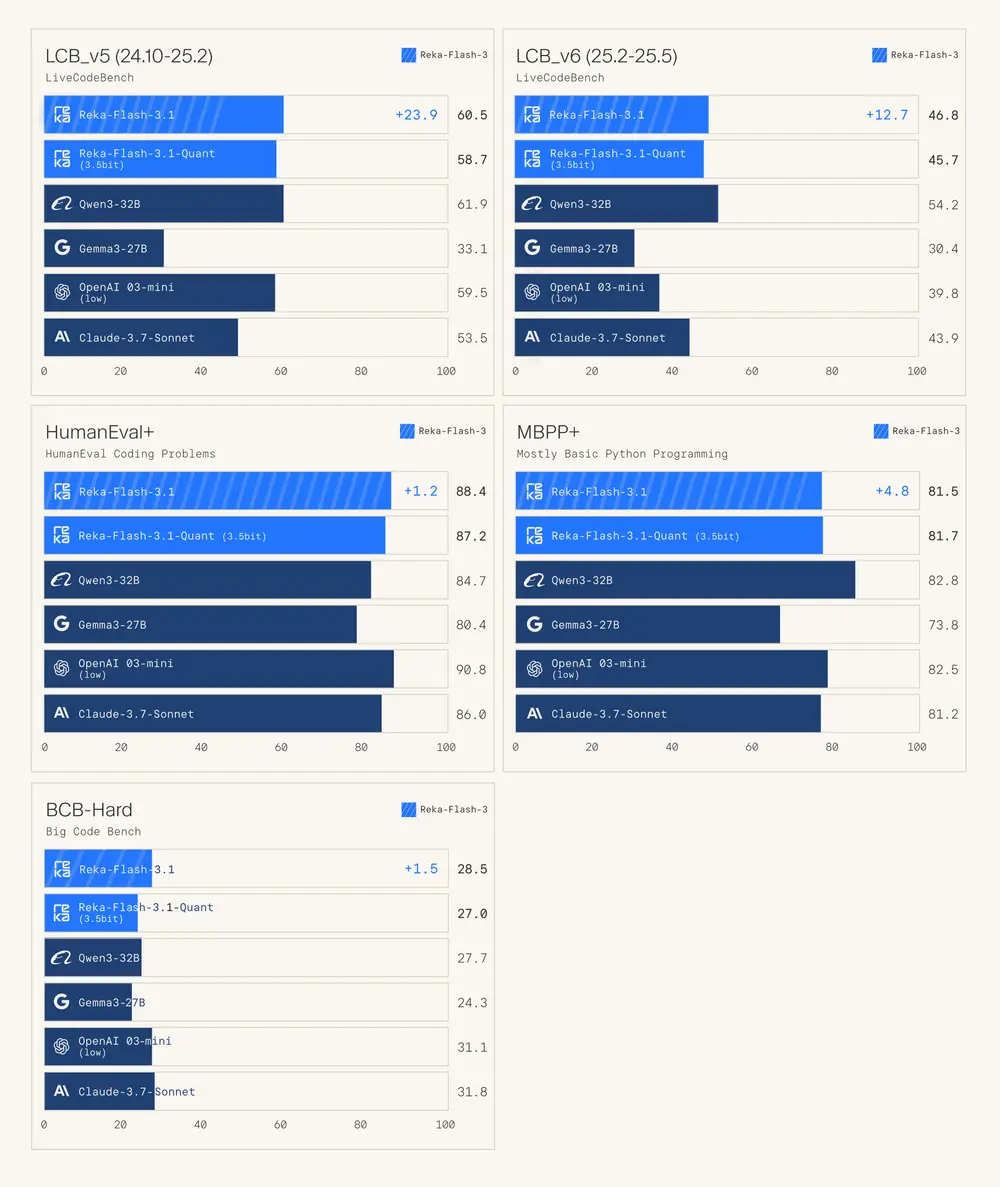

📊 基准测试表现

尽管体积精简,Homunculus 在多个关键基准中依然展现出不俗性能:

| 基准名称 | 得分 |

|---|---|

| GPQADiamond(3次平均) | 57.1% |

| MMLU(多任务语言理解) | 67.5% |

这些成绩表明,Homunculus 在保持较小参数规模的同时,仍具备较强的推理与知识掌握能力。

🛠️ 使用场景与限制

✅ 主要适用场景:

- 研究用途:用于探索推理轨迹蒸馏、Logit 级模仿学习等前沿课题。

- 轻量部署:适用于显存小于 12GB 的设备,在边缘计算或本地服务中提供强大推理能力。

⚠️ 已知限制:

- 继承了 Qwen3 教师模型及互联网预训练数据中的潜在偏见。

- 对长上下文(超过 32k token)的支持尚处于实验阶段,可能存在延迟或内存占用较高问题。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...