法国AI实验室 Mistral AI正式发布了其首个推理模型家族——Magistral,标志着这家以开源著称的AI公司正式进军高阶推理领域。

该系列包括两个版本:

- Magistral Small(240亿参数):Apache 2.0许可证开源,可在 Hugging Face 下载;

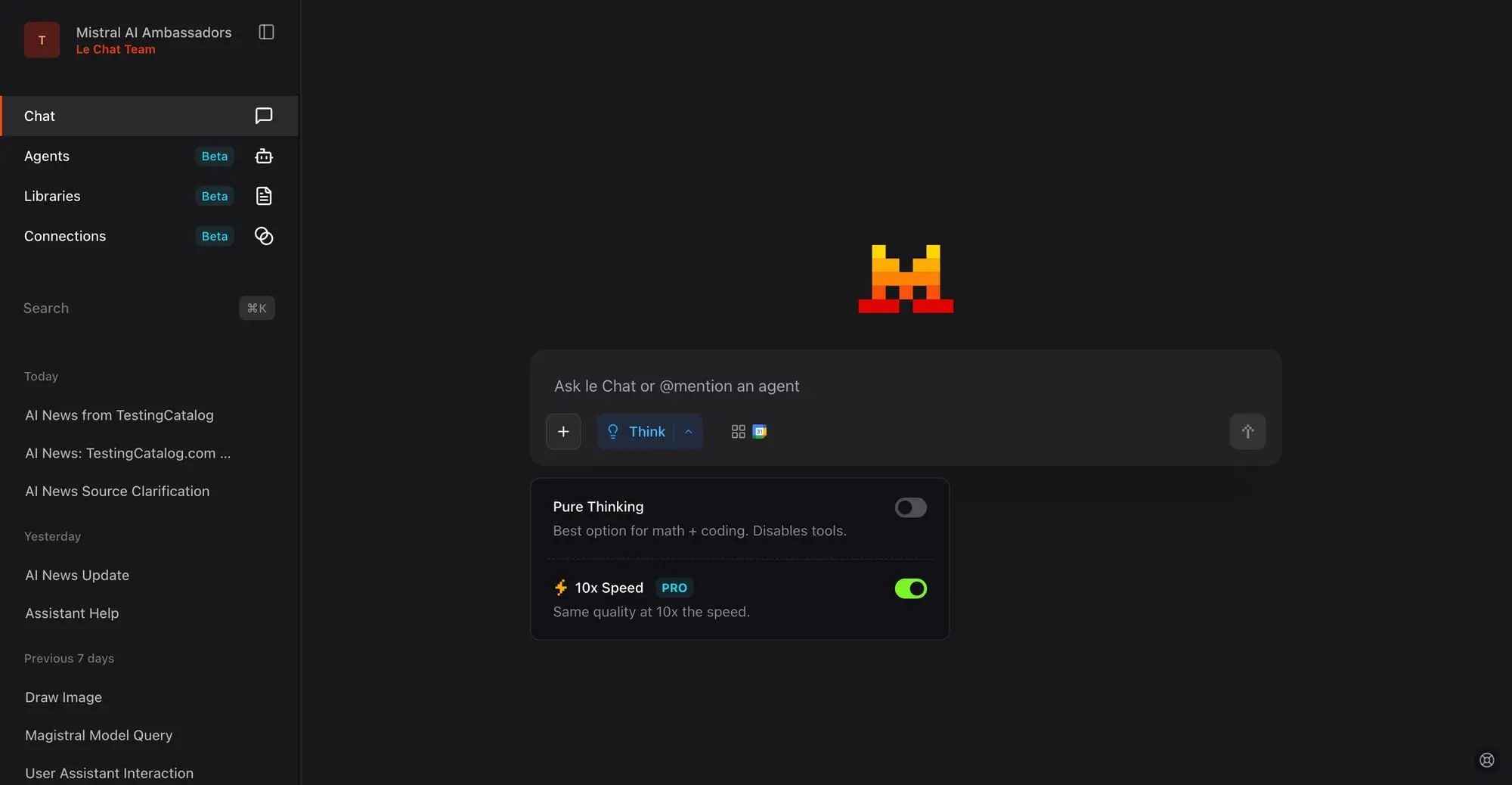

- Magistral Medium:更强大版本,通过 Mistral 的 Le Chat 聊天平台和企业API提供预览。

这一发布正值全球AI巨头竞相推出更强推理能力模型之际。OpenAI 的 o3、谷歌的 Gemini 2.5 Pro 和 Anthropic 的 Claude Opus 4 等均已布局推理模型市场,而 Magistral 则试图以透明推理、多语言支持和高速响应切入竞争。

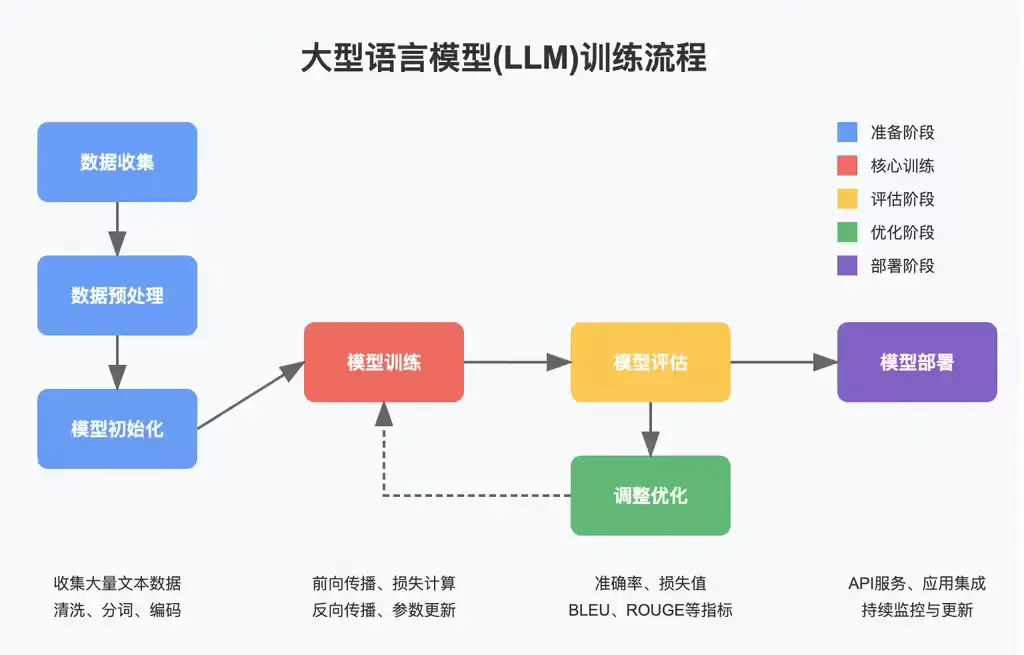

技术亮点:专注“可解释性”与“逻辑链”

Mistral 在博客中强调,Magistral 是专为结构化计算、程序逻辑、决策树和基于规则系统设计的推理模型。与通用大模型不同,它在训练过程中特别强化了对多步逻辑的处理能力,并能以用户语言呈现完整的思维过程。

这意味着:

- 用户可以看到模型是如何一步步得出结论的;

- 模型具备更高的可追溯性和可解释性;

- 更适合法律、金融、医疗等需要合规与审计的场景。

✅ 支持多种语言的高保真推理

Magistral 支持英语、法语、西班牙语、德语、意大利语、阿拉伯语、俄语、简体中文等多种语言,并在这些语言中保持一致的推理质量,这在全球AI模型中仍属少数。

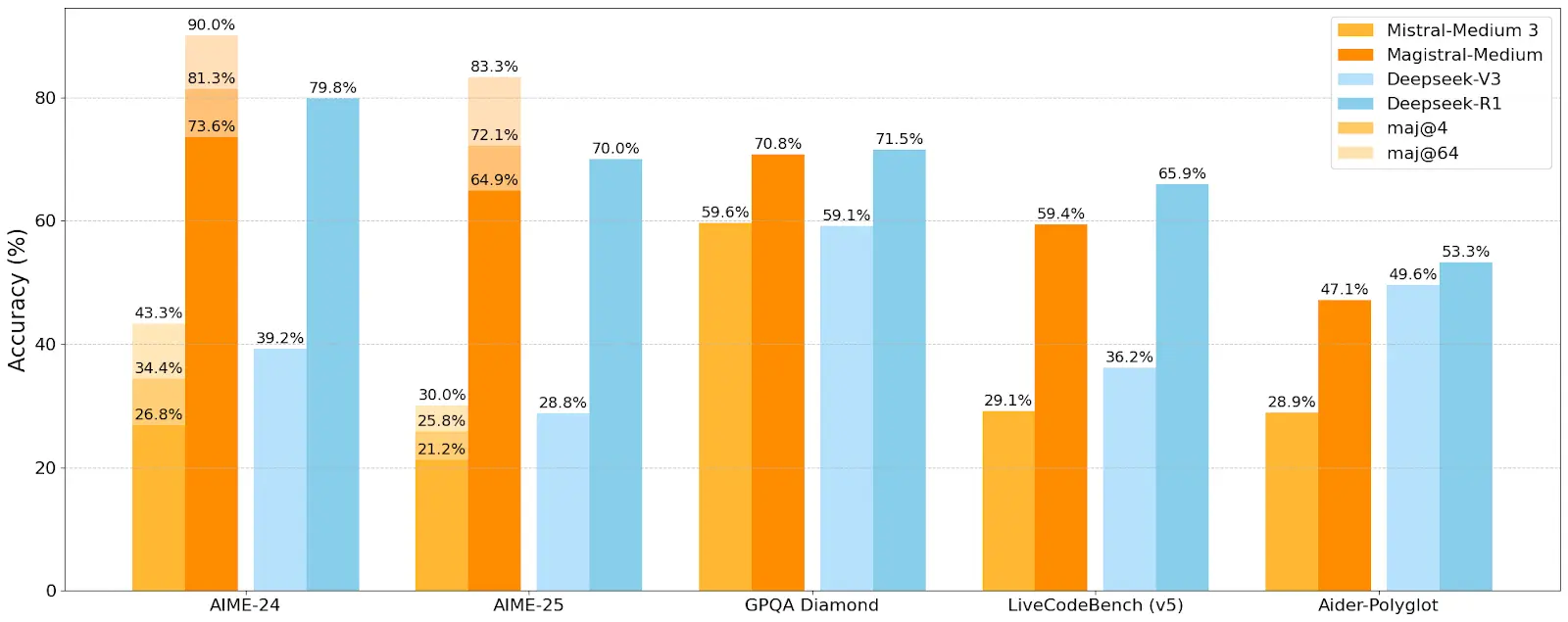

性能表现:尚未超越顶尖模型,但速度更快

尽管 Mistral 对 Magistral 寄予厚望,但从其公布的基准测试结果来看,目前仍未超越当前领先的推理模型。

| 模型名称 | AIME2024 Pass@1 | GPQA Diamond |

|---|---|---|

| Gemini 2.5 Pro | 76%+ | 75%+ |

| Claude Opus 4 | 72% | 71% |

| Magistral Medium | 73.6% | 70.83% |

| Magistral Small | 70.7% | 68.18% |

从数据来看,Magistral Medium 表现尚可,但在数学与科学推理方面仍略逊于 Gemini 和 Claude。不过,Mistral 强调其模型在 Le Chat 平台上的响应速度比多数竞品快10倍,这对需要实时反馈的应用场景(如客服、实时分析)是一个重要优势。

应用场景广泛:从企业战略到创意写作都能胜任

Mistral 在博客中列举了多个潜在应用场景,涵盖:

- 商业战略与运营优化:执行多因素风险评估、建模与资源调度;

- 受监管行业:法律、金融、医疗等领域,需满足合规要求并提供可追溯推理;

- 软件开发与工程:增强项目规划、架构设计、数据工程等任务;

- 内容创作与叙事:生成连贯、有创意或风格独特的文案。

尤其值得一提的是,Magistral 可与 Mistral 最新推出的 Le Chat Enterprise 结合使用,后者支持连接 Gmail、SharePoint、Slack 等外部服务,实现自动化办公与协作流程。

开源与部署选项:灵活适配各类需求

对于开发者和研究者来说,Magistral Small 是一大福音:

- 开源协议:采用 Apache 2.0 许可证,允许自由修改与商用;

- 本地部署友好:量化后可在 RTX 4090 或 32GB RAM 的 MacBook 上运行;

- 支持主流框架:包括 vLLM、llama.cpp、ollama、lmstudio 等。

而 Magistral Medium 目前仅对企业用户提供预览访问,可通过以下方式获取:

- Le Chat 平台

- Mistral API

- Amazon SageMaker(已上线)

- 即将登陆 IBM WatsonX、Azure AI 和 Google Cloud Marketplace

Magistral 的发布标志着 Mistral 正式进入推理模型赛道。虽然在性能上尚未超越当前头部选手,但其开源策略、多语言支持、高速响应和透明推理机制,使其在特定场景下具备独特竞争力。

相关文章