阿里巴巴达摩院、复旦大学和湖畔实验室的研究人员推出Uni3C框架,通过统一的3D增强方法精确控制视频生成中的相机和人物动作。

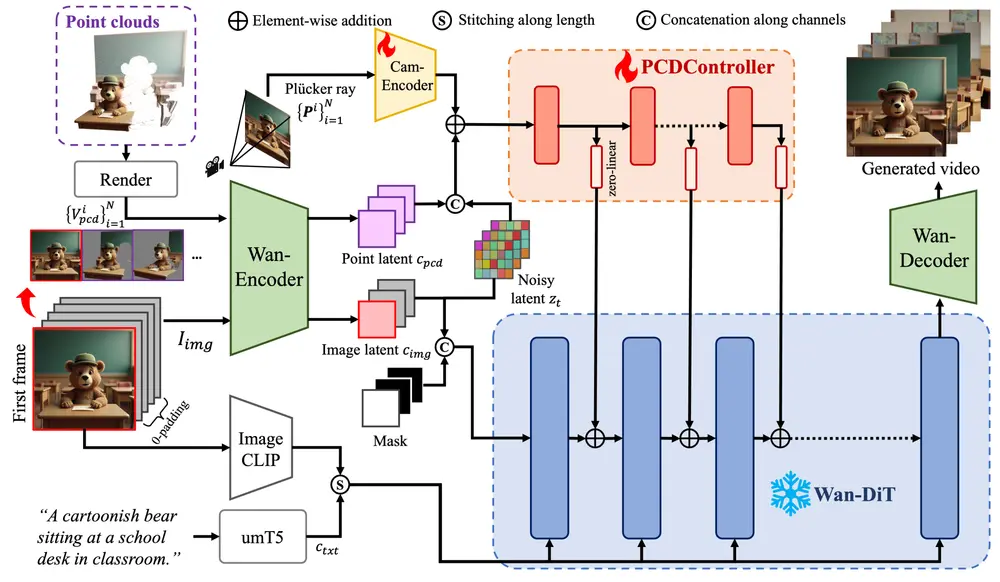

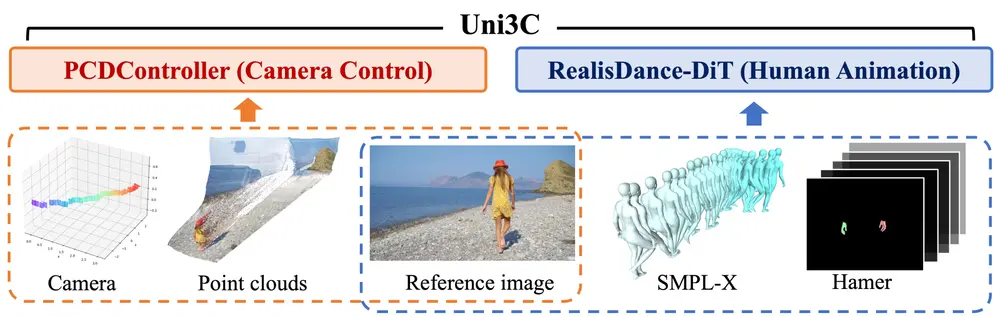

Uni3C通过两个关键贡献实现这一目标:一是提出了一个轻量级的控制模块PCDController,用于精确控制相机轨迹;二是提出了一个全局3D世界引导方法,用于在推理阶段统一相机和人物动作的控制信号。

主要功能

- 相机控制:Uni3C能够根据给定的相机轨迹生成高质量的视频内容。例如,给定一个单视图图像和一系列目标相机轨迹,Uni3C可以生成相应的视频,展示相机在不同位置和角度下的场景。

- 人物动作控制:Uni3C支持对人物动作的精确控制,可以生成人物在不同动作下的视频。例如,给定一个初始的人物姿态和一个动作序列,Uni3C可以生成人物按照该动作序列移动的视频。

- 联合控制:Uni3C能够同时控制相机轨迹和人物动作,生成两者协调一致的视频。例如,可以生成一个视频,其中人物在行走的同时,相机在围绕人物旋转。

主要特点

- 轻量级控制模块:PCDController是一个轻量级的模块,参数量仅为0.95B,与基础视频生成模型Wan2.1的14B参数相比,显著减少了参数量。这使得PCDController在训练和推理时更加高效。

- 3D几何先验:PCDController利用从单目深度估计中提取的点云来实现精确的相机控制。点云提供了丰富的3D几何信息,使得相机控制更加准确。

- 全局3D世界引导:Uni3C通过将场景点云和人物模型(SMPL-X)对齐到同一个3D世界坐标系中,实现了相机和人物动作的统一控制。这种方法确保了生成视频中相机和人物动作的一致性。

- 强大的泛化能力:PCDController在不同领域(如真实世界、文本到图像、动画等)的视频生成任务中表现出色,即使在训练数据有限的情况下也能保持良好的泛化能力。

工作原理

Uni3C的工作原理基于以下几个关键点:

- PCDController:PCDController是一个轻量级的模块,通过从单目深度估计中提取的点云来控制相机轨迹。点云提供了丰富的3D几何信息,使得相机控制更加准确。PCDController在训练时使用冻结的视频生成模型作为背景,通过点云和相机轨迹的联合训练,实现了对相机运动的精确控制。

- 全局3D世界引导:在推理阶段,Uni3C将场景点云和人物模型(SMPL-X)对齐到同一个3D世界坐标系中。通过这种方式,Uni3C能够统一控制相机轨迹和人物动作,生成协调一致的视频内容。

- 多模态条件融合:Uni3C支持多种模态的条件输入,包括相机轨迹、点云、人物模型(SMPL-X)等。这些条件输入在全局3D世界坐标系中被统一处理,从而实现对视频生成的精细控制。

测试结果

- 相机控制:Uni3C在相机控制任务上表现出色,特别是在处理具有挑战性的360度相机旋转和复杂场景时。例如,在一个包含128个测试样本的基准测试中,Uni3C在相机精度(ATE、RPE、RRE)和视频质量(VBench++)上均优于现有的方法。

- 人物动作控制:Uni3C在人物动作控制任务上也表现出色,能够生成高质量的人物动作视频。例如,在一个包含150个测试样本的基准测试中,Uni3C在人物动作的视觉质量和相机精度上均优于现有的方法。

- 联合控制:Uni3C在联合控制任务上表现出色,能够同时控制相机轨迹和人物动作,生成协调一致的视频内容。例如,在一个包含50个测试视频的基准测试中,Uni3C在联合控制任务上显著优于现有的方法。

Uni3C通过轻量级的控制模块和全局3D世界引导方法,实现了对视频生成中相机和人物动作的精确控制。它在相机控制、人物动作控制和联合控制任务上均表现出色,具有强大的泛化能力和多模态条件融合能力。Uni3C为可控视频生成领域提供了新的解决方案,具有广泛的应用前景。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...