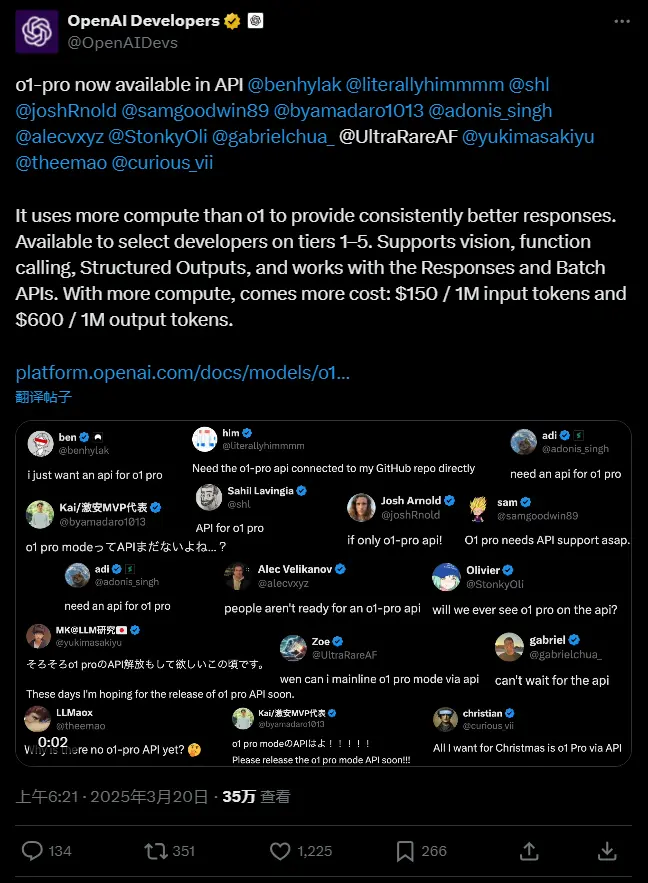

OpenAI又有了新动作,推出了更强大的o1“推理”模型版本o1-pro。然而,这个新模型的高昂价格引发了广泛的关注和讨论。

o1-pro:强大的性能与昂贵的价格

o1-pro是OpenAI在其开发者API中推出的一款全新模型。据官方介绍,o1-pro比之前的o1模型使用了更多的计算能力,旨在提供“始终更好的响应”。这意味着它能够更深入地思考问题,并为复杂的难题提供更精准的答案。

然而,强大的性能背后是高昂的成本。目前,o1-pro仅对特定开发者开放,即那些在OpenAI API服务上至少花费了5美元的用户。而且,其收费标准令人咋舌:每百万token(约75万字)输入收费150美元,生成收费600美元。这一价格是OpenAI GPT-4.5输入价格的两倍,更是普通o1价格的10倍。

OpenAI显然对o1-pro的性能提升充满信心,认为这足以说服开发者支付这些高昂费用。OpenAI发言人曾对TechCrunch表示:“o1-pro在API中是o1的一个版本,它使用更多计算能力来更深入思考,并为最困难的问题提供更好的答案。在收到我们开发者社区的许多请求后,我们很高兴将其引入API,以提供更可靠的响应。”

早期反馈:表现不尽如人意

然而,o1-pro的早期反馈并不如OpenAI所期望的那样积极。自去年12月以来,o1-pro已经在OpenAI的AI驱动聊天机器人平台ChatGPT中对ChatGPT Pro订阅者开放。但用户在使用过程中发现了一些问题。

例如,在解数独谜题时,o1-pro表现挣扎,甚至不如一些普通的解题程序。此外,它还容易被简单的视错觉笑话难住,这让人不禁对它的推理能力产生怀疑。

基准测试:有进步但仍有提升空间

不过,从OpenAI去年末的一些内部基准测试来看,o1-pro并非一无是处。测试结果显示,o1-pro在编码和数学问题上的表现仅略优于标准o1,但其在回答这些问题时确实更可靠。这表明o1-pro在某些方面确实有所提升,但这种提升是否值得开发者支付如此高昂的费用,仍是一个值得探讨的问题。

相关文章