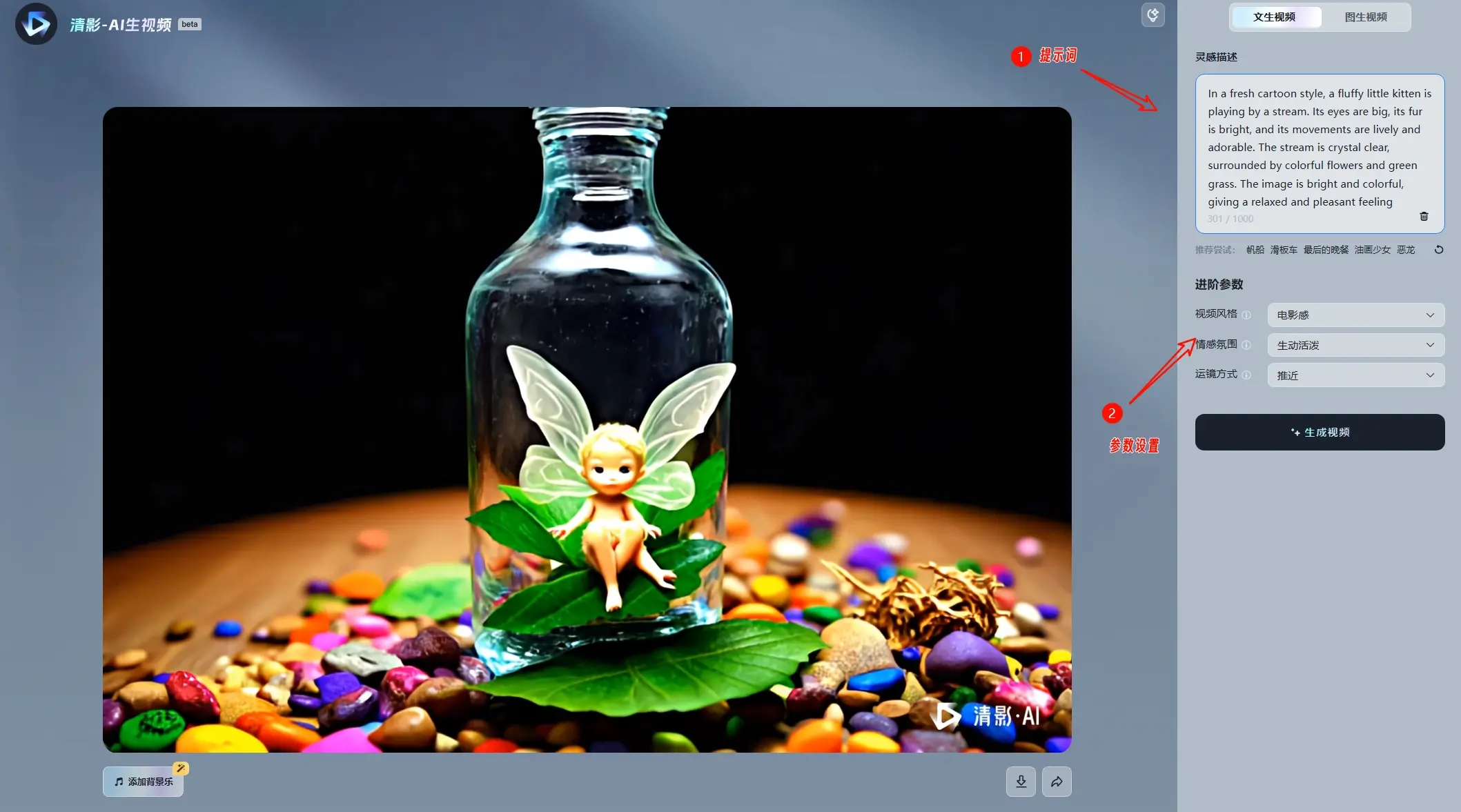

昆仑万维宣布,Opera 团队在 Opera Developer 中接入了 DeepSeek R1 系列模型,并支持本地个性化部署。这标志着 Opera 在 2024 年将内置本地大语言模型(LLM)引入 Web 浏览器,为用户提供超过 50 种 LLM 的访问权限。通过利用 Ollama 框架(由 llama.cpp 实现),Opera Developer 支持了 DeepSeek R1 系列模型的本地部署,用户可以在本地运行这些模型,享受更安全、个性化的 AI 体验。

如何在 Opera Developer 中使用 DeepSeek R1 模型

以下是详细的使用指南:

1. 下载并更新 Opera Developer

- 下载:访问 Opera Developer 官方网站,下载最新版本的 Opera Developer。

- 更新:如果已经安装了 Opera Developer,请确保更新到最新版本。

- 安装完成后,打开浏览器并点击左侧边栏中的 Aria 标识。

- 进入 Aria 界面 后,点击左上角的徽标以展开聊天历史记录。

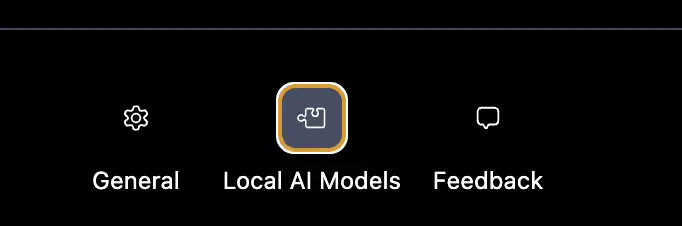

2. 进入设置菜单并选择“本地 AI 模型”选项

- 在 Aria 界面中,点击 “设置” 菜单。

- 在设置菜单中,选择 “本地 AI 模型” 选项。

3. 下载 DeepSeek R1 模型

- 在“本地 AI 模型”设置中,找到搜索框。

- 输入 “deepseek”,并从搜索结果中选择一个 DeepSeek R1 模型进行下载。

DeepSeek R1 模型的优势

DeepSeek R1 系列模型以其强大的推理能力和丰富的功能而闻名,特别适合需要高精度和高性能的应用场景。通过在 Opera Developer 中本地运行这些模型,用户可以享受以下优势:

- 个性化体验:用户可以根据自己的需求和偏好,选择和部署不同的 LLM 模型。

- 隐私与安全:本地运行的模型确保数据不会离开用户的设备,提供更高的隐私保护。

- 高效性能:通过本地部署,用户可以更快速地访问和使用 AI 功能,减少网络延迟。

- 丰富的应用场景:支持多种语言和任务,适用于文本生成、代码辅助、内容创作等多种场景。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...