Ollama-Scan 是一个基于 Ollama 的命令行工具,旨在为用户提供一个友好且交互式的界面,用于管理和使用 Ollama 模型。它特别适合那些希望利用本人或他人部署在服务器上的AI模型,但本地计算资源不足的用户。

不过,需要注意的是,如果是白嫖他人服务器,这种“白嫖”方式并不适合长期使用,因为它依赖于外部服务器的可用性和稳定性。

Ollama-Scan 提供以下功能:

- 列出所有可用模型:快速查看服务器上可用的模型列表。

- 拉取新模型:从服务器上拉取新的模型到本地。

- 查看模型详细信息:获取指定模型的详细信息,帮助用户更好地了解模型的功能和用途。

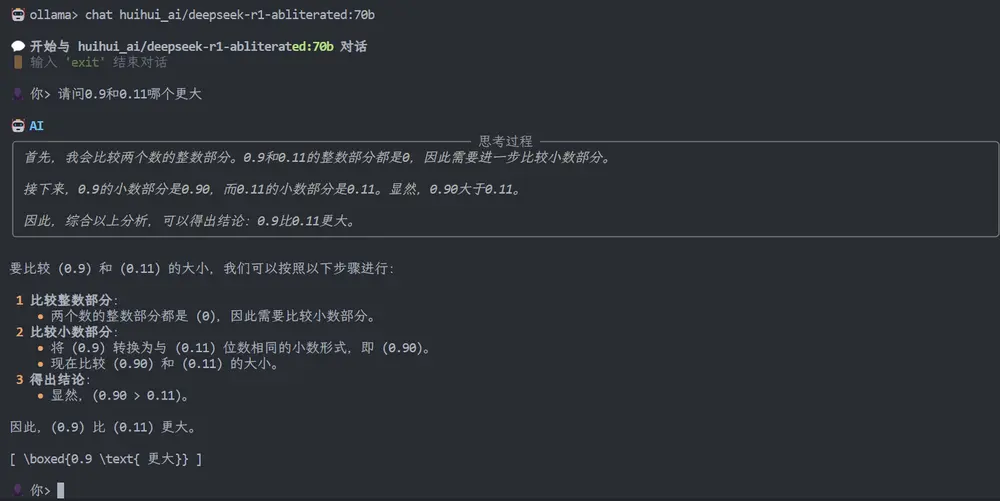

- 与模型对话:直接与指定模型进行交互,测试其性能和功能。

- 查看运行中的模型进程:实时监控模型的运行状态,确保模型正常工作。

- 美观的命令行界面:使用 Rich 库打造的美观且交互性强的命令行界面。

- 交互式命令补全:支持命令补全,提升用户体验。

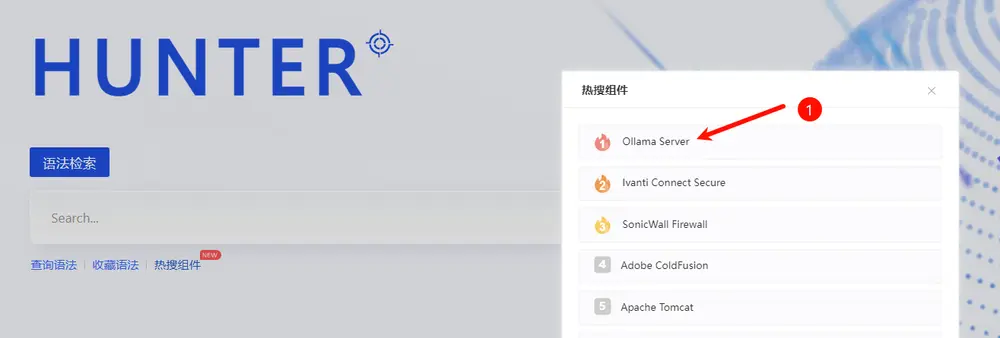

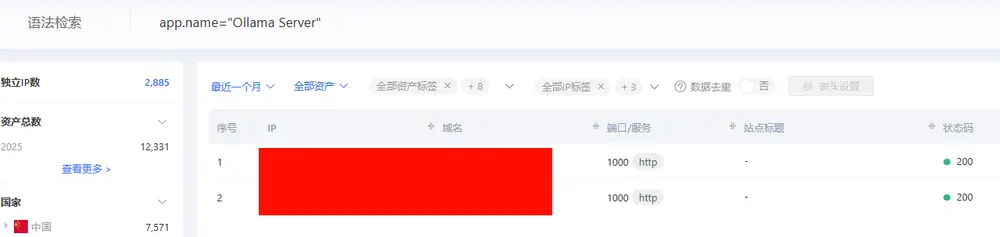

发现 Ollama 服务器

为了找到可用的 Ollama 服务器,可以使用以下方法:

- 鹰图平台:https://hunter.qianxin.com

- Fofa 平台:https://fofa.info

使用相同的语法 app.name="Ollama Server" && is_domain="False" 在以上平台上搜索。

安装方法

克隆仓库:

git clone https://github.com/b3nguang/Ollama-Scan.git

cd Ollama-Scan

安装依赖:

pip install -r requirements.txt使用方法

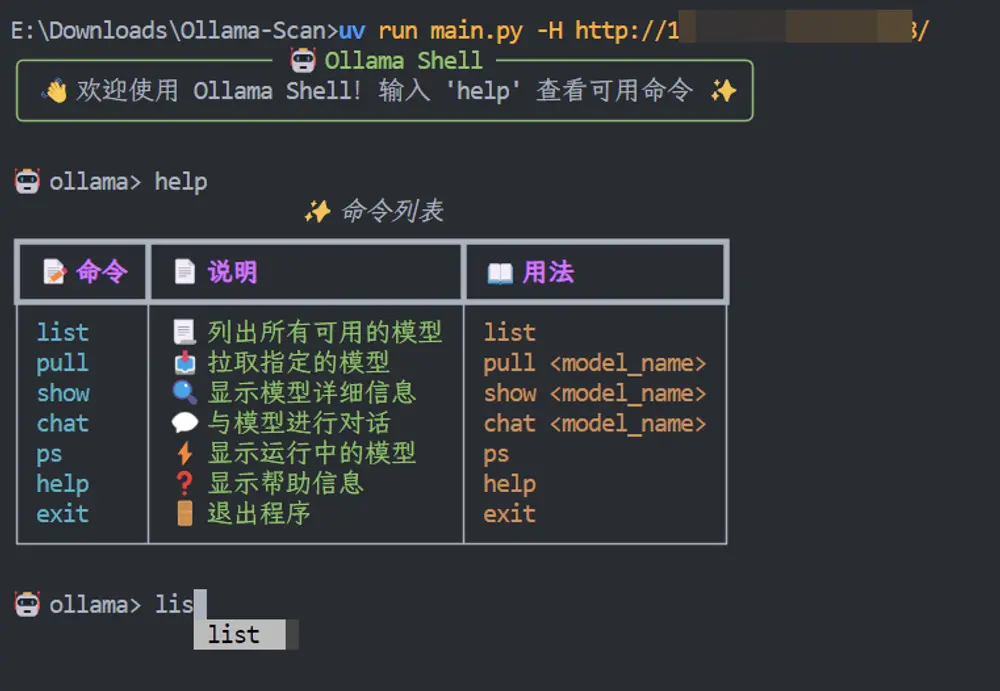

运行程序:

python main.py [--host HOST]以下是 Ollama-Scan 提供的主要命令及其功能:

| 命令 | 功能描述 |

|---|---|

list | 📃 列出所有可用模型 |

pull <model_name> | 📥 拉取指定模型 |

show <model_name> | 🔍 显示模型详细信息 |

chat <model_name> | 💬 与指定模型对话 |

ps | ⚡️ 显示运行中的模型进程 |

help | ❓ 显示帮助信息 |

exit | 🚪 退出程序 |

环境要求

- Python 3.6+:需要 Python 3.6 或更高版本。

- Ollama 服务器:需要一个可用的 Ollama 服务器。

注意事项

- 使用限制:虽然 Ollama-Scan 提供了便捷的模型访问方式,但它依赖于外部服务器,因此不适合长期使用。建议用户根据自身需求合理使用。

- 服务器稳定性:由于依赖外部服务器,用户需要确保所使用的服务器稳定且可用。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...