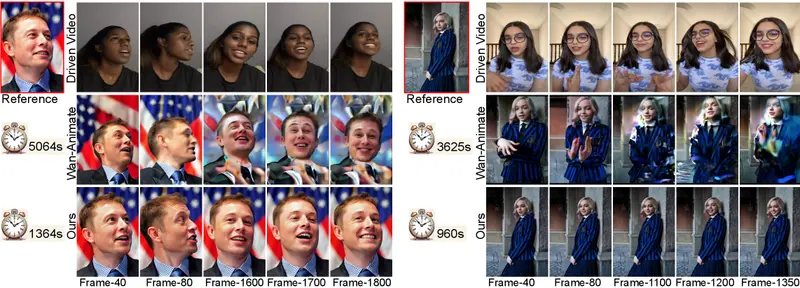

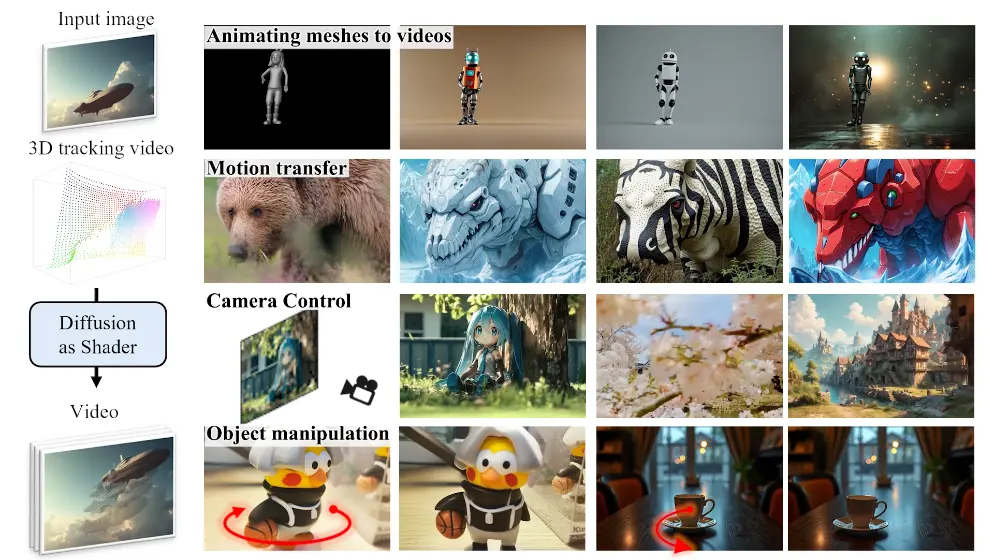

香港科技大学、浙江大学、香港大学、南洋理工大学、武汉大学和德克萨斯A&M大学的研究人员推出新型3D感知视频扩散模型Diffusion as Shader (DaS) ,旨在通过3D控制信号实现多样化且精确的视频生成控制。该模型通过利用3D跟踪视频作为输入条件,能够实现多种视频控制任务,包括动画生成、运动迁移、相机控制和对象操作等。DaS的核心创新在于其3D感知能力,能够显著提升生成视频的时间连贯性和空间一致性。

- 项目主页:https://igl-hkust.github.io/das

- GitHub:https://github.com/IGL-HKUST/DiffusionAsShader

- 模型:https://huggingface.co/EXCAI/Diffusion-As-Shader

主要功能

- 动画生成(Animating Meshes to Videos)

- 功能描述:将简单的3D动画网格转换为高质量的视频。

- 举例说明:例如,通过输入一个简单的3D人物行走动画网格,DaS可以生成一个具有丰富纹理和逼真外观的视频,人物在视频中自然地行走,背景和光影效果也与现实世界相似。

- 特点:支持从同一网格生成多种风格的视频,适应不同的视觉需求。

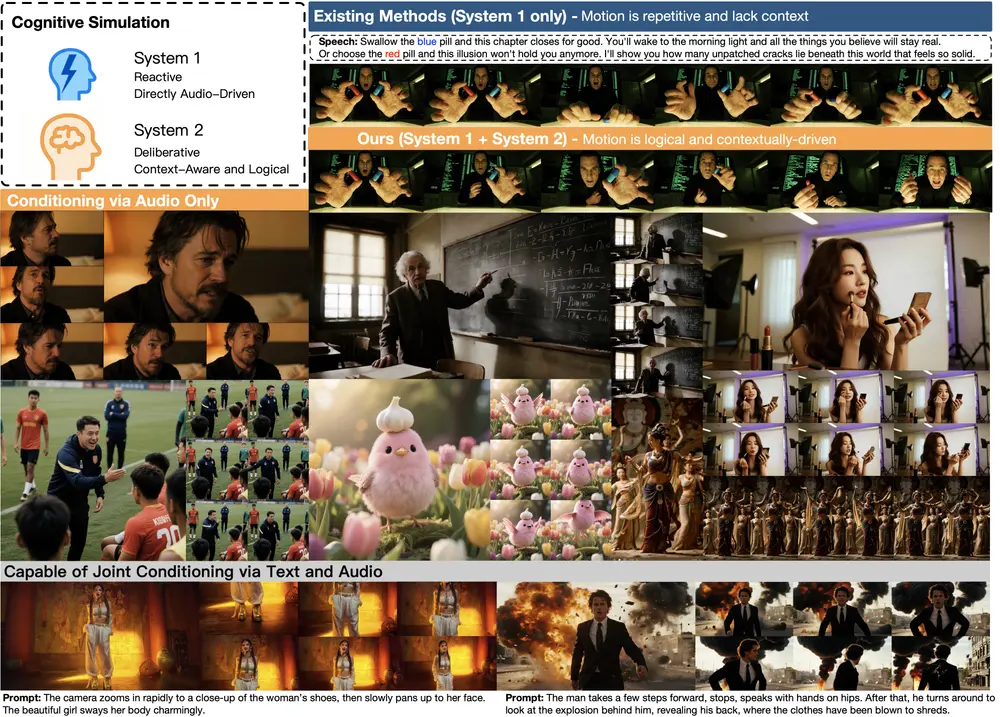

- 运动迁移(Motion Transfer)

- 功能描述:将一个视频的运动模式迁移到另一个视频中,同时保持新的风格或内容。

- 举例说明:例如,将一个跳舞视频的运动模式迁移到一个穿着不同服装的人物身上,生成一个新的跳舞视频,人物的动作与原视频一致,但外观风格完全不同。

- 特点:能够精确迁移复杂的运动模式,同时保持视频的风格一致性。

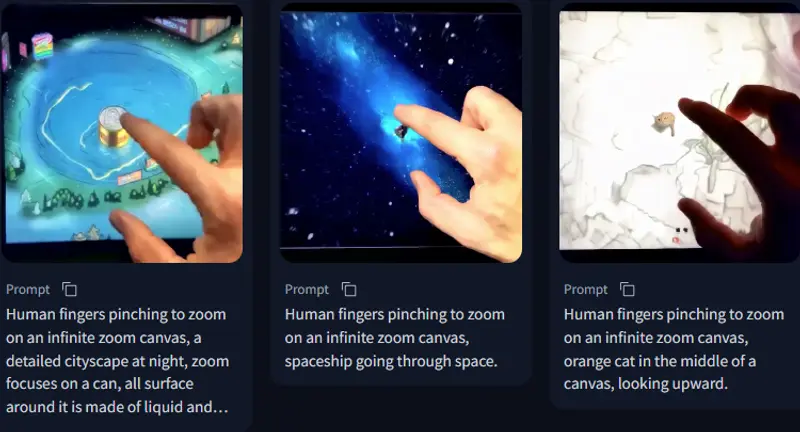

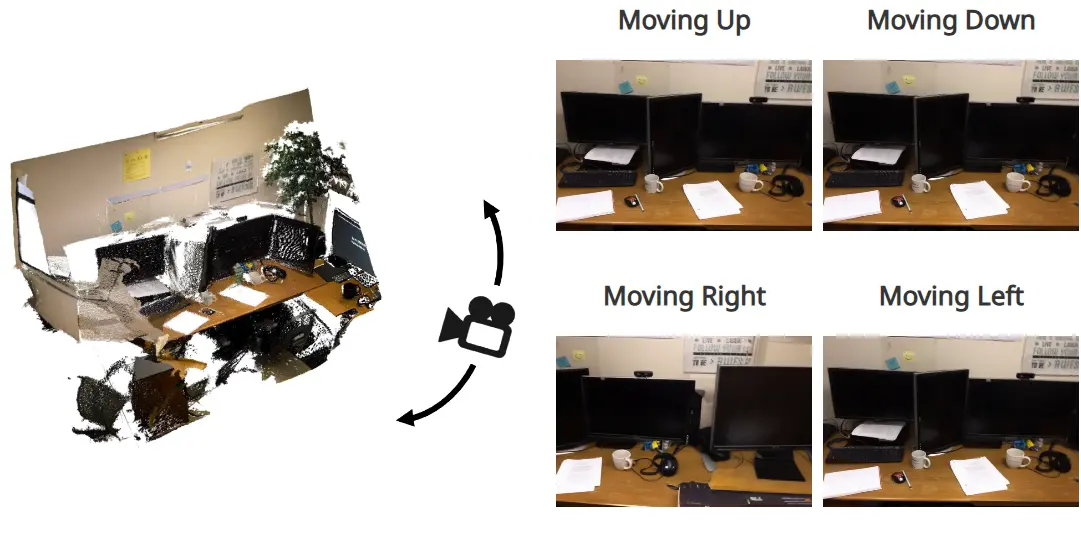

- 相机控制(Camera Control)

- 功能描述:通过指定相机路径,控制生成视频中的相机运动。

- 举例说明:例如,用户可以指定一个环绕物体的相机路径,DaS会生成一个视频,其中相机沿着指定路径环绕物体,展示物体的各个角度。

- 特点:支持复杂的相机运动路径,生成的视频具有高度的空间一致性。

- 对象操作(Object Manipulation)

- 功能描述:对视频中的特定对象进行精确操作,如平移、旋转等。

- 举例说明:例如,用户可以指定一个视频中的汽车沿着特定路径移动,或者将一个物体旋转到特定角度,DaS会生成一个视频,其中对象按照指定的方式运动。

- 特点:支持对多个对象的独立操作,生成的视频具有强多视图一致性。

主要特点

- 3D感知能力:通过3D跟踪视频作为控制信号,使视频生成过程具有3D感知能力,显著提升生成视频的时间连贯性和空间一致性。

- 多样化控制:支持多种视频控制任务,包括动画生成、运动迁移、相机控制和对象操作等,适应不同的应用场景。

- 数据高效性:仅需少量数据(如10k视频)进行微调,即可实现强大的控制能力,适合资源有限的场景。

- 高质量生成:生成的视频在视觉效果上具有高质量,能够满足广告、影视、游戏等行业的需求。

工作原理

- 3D跟踪视频的生成:

- 定义:3D跟踪视频由一组动态3D点组成,这些点的颜色由其在第一帧中的坐标决定。

- 生成方法:通过3D跟踪技术(如SpatialTracker)检测视频中的3D点及其轨迹,生成3D跟踪视频。

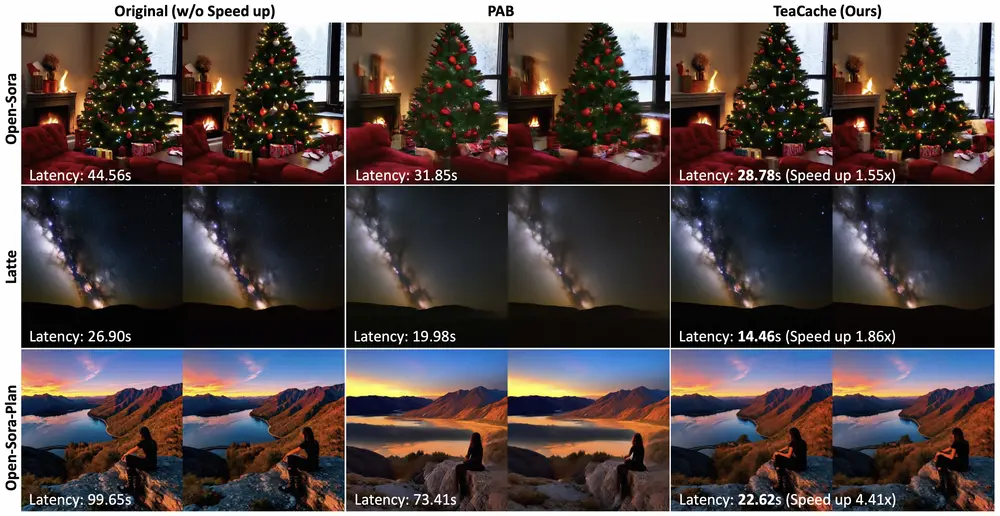

- 视频扩散模型:

- 架构:基于CogVideoX模型,采用Transformer架构,通过VAE编码器和解码器处理输入图像和3D跟踪视频。

- 条件注入:通过一个可训练的条件DiT模块,将3D跟踪视频的特征注入到扩散模型的去噪过程中。

- 视频生成:

- 输入:输入图像和3D跟踪视频。

- 输出:生成的视频根据3D跟踪视频的运动模式和输入图像的风格进行渲染,实现多样化的视频控制。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...