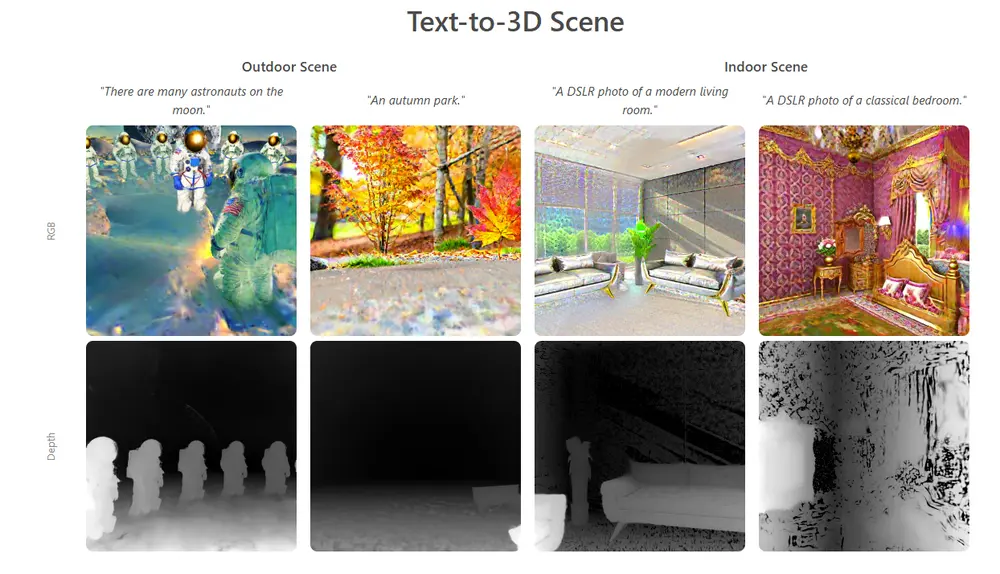

只需一张室内照片——哪怕家具相互遮挡、背景杂乱——就能重建出带纹理、可单独编辑、空间对齐正确的完整3D场景?图宾根大学的研究团队提出的 3D-RE-GEN 框架,正在将这一目标推向实用化。

与传统单图像3D重建聚焦于单个物体不同,3D-RE-GEN 的目标是整个场景:包括独立的3D资产(如沙发、灯具、装饰品)和一个结构完整的背景网格。所有元素保持正确的空间关系、光照一致性和材质保真度,可直接用于视觉特效(VFX)、游戏开发或虚拟现实等生产级工作流。

核心能力:从“一张图”到“可编辑场景”

给定一张包含家具与装饰的室内照片,3D-RE-GEN 能输出:

- 独立的3D物体网格(带纹理):每个物体可单独移动、替换或重光照;

- 完整的背景3D网格:非简单平面,而是带深度与结构的环境;

- 物理合理的布局:物体“稳稳落地”,无漂浮或穿插。

这使得艺术家或开发者能直接在重建场景中进行二次创作,而无需从零建模。

技术亮点

1. 上下文感知修复(Application-Querying, A-Q)

被遮挡的物体(如被沙发挡住的茶几一角)如何重建?

3D-RE-GEN 引入 A-Q 技术:在修复时,生成模型不仅看到局部图像,还接收整个场景的上下文信息(如房间布局、相邻物体),从而更合理地补全缺失部分。

2. 4自由度空间优化(4-DoF Alignment)

传统方法常导致物体“漂浮”或倾斜。3D-RE-GEN 通过4-DoF 优化(x, y, z 位置 + 绕垂直轴的旋转),将每个物体对齐到背景地面平面,确保物理合理性。

3. 高保真背景重建

背景不是一张贴图,而是一个带几何结构的纹理化网格,支持真实光照、阴影投射和物理模拟。

4. 模块化架构

框架整合多个预训练模型,各司其职:

- GroundedSAM:基于文本提示的实例分割;

- 几何变换模型:从“空房间”推理点云;

- 2D→3D生成器:为每个物体生成高质量网格;

- 优化器:统一空间布局。

工作流程

- 分割:用 GroundedSAM 提取所有物体掩码;

- 修复:通过 A-Q 技术补全被遮挡区域;

- 重建背景:结合原始图与推断的“空房间”生成背景网格;

- 生成物体:将修复后的物体图像送入 2D→3D 模型,输出带纹理网格;

- 优化布局:4-DoF 对齐所有物体与背景,消除穿插与漂浮。

实验结果:超越现有方法

在合成与真实数据集上的测试表明:

- 定量指标领先:在 Chamfer Distance(CD)、F-Score、BBOX-IOU 等指标上,显著优于 MIDI、DepR 等基线;

- 视觉质量更高:即使在复杂真实场景中,也能保持物体完整性与空间一致性;

- 用户偏好强:在用户研究中,81% 的参与者认为 3D-RE-GEN 的输出布局与构图最佳。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...