企业 AI 市场目前正承受着严重的"宿醉"。过去两年,决策者们被各种演示轰炸——看到自主智能体如何预订航班、编写代码和分析数据。然而,现实情况截然不同。尽管实验热情空前高涨,但在生产环境中部署可靠、自主的智能体仍然充满挑战。

麻省理工学院 NANDA 项目最近的一项研究突显了一个令人清醒的统计数据:大约 95% 的 AI 项目未能带来实际效益。当项目从沙盒环境转移到真实世界时,它们往往会因为边缘案例、幻觉或集成故障而崩溃。

谷歌高级工程师、CTO 工程办公室主任 Antonio Gulli 认为,业界对智能体的本质存在根本性误解。我们将其视为魔术盒,而非复杂的软件系统。"AI 工程,尤其是涉及大模型和智能体的领域,其实与软件工程或土木工程等任何形式的工程并无不同,"Gulli 在接受 VentureBeat 独家采访时表示,"要构建持久的东西,不能仅仅追逐最新的模型或框架。"

Gulli 认为,走出"幻灭低谷"的解决方案并非更聪明的模型,而是更好的架构。他最近出版的《智能体设计模式》一书,提供了可重复、严谨的架构标准,能够将"玩具"智能体转变为可靠的企业工具。这本书向经典的《设计模式》(我最喜欢的软件工程书籍之一)致敬,后者在 1990 年代为面向对象编程带来了秩序。

Gulli 引入了 21 种基本模式,它们构成了可靠智能体系统的构建模块。这些都是决定智能体如何思考、记忆和行动的实用工程结构。"当然,拥有最先进的技术很重要,但你需要退一步,思考驱动 AI 系统的基本原理,"Gulli 说,"这些模式是提升解决方案质量的工程基础。"

企业生存工具包

对于希望稳定其 AI 技术栈的企业领导者,Gulli 指出了五种"唾手可得"、能带来最直接效益的模式:反思、路由、通信、护栏和记忆。

智能体设计中最关键的转变是从简单的"刺激-反应"机器人,转向具备反思能力的系统。标准的 LLM 会立即尝试回答查询,这常常导致幻觉。而一个具备反思能力的智能体会模仿人类的推理过程:先制定计划,执行计划,然后自我评估输出结果,最后才呈现给用户。这个内部的反馈循环通常是错误答案与正确答案之间的分水岭。

当智能体具备思考能力后,它需要保持高效。这时,路由对于成本控制变得至关重要。路由层分析请求的复杂性,而不是将所有查询都发送给庞大而昂贵的"上帝模型"。简单任务被导向更快、更便宜的模型,而复杂的推理则留给重型模型处理。这种架构允许企业在不超出推理预算的情况下进行扩展。"一个模型可以充当路由到其他模型,甚至是同一模型但使用不同系统提示和功能的路由器,"Gulli 说。

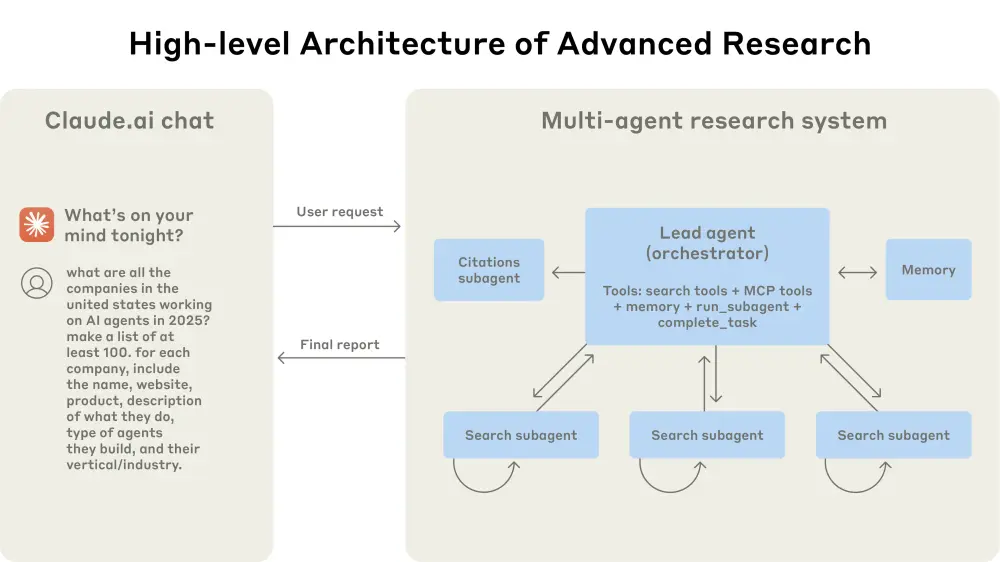

将智能体连接到外部世界需要标准化的通信,即为模型提供访问工具的能力,如搜索、查询和代码执行。过去,将 LLM 连接到数据库意味着编写脆弱、定制的代码。Gulli 指出模型上下文协议(MCP) 的兴起是一个关键时刻。MCP 就像 AI 的 USB 接口,为智能体接入数据源和工具提供了标准化的方式。这种标准化也扩展到"智能体对智能体"通信,允许专业智能体在复杂任务上协作,而无需定制集成的开销。

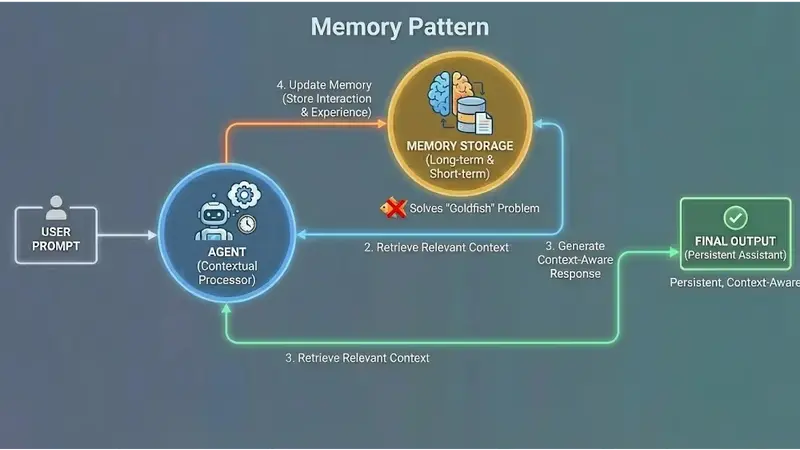

然而,即使一个智能体既聪明又高效,如果它无法保留信息,也是无用的。记忆模式解决了"金鱼"问题——智能体在长对话中忘记之前的指令。通过构建智能体存储和检索过去互动与经验的方式,开发者可以创建持久的、具备上下文感知能力的助手。"创建记忆的方式对于智能体的质量至关重要,"Gulli 说。

最后,如果智能体本身是个安全隐患,那么这一切都毫无意义。护栏提供了必要的约束,确保智能体在安全和合规的边界内运行。这不仅仅是简单的系统提示,要求模型"友好";它涉及架构上的检查和升级策略,以防止数据泄露或未经授权的操作。Gulli 强调,为安全起见,定义这些"硬"边界"极其重要",可以确保一个想要帮忙的智能体不会意外暴露私人数据或在授权范围之外执行不可逆的命令。

用事务安全性解决可靠性问题

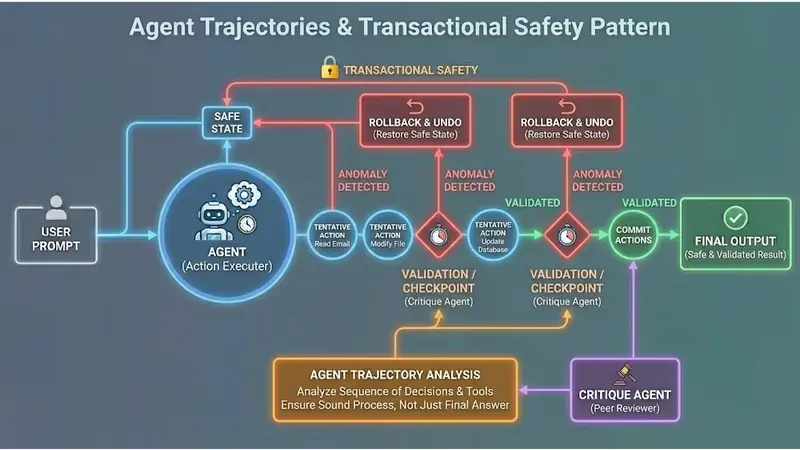

对于许多 CIO 来说,对部署智能体的犹豫源于恐惧。一个能够读取电子邮件或修改文件的自主智能体一旦失控,将构成重大风险。Gulli 通过借鉴数据库管理中的一个概念来解决这个问题:事务安全性。"如果智能体采取行动,我们必须实施检查点和回滚机制,就像我们在数据库的事务安全性中所做的那样,"Gulli 说。

在这种模型中,智能体的行动在验证之前都是试探性的。如果系统检测到异常或错误,它可以"回滚"到先前安全的状态,撤销智能体的操作。这种安全网使企业能够信任那些对系统有写入权限的智能体,因为他们知道有一个撤销按钮。

测试这些系统也需要新的方法。传统的单元测试检查函数是否返回正确的值,但智能体可能通过一个有缺陷的危险过程得出正确答案。Gulli 主张评估智能体轨迹,即评估智能体随时间推移的行为指标。"这涉及分析得出结论所使用的整个决策序列和工具,确保整个过程是可靠的,而不仅仅是最终答案,"他说。

这通常与批评模式结合使用,即由一个独立的、专门的智能体来评判主智能体的表现。这种相互制衡对于防止错误传播至关重要,实质上为 AI 决策创建了一个自动化的同行评审系统。

面向未来:从提示工程到上下文工程

展望 2026 年,单一、通用模型的时代可能即将结束。Gulli 预测,未来将是由专门化智能体舰队主导的格局。"我坚信我们将看到智能体的专业化,"他说,"模型仍然是大脑……但智能体将变成真正的多智能体系统,承担专门任务——专注于检索、图像生成、视频创作的智能体——彼此通信。"

在这样的未来,开发者的主要技能将不再是使用巧妙的措辞和提示工程来诱导模型工作。相反,他们需要专注于上下文工程,这是一门专注于设计信息流、管理状态以及筛选模型"看到"的上下文的学科。

这是从语言技巧到系统工程的转变。通过采用这些模式并关注 AI 的"管道系统"而不仅仅是模型,企业最终能够弥合炒作与实际效益之间的鸿沟。"我们不应只是为了 AI 而使用 AI,"Gulli 警告说,"我们必须从一个明确的商业问题定义开始,思考如何最好地利用技术来解决它。"(来源)

相关文章