Meta AI近日推出 Segment Anything 模型家族的全新成员——SAM 3D,这是首个具备常识级 3D 理解能力的模型,可直接将普通 2D 照片转化为细节丰富的 3D 重建结果。此次发布包含两大核心模型(物体/场景重建、人体姿态与体型估计),同步开源训练数据、模型权重、推理代码及评测基准,并上线线上交互平台,更已落地 Facebook Marketplace 家居预览功能,全面打通“技术研发-生态开放-商业应用”链路。

- 项目主页:https://ai.meta.com/sam3d

- Demo:https://www.aidemos.meta.com/segment-anything/editor/convert-image-to-3d

- SAM 3D Objects:https://github.com/facebookresearch/sam-3d-objects

- SAM 3D Body:https://github.com/facebookresearch/sam-3d-body

无论是 AR/VR 开发者、游戏资产创作者,还是科研人员,SAM 3D 都提供了全新的视觉世界交互方式,为机器人、互动媒体、运动医学等领域带来新的想象空间。

核心产品矩阵:两大模型覆盖物体与人体3D重建

SAM 3D 并非单一模型,而是针对不同场景优化的双产品组合,均达到当前行业顶尖水平:

1. SAM 3D Objects:单图生成可交互3D物体/场景

专注于从单张自然图像中重建带纹理的 3D 物体与场景布局,支持姿态估计与高品质形状恢复。即使面对小物体、遮挡、侧面视角等复杂情况,模型也能结合上下文常识补全细节。用户只需在照片中框选目标物体,几秒内即可生成可旋转、可单独操作的 3D 模型。

其核心突破在于解决了真实世界 3D 重建的数据瓶颈:

- 创新数据标注引擎:采用“模型在环”模式,让标注员对多模型生成的候选网格打分排序,难样本由专业 3D 艺术家补全,最终标注近 100 万张真实世界图像,生成 314 万条网格数据;

- 多阶段训练范式:以合成数据完成预训练,再用真实世界数据后训练,跨越“模拟到真实”的鸿沟,形成“模型变强→数据质量提升→模型再优化”的正向飞轮;

- 全新评测基准:联合艺术家打造 SA-3DAO 数据集,难度远超现有基准,推动行业从合成场景转向真实物理世界 3D 感知。

实测表现:在多项指标中大幅领先同类模型,人类偏好评测胜率至少 5:1,且通过工程优化实现秒级输出,支持机器人近实时 3D 感知需求。

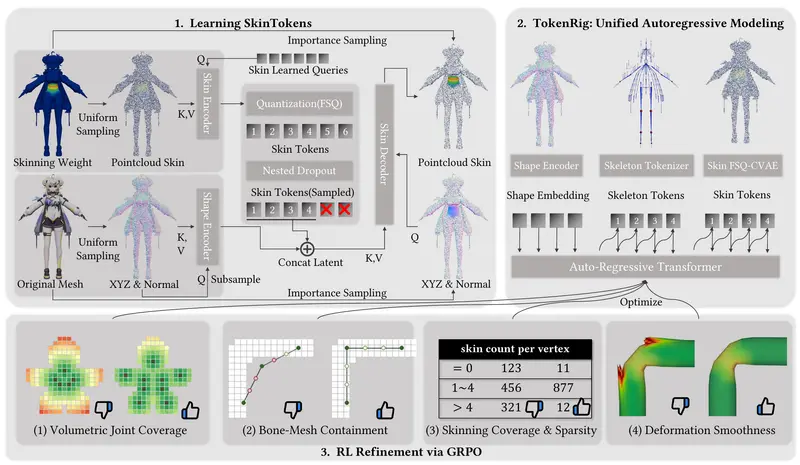

2. SAM 3D Body:极端场景下的精准人体3D重建

聚焦单张图像的 3D 人体姿态与体型估计,可应对极端姿态、严重遮挡、多人场景等复杂情况,支持通过分割掩码或 2D 关键点进行提示式交互(promptable)。

核心技术亮点:

- 开源人体网格格式:推出 Meta Momentum Human Rig (MHR),将骨骼与软组织分离,可解释性更强,已用于 Meta Codec Avatars 等技术;

- Transformer 架构+大规模训练:基于 transformer 编码-解码器,支持高分辨率局部细节捕捉;训练数据涵盖数十亿张图像、多机位视频及专业合成数据,精选 800 万张高质量样本,对遮挡、奇异姿态、多样服饰具备极强鲁棒性。

实测表现:在多项 3D 人体重建基准中大幅领先,手部姿态重建效果显著提升(虽未超越专用手部模型)。

生态开放:全工具链开源,线上Playground零门槛体验

为降低技术使用门槛,Meta 采取了全面开源策略:

- 开源模型权重、推理代码、评测基准及 MHR 参数化人体模型(宽松商业许可);

- 后续将开源 SA-3DAO 数据集,这是首个面向真实世界图像的视觉有根基 3D 重建评测集。

同时,Meta 推出 Segment Anything Playground 线上平台,任何人都可上传照片,一键选中物体或人体,瞬间生成精细 3D 模型并交互。该平台还集成了同期发布的 SAM 3(图像+视频理解升级),实现“单图 3D 重建+多模态理解”一站式体验。

商业落地:率先赋能Facebook Marketplace家居预览

SAM 3D 与 SAM 3 已快速转化为产品能力,为 Facebook Marketplace 推出“View in Room”(房间内预览)功能。用户在购买灯具、桌子等家居用品前,可上传自家房间照片,通过 3D 重建直观查看商品摆放后的真实效果,大幅提升购物决策效率。

当前局限与未来方向

尽管表现亮眼,SAM 3D 仍存在可优化空间:

- SAM 3D Objects:输出分辨率中等,复杂物体细节(如整人重建)可能失真;逐物体独立预测,未建模物体间物理接触与穿插;

- SAM 3D Body:逐人独立处理,暂未支持多人或人-物交互;手部姿态重建未超越专用模型。

未来,Meta 计划通过多物体/多人联合推理、细节分辨率优化等方向持续迭代,进一步释放 3D 理解技术的应用潜力。

相关文章