来自加州大学圣克鲁斯分校和Google Deepmind的研究人员发布论文探讨如何有效地缩减对比语言-图像预训练(CLIP)模型的规模,以适应计算资源有限的情况。研究团队从数据、架构和训练策略三个维度对CLIP进行了详细探究。在数据方面,研究人员强调了高质量训练数据的重要性,并发现高质量的较小数据集的表现往往能够超越质量较低的较大数据集。此外,研究人员还研究了不同数据集大小对模型性能的影响,发现较小的ViT模型更适合处理较小的数据集,而较大的模型在固定计算资源下更适合处理更大的数据集。

同时,研究人员也提供了关于何时选择基于CNN的架构或基于ViT的架构进行CLIP训练的指导。研究人员对比了四种CLIP训练策略——SLIP、FLIP、CLIP以及CLIP+数据增强,并发现训练策略的选择很大程度上取决于可用的计算资源。此外,研究人员的分析还揭示了一个有趣的现象:CLIP+数据增强策略仅使用一半的训练数据,就能达到与CLIP相当的性能。这一发现为如何有效训练和部署CLIP模型提供了实用的见解,使得这些模型在各种实际应用中更加易于使用和负担得起。

CLIP是一种人工智能模型,它通过学习大量的文本和图像数据,来理解和连接视觉和语言信息。例如,就像你给一个智能机器人展示一张图片,并问它图片里是什么,CLIP模型就能够理解图片内容并给出描述。总的来说,这篇论文提供了一种方法,让CLIP这样的先进模型能够在资源有限的情况下更高效地工作,这对于在手机、小型设备或者计算资源受限的环境中部署AI应用具有重要意义。

主要功能和特点:

- 数据、架构和训练策略的全面分析: 论文从三个角度探讨了如何优化CLIP模型:使用的数据质量与数量、模型的结构设计(比如选择不同的神经网络架构),以及训练方法(比如不同的训练技巧和策略)。

- 高质量小数据集的优势: 研究发现,使用较小但质量更高的数据集,可能会比使用较大但质量较低的数据集表现得更好。

- 模型性能与数据集大小的关系: 对于不同的模型大小和固定计算资源,论文分析了模型在不同数据集大小下的表现,提供了关于何时选择CNN(卷积神经网络)或ViT(视觉变换器)架构的指导。

- 训练策略的比较: 论文比较了四种CLIP训练策略,发现选择哪种策略取决于可用的计算资源。特别是,CLIP结合数据增强可以在使用一半训练数据的情况下达到与CLIP相当的性能。

工作原理:

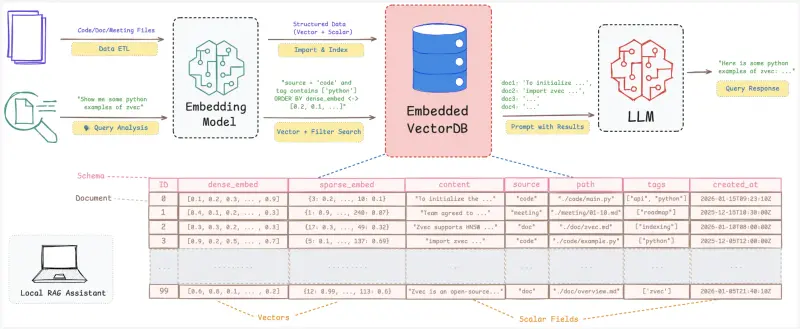

- 对比学习: CLIP模型通过对比正负样本(即匹配和不匹配的图像-文本对)来学习,调整模型使其将正样本对映射到相似的特征表示,而将负样本对映射到不同的特征表示。

- 数据增强: 为了提高模型的泛化能力,论文提出了使用数据增强技术,比如随机裁剪和翻转图像,这可以在不增加额外计算成本的情况下提高模型的性能。

具体应用场景:

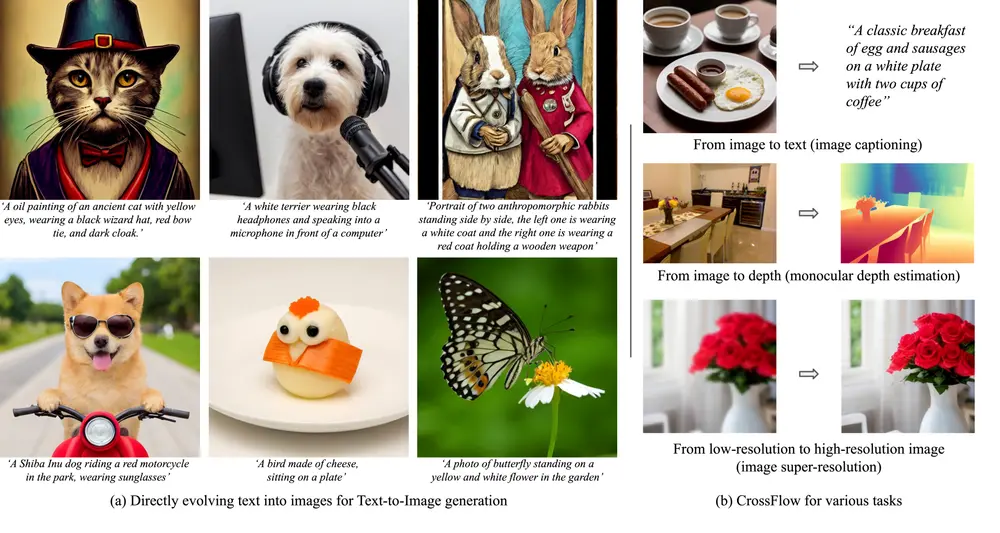

- 图像分类和描述: CLIP可以用于自动描述图片内容,帮助视觉障碍人士理解图像,或者作为社交媒体平台上的自动标签生成工具。

- 多模态学习: 在需要同时处理和理解图像和文本信息的应用中,如自动生成图像的新闻报道或社交媒体帖子的摘要,CLIP模型可以发挥重要作用。

- 智能助手和聊天机器人: 通过理解用户的图像和文本输入,智能助手可以提供更加丰富和个性化的交互体验。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...