Firefox 正在迈出其在 AI 时代的重要一步:Mozilla 已在最新版本的桌面浏览器中引入由 Google Lens 驱动的视觉搜索功能。

该功能目前仅面向桌面用户推出,允许用户通过右键点击网页中的图片或选区,直接调用 Google Lens 进行上下文识别、翻译、商品查找或相似图像搜索。

这一更新已在 Mozilla Connect 社区正式公布,标志着 Firefox 从传统文本搜索向多模态交互的演进。

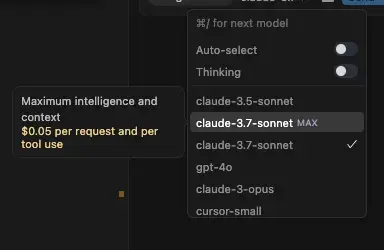

功能如何使用?

操作非常直观:

- 在 Firefox 桌面版中打开网页

- 右键点击任意图像(或使用鼠标框选局部区域)

- 选择 “使用 Google Lens 搜索图片”

- 新标签页将显示 Lens 返回的相关结果

应用场景包括:

- 识别艺术品、地标或植物

- 翻译图片中的外文文字

- 查找服装、家具等商品来源

- 获取图表或文档内容的更多信息

✅ 当前支持格式:JPEG、PNG、WebP 等常见静态图像

⚠️ 不支持视频帧内搜索或动态图(GIF)

用户可控:一项“选择加入”的功能

Mozilla 强调,此功能默认不会自动启用。用户需在首次使用时明确授权,方可激活。

这一设计延续了 Firefox 对隐私与用户自主权的核心承诺——所有涉及外部服务的功能都应由用户主动触发,而非后台静默运行。

此外,Mozilla 明确表示:

“该功能是现有搜索引擎选项的扩展,用户仍可自由切换默认搜索提供商。”

这为偏好其他服务(如 DuckDuckGo 或 Bing)的用户保留了控制权。

为什么是 Google Lens?技术策略解析

在微软 Edge 深度整合 Copilot、Safari 探索视觉智能的背景下,浏览器正逐渐成为 AI 能力的前端入口。

Mozilla 选择集成 Google Lens 而非自研方案,被视为一种务实之举:

- 快速实现功能对等:利用成熟技术填补产品差距

- 降低开发成本:集中资源于隐私保护、性能优化等核心优势领域

- 满足高频需求:视觉搜索已被证明能提升用户参与度(行业数据显示可达 15–20%)

尽管 Firefox 市场份额较小(约 2–3%),但此举有助于增强用户体验粘性,避免因功能落后而流失用户。

为何暂不支持移动端?

目前该功能仅限桌面版 Firefox,Android 和 iOS 客户端尚未上线。

这一优先级安排可能出于以下考虑:

- 桌面端图像交互更频繁(如研究、办公场景)

- 移动端已有原生系统级视觉搜索(如 Android 的 Lens 快捷方式)

- 分阶段部署便于收集社区反馈并迭代优化

Mozilla 表示,未来是否会扩展至移动平台,将取决于桌面端的使用数据与用户反馈。

隐私处理机制:数据最小化原则

在 AI 功能普遍引发数据担忧的当下,Firefox 的实现方式尤为关键。

根据官方说明:

- 图像数据不会经由 Mozilla 服务器中转

- 请求直接由客户端发送至 Google Lens API

- Mozilla 不记录用户的视觉搜索行为

虽然最终的数据处理仍受 Google 隐私政策约束,但 Firefox 的角色仅限于提供前端调用接口,自身不参与数据留存或分析。

这种“最小介入”模式,符合其长期以来倡导的隐私优先理念,也与欧盟《人工智能法案》所强调的透明与可控原则相契合。

市场反应:欢迎与质疑并存

在 Mozilla Connect 论坛及 gHacks 等科技媒体上,用户反馈呈现两极:

✅ 正面评价:

- “终于不用截图再去搜了”

- “比手动复制描述高效得多”

- “希望后续支持更多引擎”

❌ 批评声音:

- “为何又要依赖谷歌?”

- “作为反 Chrome 的选择,现在却集成其生态组件”

- “应该先完善基础体验再加新功能”

这些讨论反映出用户对 Firefox 定位的深层期待:既希望它具备现代功能,又不愿牺牲独立性与隐私底线。

未来展望:迈向多模态浏览器

视觉搜索并非孤立功能。它可能是 Firefox 向多模态交互演进的第一步。

结合 Mozilla 近期推出的 Orbit 项目(用于 AI 内容摘要的实验性附加组件),可以预见其长期方向:

- 整合文本、图像、语音等多种输入形式

- 提供统一的上下文感知搜索体验

- 在保障隐私的前提下实现智能增强

如果能在创新与原则之间找到平衡,Firefox 有望在 Chrome 占据超 60% 市场份额的格局中,重新赢得一部分重视自主权的用户。

相关文章