今日,阶跃星辰正式发布开源端到端语音大模型Step-Audio 2 mini,该模型在音频理解、语音识别、翻译及对话等多个国际基准测试集中均斩获SOTA(state-of-the-art,当前最优)成绩。目前,Step-Audio 2 mini已同步上线阶跃星辰开放平台,向开发者与行业用户开放使用。

模型下载

| 模型 | Hugging Face | ModelScope |

|---|---|---|

| Step-Audio 2 mini | stepfun-ai/Step-Audio-2-mini | stepfun-ai/Step-Audio-2-mini |

| Step-Audio 2 mini Base | stepfun-ai/Step-Audio-2-mini-Base | stepfun-ai/Step-Audio-2-mini-Base |

性能全面领跑:多测试集登顶,超越主流开源与闭源模型

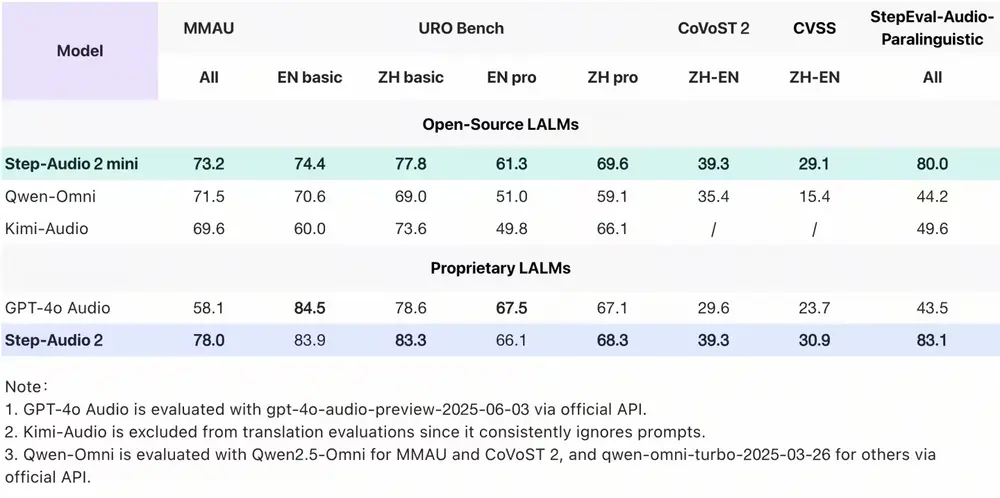

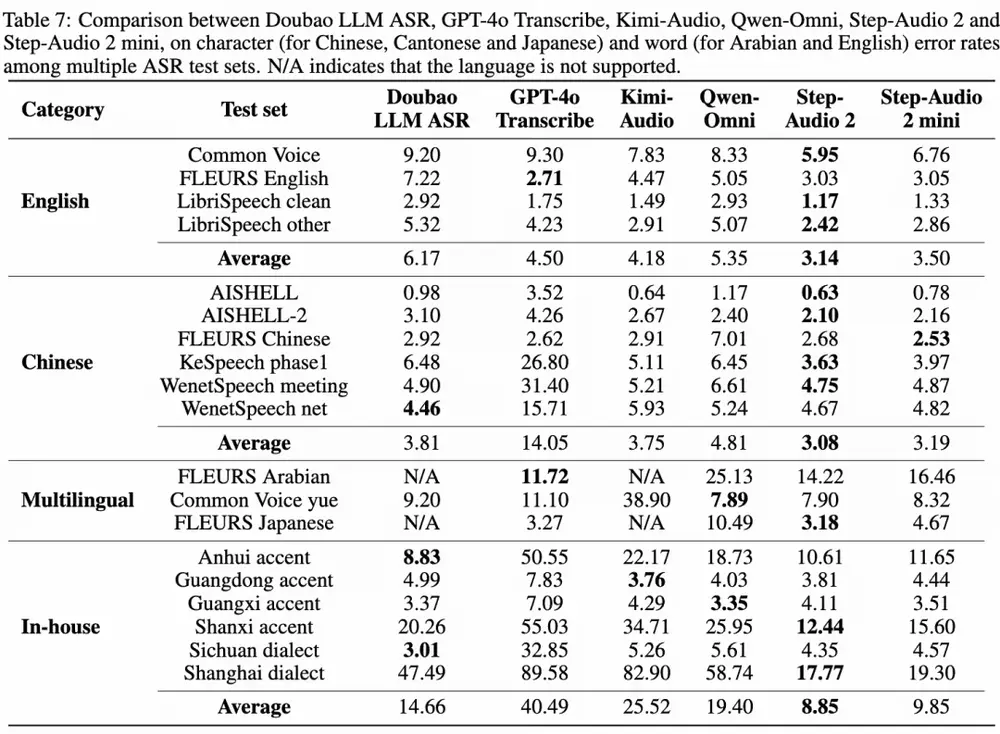

Step-Audio 2 mini的核心优势在于综合性能的全面突破,不仅超越了Qwen-Omni、Kimi-Audio等所有开源端到端语音模型,在多数任务中更实现了对GPT-4o Audio的超越。具体表现可通过四大关键基准测试集验证:

- 通用多模态音频理解(MMAU):以73.2分位列开源端到端语音模型榜首,证明其对复杂音频场景的综合理解能力;

- 口语对话能力(URO Bench):在基础与专业双赛道均拿下开源端到端语音模型最高分,展现出对日常交流、专业场景对话的精准理解与自然表达能力;

- 中英互译任务(CoVoST 2、CVSS):分别取得39.3分与29.1分,优势显著领先GPT-4o Audio及其他开源语音模型;

- 语音识别任务:多语言、多方言识别精度均居前列——中文测试集平均字错误率(CER)仅3.19,英语测试集平均词错误率(WER)低至3.50,较其他开源模型领先15%以上。

功能特性升级:统一建模+工具调用,重构语音交互体验

除了性能领先,Step-Audio 2 mini在功能设计上更聚焦“实用化”与“智能化”,核心体现在两大维度:

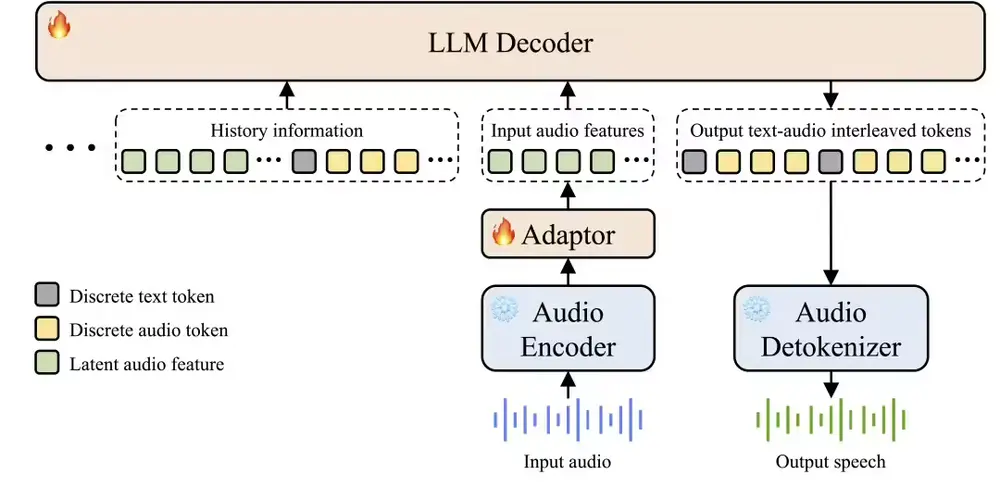

1. 统一建模:语音理解、推理与生成一体化

模型打破了传统语音交互中“语音识别(ASR)→文本大模型(LLM)→语音合成(TTS)”的三级拆分结构,实现原始音频输入到语音输出的端到端直接转换。这种设计不仅简化了架构、降低了交互时延,更能精准捕捉音频中的副语言信息(如语气、情绪)与非人声信号(如背景音、音乐),让交互更贴合真实场景。

2. 原生工具调用:支持联网拓展能力

作为率先支持语音原生Tool Calling能力的开源语音大模型,Step-Audio 2 mini可直接通过语音指令触发联网搜索等外部工具调用。这一特性不仅解决了传统语音模型“知识滞后”的问题,更让模型能灵活适配实时信息查询、场景化服务调用等复杂需求。

技术创新:直击传统语音AI“智商情商双低”痛点

过往AI语音常因两大问题被用户诟病:一是“没知识”,缺乏文本大模型的知识储备与推理能力;二是“冷冰冰”,无法理解情绪、语气等“弦外之音”。Step-Audio 2 mini通过三大技术创新实现了针对性突破:

- 真端到端多模态架构:跳过中间文本转换环节,直接对音频信号进行全流程处理,让模型能“听懂”语音中的情绪波动、语调变化,甚至背景中的环境信息;

- CoT推理+强化学习联合优化:首次在端到端语音模型中引入链式思维推理(Chain-of-Thought),结合强化学习持续优化决策逻辑,让模型不仅能“听清楚”,更能“想明白”,实现有逻辑、有层次的回应;

- 音频知识增强:通过工具调用与外部知识联动,弥补模型固有知识边界,同时减少“一本正经胡说八道”的幻觉问题,提升回答的准确性与可靠性。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...