ComfyUI-QwenImageWanBridge是一款针对ComfyUI的技术插件,核心功能是搭建Qwen-Image图像模型与WAN 2.2视频生成模型之间的“潜在空间桥接”——无需经过VAE解码/编码流程,直接将Qwen-Image输出的潜在特征传递至WAN 2.2,实现图像到视频(I2V)的生成。不过目前该方案生成效果不佳,开发者已将研究方向逐步转向文本到视频(T2V),同时列出多项待验证的技术思路,且需注意仅适配Kijai的ComfyUI-WanVideoWrapper工具。

核心定位:潜在空间直接桥接,简化I2V流程

1. 技术原理与优势

传统Qwen-Image到WAN 2.2的I2V流程需经过“Qwen生成潜在特征→VAE解码为图像→WAN VAE重新编码为潜在特征”三步,而该插件通过“潜在空间桥接”实现一步传递:

- 直接复用Qwen-Image输出的潜在表示(latent),跳过VAE解码/编码环节,减少数据损耗与计算耗时;

- 依托Qwen-Image与WAN的技术关联性(均来自阿里,WAN基于Qwen2.5-VL训练),理论上具备更好的语义对齐基础——两者VAE相似度高达99.98%,为潜在特征传递提供兼容性支撑。

2. 适用范围与依赖

该桥接方案存在明确使用限制:

- 仅适配工具:必须搭配Kijai开发的ComfyUI-WanVideoWrapper插件使用,无法对接其他WAN 2.2的ComfyUI集成工具;

- 场景局限:当前核心支持I2V生成,后续转向T2V的研究仍处于思路阶段,暂未落地功能。

当前进展:部分可用但效果有限,研究方向转向T2V

1. 现有方案的“可行之处”

尽管效果不佳,插件仍实现了部分核心技术目标,为后续优化提供基础:

- 时间连贯性:能生成短时长、时间维度连贯的视频(目前帧数较短,需从小帧数测试);

- 内容保留:在潜在空间传递过程中,可保留Qwen-Image生成图像的核心内容(如主体物体、场景结构),并成功传递至WAN生成的视频中;

- 流程简化:无需VAE解码/编码,缩短I2V生成链路,降低操作复杂度。

2. 核心局限与技术瓶颈

当前方案的问题集中在“生成质量”与“技术不确定性”,主要包括:

- 输出质量下降:生成视频分辨率低,画面细节模糊,推测与“Qwen和WAN潜在分布差异”“分辨率不匹配”“噪声特征不一致”等因素相关,具体变量仍需测试验证;

- 技术可行性存疑:开发者明确表示“可能根本无法奏效”,核心原因是I2V模型对潜在特征的精度极为敏感——即便Qwen与WAN的VAE相似度达99.98%,微小的潜在分布差异仍会导致生成质量大幅下滑;

- 工作流不完善:虽可搭建“Qwen-Image→桥接节点→WanVideoSampler”的基础链路,但Qwen-Image输出需手动重缩放以匹配WAN输入尺寸,暂无自动化适配方案。

3. 研究方向调整:从I2V转向T2V

由于I2V方案进展受限,开发者已将重点转向文本到视频(T2V),并提出三项待验证的技术思路:

- 文本嵌入对齐:尝试将qwen2.5-vl的提示嵌入(prompt embeddings)与umt5-xxl的提示嵌入进行对齐,强化文本指令对视频生成的引导性;

- 结合图像潜在表示:在T2V流程中融入Qwen-Image生成的潜在特征,探索“文本+图像特征”双输入的生成模式;

- V2V帧处理测试:计划在81帧视频到视频(V2V)生成中,对前80帧添加噪声或置零,验证帧间噪声传递对生成质量的影响。

技术思考:待解决的4个核心问题

开发者在研究中提出多项关键技术疑问,目前尚未找到明确答案,也是后续优化的重点方向:

- 帧噪声逻辑:第0帧(输入图像对应的潜在帧)不应包含噪声,但后续第0+n帧需“默认第0帧存在噪声”并启动去噪流程,如何在技术上实现这种“认知差异”的逻辑?

- 噪声预测可能性:若成功对齐qwen2.5-vl与umt5-xxl的文本嵌入,能否反向预测第0帧生成所需的噪声特征,以匹配WAN的去噪逻辑?

- 无I2V的帧生成:若直接以第0帧作为输入图像(不启用I2V模式),如何让WAN自主生成后续第0+n帧,同时保证内容连贯性?

- V2V模式适配:当前场景下能否直接启用V2V(视频到视频)生成,或通过技术手段模拟V2V流程,提升帧间连贯性?

使用指南:安装、工作流与推荐设置

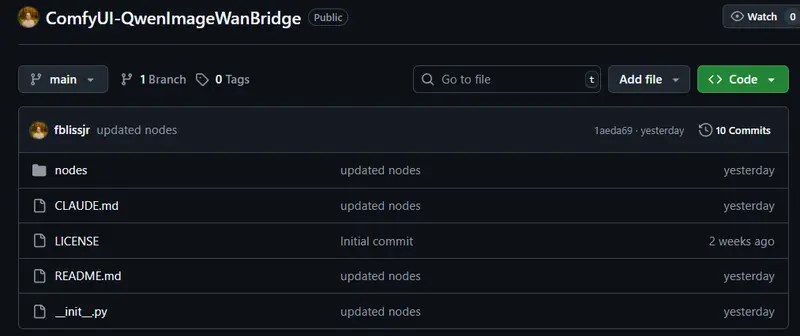

1. 安装步骤(仅支持ComfyUI)

需通过命令行克隆仓库至ComfyUI的自定义节点目录,具体操作如下:

# 进入ComfyUI自定义节点文件夹

cd ComfyUI/custom_nodes

# 克隆插件仓库(需替换为实际仓库地址)

git clone [插件仓库URL] ComfyUI-QwenImageWanBridge

克隆完成后,重启ComfyUI即可在节点列表中找到插件相关节点。

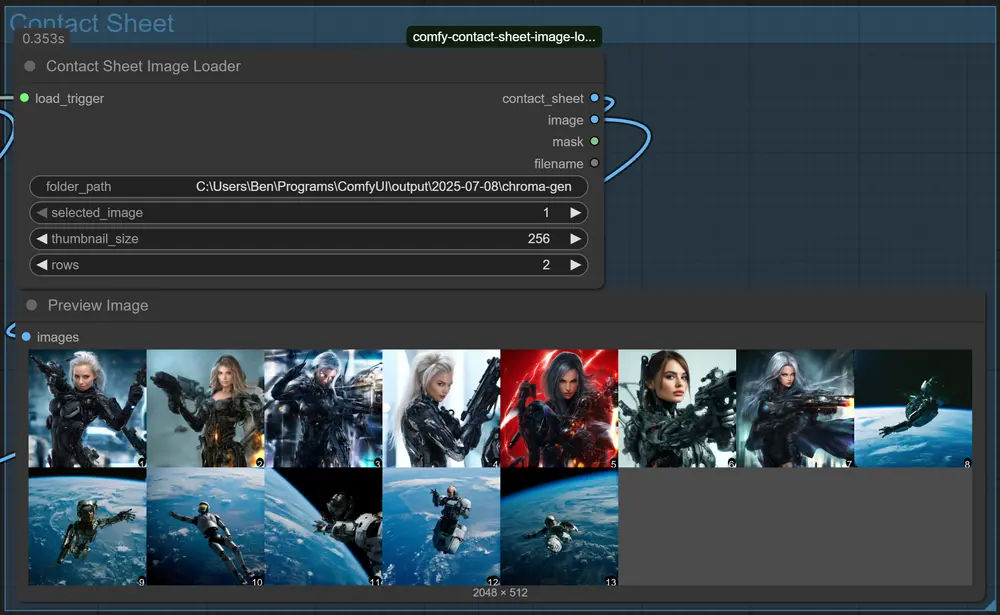

2. 基础工作流

需严格遵循“Qwen-Image→桥接节点→WAN采样器→解码”的链路,具体流程如下:

Qwen-Image(生成图像潜在特征)

→ QwenWANPureBridge(主桥接节点,mode设为"both"支持I2V/V2V)

→ WanVideoSampler(WAN视频采样器)

→ WanVideoDecode(WAN视频解码,输出最终视频)

3. 推荐参数设置

参数配置对生成效果影响极大,开发者提供基础优化参数,建议从以下设置开始测试:

| 节点类型 | 参数名 | 推荐值 | 说明 |

|---|---|---|---|

| 桥接节点(Bridge) | width | 832 | 输出视频宽度,需匹配WAN模型输入要求 |

| height | 480 | 输出视频高度,与宽度形成固定比例 | |

| num_frames | 9 | 生成帧数,建议从小帧数开始测试稳定性 | |

| mode | "both" | 同时支持I2V和V2V模式 | |

| 采样器(Sampler) | denoise | 0.3 | 去噪强度,低数值可更好保留Qwen图像特征 |

| cfg | 4.0 | 文本引导强度,过高易导致画面扭曲 | |

| steps | 15 | 采样步数,平衡生成速度与细节 | |

| sampler | "DPM-Solver++" | 采样器类型,该类型对I2V兼容性较好 |

4. 可用节点说明

插件包含4个核心节点,功能各有侧重,可根据需求选择:

QwenWANPureBridge:主桥接节点,功能简洁,专注潜在特征直接传递;QwenWANSemanticBridge:替代桥接节点,具备更优的重缩放能力,适合Qwen与WAN分辨率不匹配场景;QwenWANDimensionHelper:尺寸辅助节点,自动计算Qwen-Image输出与WAN输入的最佳匹配尺寸;QwenWANMappingAnalyzer:诊断节点,用于分析潜在特征在传递过程中的映射关系,辅助定位质量下降原因。

5. 研究功能与生产环境替代方案

- 研究功能启用:若需测试未成熟的研究性节点,可在插件的

__init__.py文件中设置LOAD_RESEARCH_NODES = True,启用额外实验性功能; - 生产环境建议:当前桥接方案不适合高质量生成,开发者推荐传统VAE流程:

Qwen-Image→VAE解码为图像→WAN VAE编码为潜在特征→WAN采样器,虽流程更长,但生成质量更稳定。

© 版权声明

文章版权归作者所有,未经允许请勿转载。

相关文章

暂无评论...