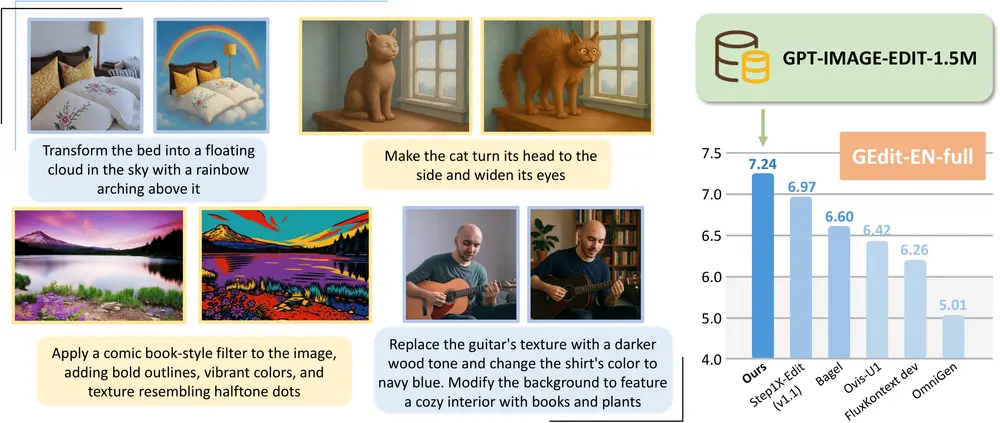

在图像生成领域,闭源模型如 GPT-4o、IDEF-2 和 DALL·E 3 已展现出令人惊叹的指令遵循能力,能够精准执行复杂的文本引导编辑任务。相比之下,开源社区虽有进展,却始终受限于高质量、大规模训练数据的缺失。

为弥合这一差距,加州大学圣克鲁兹分校、爱丁堡大学与 Adobe 联合推出 GPT-IMAGE-EDIT-1.5M——一个迄今为止最大规模、最高质量的开源图像编辑数据集,包含超过 150 万个高质量三元组:{指令, 源图像, 编辑后图像}。

- 项目主页:https://ucsc-vlaa.github.io/GPT-Image-Edit

- GitHub:https://github.com/wyhlovecpp/GPT-Image-Edit

- 模型&数据:https://huggingface.co/collections/UCSC-VLAA/gpt-image-edit-15m-6887f086840e44073995d78a

该数据集不仅规模庞大,更通过 GPT-4o 对现有数据进行系统性重构,在视觉质量、语义对齐和指令一致性上实现了全面提升,为开源图像编辑模型的发展提供了坚实基础。

- [2025.07.30] 研究团队上传了基准测试结果和仅用于微调的 FluxKontext T5 模型。

- [2025.07.27] 研究团队发布了 GPT-Image-Edit,一个包含 150 万高质量编辑样本的最先进图像编辑模型。所有数据、模型、训练代码和评估代码均已开源。此模型是基于UniWorld-V1。

为什么需要 GPT-IMAGE-EDIT-1.5M?

当前主流的图像编辑模型依赖于人工标注或弱监督生成的数据,普遍存在三大问题:

- 指令与输出不一致:生成图像未能准确反映编辑指令;

- 视觉质量参差:存在模糊、畸变或伪影;

- 语义表达不清:原始提示词冗长、歧义或结构混乱。

这些问题严重制约了模型的训练效果,导致其在复杂编辑任务中表现不佳。

GPT-IMAGE-EDIT-1.5M 的目标,正是通过以强模型(GPT-4o)重构弱数据的方式,打造一个可信赖的高质量基准。

数据构建方法:用 GPT-4o 重塑三大数据集

研究团队整合并优化了三个现有流行数据集:OmniEdit、HQ-Edit 和 UltraEdit,通过以下两个核心步骤进行重构:

1. 重新生成输出图像:提升视觉质量与指令对齐

原始数据中的编辑图像多由早期模型生成,质量有限。团队利用 GPT-4o 的多模态能力,将原始指令和源图像输入模型,重新生成编辑结果。

这一过程确保:

- 图像分辨率更高、细节更丰富;

- 更好地遵循空间、语义和风格指令;

- 减少结构错误与视觉伪影。

✅ 示例:指令“把狗变成穿着宇航服的猫”在原数据中可能只改变头部,而在新数据中会完整替换全身并保持姿态自然。

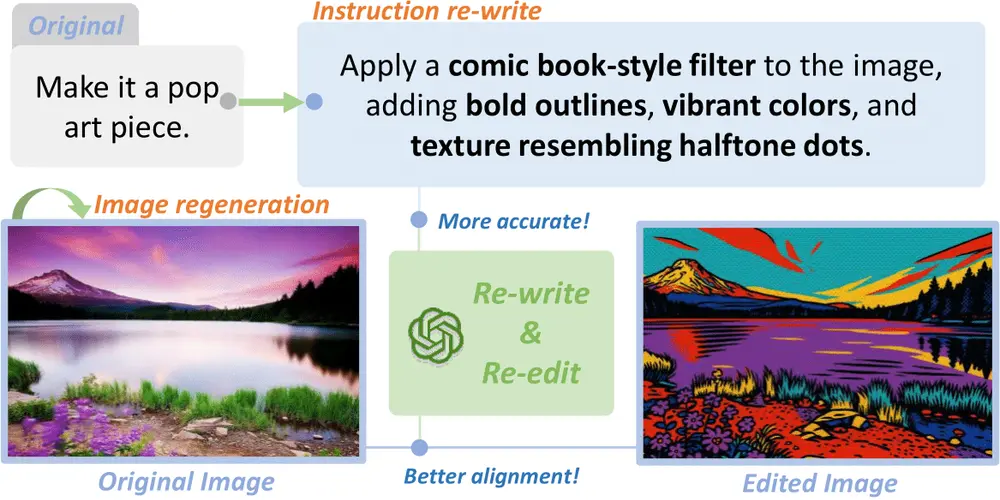

2. 选择性重写指令:增强语义清晰度

许多原始指令存在表达模糊、语法错误或信息冗余问题。团队使用 GPT-4o 对提示词进行语义保留的重写,使其更简洁、明确且易于模型理解。

例如:

- 原始指令:“make the sky more blue and a bit brighter maybe”

- 优化后:“Change the sky to a vivid blue and increase brightness by 20%”

这种标准化处理显著提升了指令与图像之间的对齐度。

数据集特点:高质量、多样化、可复现

| 特性 | 说明 |

|---|---|

| 规模 | 超过 150 万条三元组,覆盖广泛场景 |

| 质量 | 所有编辑图像由 GPT-4o 生成,视觉保真度高 |

| 多样性 | 包含颜色调整、物体替换、风格迁移、组合编辑等多种任务 |

| 复杂性 | 支持多步、多对象、跨模态的复杂编辑指令 |

| 开源性 | 全部数据、代码、训练脚本与微调模型均已公开 |

实验验证:显著缩小与闭源模型的差距

为了验证数据集的有效性,研究人员在 GPT-IMAGE-EDIT-1.5M 上微调了当前先进的开源模型 FluxKontext dev,并在多个权威基准上进行测试。

结果表明,微调后的模型在指令遵循、感知质量和身份保持方面均取得突破性进展:

主要测试结果汇总

| 基准测试 | 指标 | 微调模型得分 | 对比表现 |

|---|---|---|---|

| GEdit-EN-full | 平均得分 | 7.24 | 超越所有现有开源方法 |

| ImgEdit-Full | 整体得分 | 3.80 | 显著优于基线模型 |

| Complex-Edit (C8) | IF (指令遵循) | 8.99 | 接近人类水平 |

| IP (身份保持) | 8.41 | 优于多数专有模型 | |

| PQ (感知质量) | 8.93 | 视觉自然度高 | |

| 总分 | 8.78 | 当前开源最佳 | |

| OmniContext (SINGLE) | 平均得分 | 7.99 | 接近 GPT-4o 的 8.95 |

这些结果证明,高质量数据本身就能极大提升模型能力。经过该数据集训练的开源模型,已能在多项任务上逼近甚至媲美闭源系统。

技术路径:条件对齐与模型微调

在训练过程中,团队采用以下关键技术:

- 使用 Qwen-VL-7B 提取指令嵌入,增强文本-图像对齐;

- 设计分层损失函数,平衡编辑精度与原始内容保留;

- 引入身份一致性约束,防止过度修改非目标区域。

整个训练流程完全开源,支持复现与二次开发。

相关文章